Entfesseln Sie Hochleistungs-Maschinenlernen: Mieten Sie AWS-GPUs für Ihre Modellentrainingsbedürfnisse.

Most people like

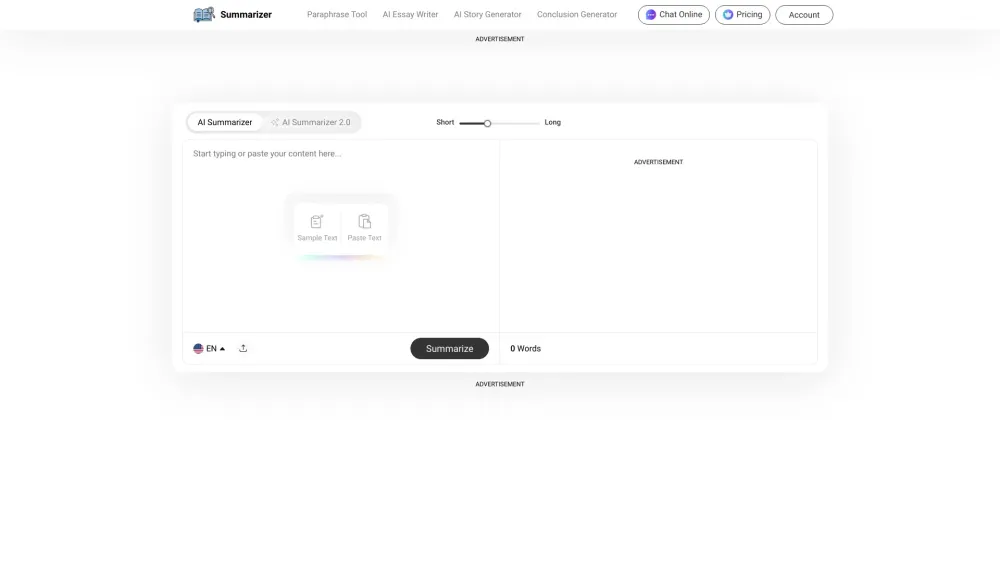

Erstellen Sie mühelos prägnante Zusammenfassungen für jeden Text mit unserem kostenlosen Zusammenfassungs-Generator. Egal, ob Sie lange Artikel, Forschungsarbeiten oder Essays zusammenfassen möchten, dieses Tool vereinfacht den Prozess und liefert in Sekundenschnelle klare und informative Zusammenfassungen. Steigern Sie Ihre Produktivität und Ihr Verständnis, indem Sie unsere benutzerfreundliche Lösung für all Ihre Zusammenfassungsbedürfnisse nutzen.

Präsentieren Sie unseren fortschrittlichen KI-Marketing-Bot, der entwickelt wurde, um Ihre Social-Media-Strategie durch mühelose Produktintegration zu optimieren. Dieses innovative Tool strafft Ihre Marketingaktivitäten, sodass Sie Ihr Publikum effektiver ansprechen und gleichzeitig Werbeaufgaben automatisieren können. Steigern Sie Ihre Online-Präsenz und fördern Sie Konversionen mit unserer KI-gesteuerten Lösung, die die Integration Ihrer Produkte auf verschiedenen sozialen Plattformen vereinfacht. Entdecken Sie noch heute, wie unser KI-Marketing-Bot Ihr Social-Media-Marketing transformieren kann!

Entdecken Sie Air Fry AI, Ihre Anlaufstelle für fachmännisch erstellte Anleitungen und Rezepte für die Heißluftfritteuse, unterstützt durch künstliche Intelligenz.

Revolutionieren Sie Ihre Werbestrategie mit unserem modernen KI-Tool, das sofort überzeugende Werbetexte erstellt. Transformieren Sie die Art und Weise, wie Sie Marketinginhalte erzeugen, und stellen Sie sicher, dass Ihre Botschaften bei Ihrem Publikum ankommen, während Sie Zeit und Mühe sparen. Entdecken Sie die Möglichkeiten der künstlichen Intelligenz zur Erstellung effektiver Anzeigen, die die Interaktion fördern und die Konversionen steigern.

Find AI tools in YBX

Related Articles

Refresh Articles