Google präsentiert Veo: Ein beeindruckendes neues generatives KI-Video-Modell im Wettbewerb mit OpenAI’s Sora.

Most people like

Entfalte nahtlosen Zugang zu Remote-Jobmöglichkeiten und revolutioniere deine Remote-Arbeitsreise!

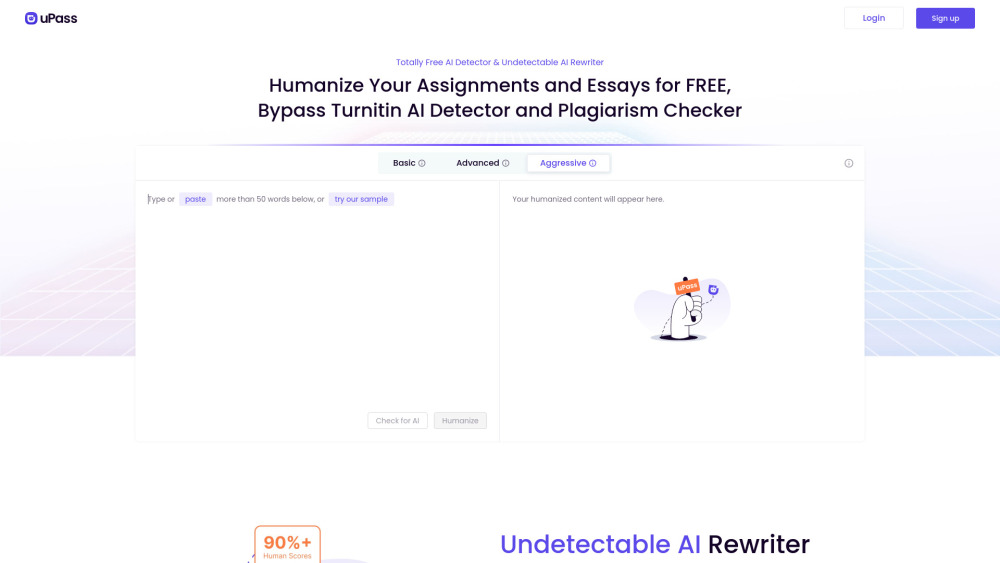

In der heutigen sich schnell entwickelnden Bildungslandschaft stehen Studierende vor besonderen Herausforderungen bei Schreibaufgaben und der Wahrung der akademischen Integrität. Mit dem Aufkommen von KI-Tools ist es entscheidend, verlässliche KI-Detektoren zu haben, die KI-generierte Inhalte identifizieren, während gleichzeitig fortschrittliche KI-Umschreiber eingesetzt werden, die es den Studierenden ermöglichen, originelle, qualitativ hochwertige Arbeiten zu erstellen, ohne erkannt zu werden. Diese leistungsstarke Kombination befähigt Lernende, ihre Schreibfähigkeiten zu verbessern und ihre akademische Integrität zu wahren, während sie sich in den komplexen Anforderungen der modernen Bildung bewegen.

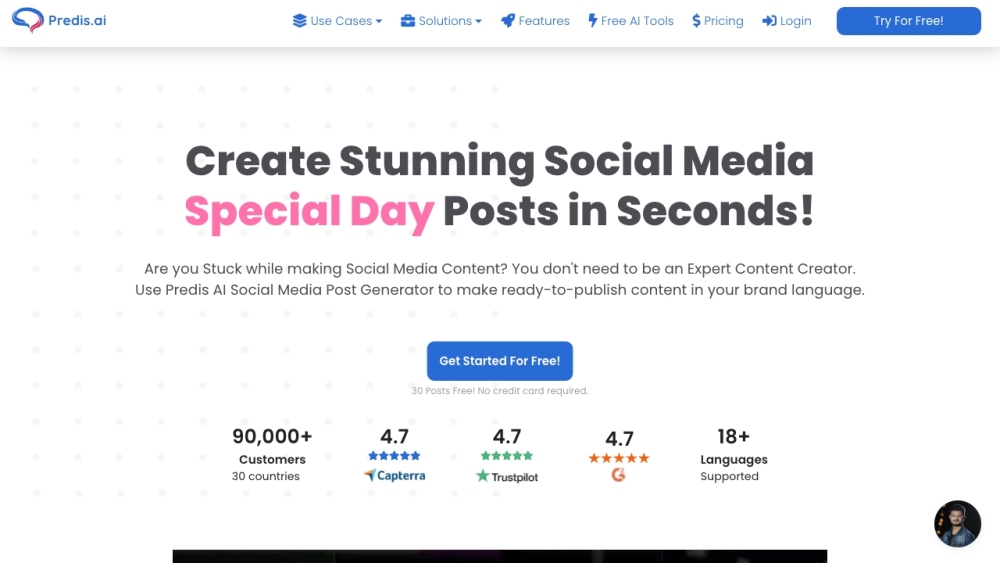

Predis.ai ist ein fortschrittliches KI-Marketing-Tool, das für soziale Medien entwickelt wurde und sich auf die Inhalts-erstellung sowie auf tiefgreifende Analysen spezialisiert. Egal, ob Sie Ihre Online-Präsenz stärken oder Ihre Marketingstrategien optimieren möchten, Predis.ai ermöglicht es Ihnen, Ihr Publikum effektiv zu erreichen.

Glasp ist ein innovativer sozialer Web-Highlighter, der darauf abzielt, Benutzern zu helfen, ihre hervorgehobenen Inhalte nahtlos zu organisieren und zu teilen. Durch die Veränderung Ihrer Interaktion mit Online-Informationen erleichtert Glasp die Verbindung zu anderen, während Sie Ihre Highlights effektiv verwalten.

Find AI tools in YBX