Könnte ein präzises Wasserzeichen-Tool für ChatGPT existieren? Die Entscheidung von OpenAI, es zurückzuhalten, erklärt

Most people like

Verbessern Sie Ihren Workflow, indem Sie Ihre Projekte mit optimaler Effizienz entwickeln, organisieren und teilen.

Verwandeln Sie Besucher in treue Kunden, indem Sie ihr Verhalten verfolgen, Daten analysieren und Conversion-Strategien optimieren.

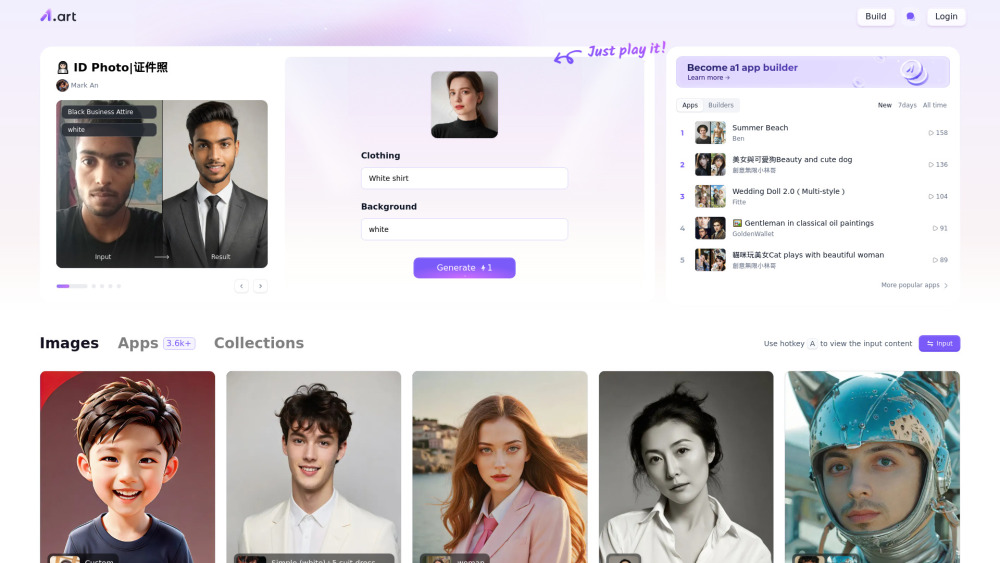

Entdecken und gestalten Sie fesselnde KI-Kunstanwendungen auf unserer Plattform. Erforschen Sie innovative Werkzeuge, die Ihre Kreativität fördern und Ihnen helfen, einzigartige künstlerische Ausdrucksformen durch künstliche Intelligenz zu entdecken. Werden Sie Teil der Gemeinschaft von KI-Kunstliebhabern und heben Sie Ihre künstlerische Reise noch heute auf ein neues Level!

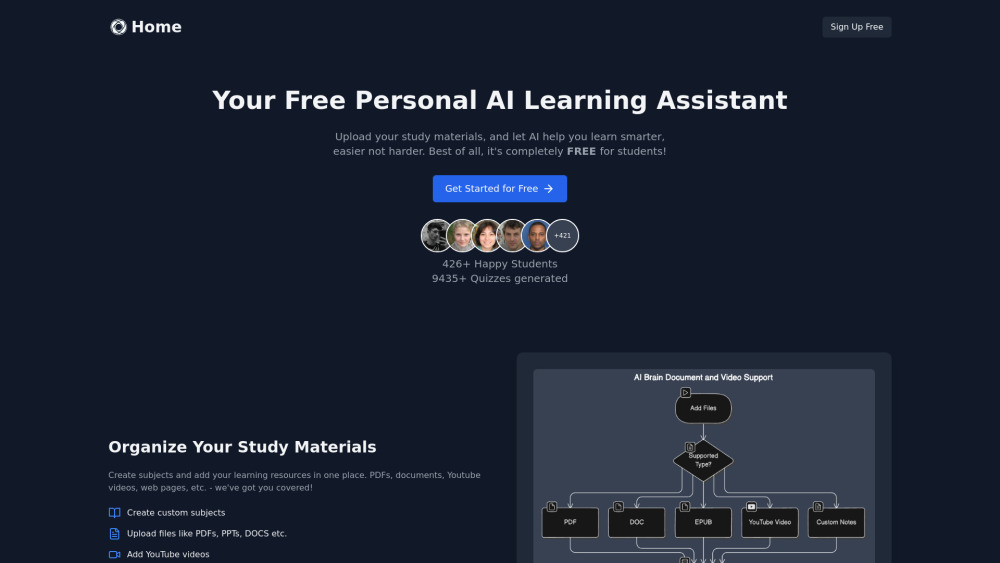

Haben Sie Schwierigkeiten, Ihre Lernmaterialien zu organisieren, oder suchen Sie nach innovativen Methoden zur Prüfungsvorbereitung? Unser KI-Studienassistent steht Ihnen zur Seite! Dieses intelligente Werkzeug organisiert nicht nur Ihre Lernressourcen effizient, sondern erstellt auch maßgeschneiderte Tests, um Ihr Lernen zu vertiefen. Nutzen Sie eine smartere Art des Lernens und verbessern Sie Ihre Prüfungsergebnisse mit dieser hochmodernen KI-Lösung.

Find AI tools in YBX