Innovation in Machine Learning und KI-Training Beschleunigt

Die Entwicklungen im Bereich des maschinellen Lernens (ML) und der künstlichen Intelligenz (KI) erleben eine rasante Evolution, insbesondere durch die Einführung anspruchsvollerer generativer KI-Aufgaben.

MLCommons hat heute den MLPerf 4.0 Trainingsbenchmark vorgestellt, der Rekordleistungen präsentiert. Dieser herstellerunabhängige Standard ist in der Branche weithin anerkannt und umfasst Beiträge von 17 Organisationen sowie über 205 Ergebnisse. Dieses Update ist das erste seit der Veröffentlichung von Version 3.1 im November 2023.

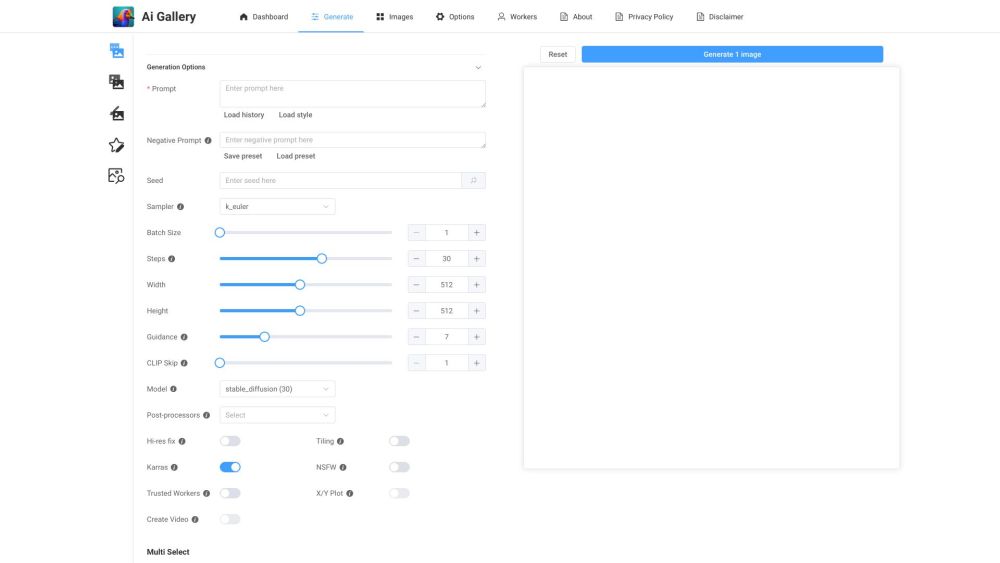

Die MLPerf 4.0 Benchmarks beinhalten bedeutende Fortschritte, darunter die Bildgenerierung mit Stable Diffusion und das Training von großen Sprachmodellen (LLM) für GPT-3. Zu den bemerkenswerten Ergebnissen gehört ein neuer LoRA-Benchmark, der das Llama 2 70B Sprachmodell für die Dokumentenzusammenfassung mit Fokus auf Parameter-Effizienz optimiert.

Im Vergleich zum letzten Zyklus sind die Fortschritte bemerkenswert. “Im Vergleich zu vor sechs Monaten weisen einige Benchmarks nahezu eine Verdopplung der Leistung auf, besonders bei Stable Diffusion,” erklärte David Kanter, Gründer und Geschäftsführer von MLCommons, während einer Pressekonferenz. “Das ist beeindruckend für nur ein halbes Jahr.”

Konkrete Zahlen zeigen, dass das Training mit Stable Diffusion im Vergleich zu November 2023 um das 1,8-fache schneller ist, während GPT-3 eine Geschwindigkeitssteigerung von bis zu 1,2-fach erreicht.

KI-Training Leistung: Über Hardware hinaus

Obwohl Hardware eine wichtige Rolle im Training von KI-Modellen spielt, sind auch Software und Netzwerkverbindungen innerhalb von Clustern entscheidend.

“Die Leistung im KI-Training hängt von verschiedenen Faktoren ab, die die Effizienz verbessern,” bemerkte Kanter. “Die Verteilung von Aufgaben und die Kommunikation zwischen mehreren Prozessoren oder Beschleunigern sind entscheidend.”

Anbieter nutzen nicht nur überlegene Halbleiter, sondern setzen auch fortschrittliche Algorithmen und Skalierung ein, um die Leistung über die Zeit zu steigern.

Nvidias Führerschaft im Training mit Hopper-Architektur

Nvidia hat sich in den MLPerf 4.0 Benchmarks hervorgetan und beeindruckende neue Leistungsrekorde in fünf von neun getesteten Workloads erzielt. Bemerkenswert dabei ist, dass diese Benchmarks hauptsächlich mit denselben zentralen Hardware-Plattformen wie im Juni 2023 erreicht wurden.

David Salvator, AI-Direktor bei Nvidia, betonte den anhaltenden Wert der H100 Hopper-Architektur. “In der Geschichte von Nvidia erreichen wir typischerweise Leistungsverbesserungen von 2x bis 2,5x dank Software-Innovationen während des Produktlebenszyklus,” erklärte er.

Nvidia hat mehrere Strategien eingesetzt, um die Leistung für MLPerf 4.0 zu steigern, darunter Full-Stack-Optimierungen, fein abgestimmte FP8-Kerne und optimierte cuDNN FlashAttention.

Die Bedeutung von MLPerf Trainingsbenchmarks für Unternehmen

MLPerf Benchmarks bieten Organisationen standardisierte Kennzahlen zur Trainingsleistung, deren Wert jedoch über reine Zahlen hinausgeht.

Salvator betonte, dass Leistungsverbesserungen mit vorhandener Hardware erzielt werden, was beweist, dass Nvidia nachhaltige Vorteile aus etablierten Architekturen ziehen kann. Bei der Planung neuer Implementierungen, insbesondere vor Ort, ist das Potenzial für anhaltende Verbesserungen nach der Erstinvestition von entscheidender Bedeutung.

“Bezüglich der Bedeutung von Leistung ist die einfache Antwort, dass sie die Kapitalrendite für Unternehmen steigert,” schloss er.