Meta stellt neue KI-Modelle für Audio, Text und Wasserzeichen-Innovationen vor.

Most people like

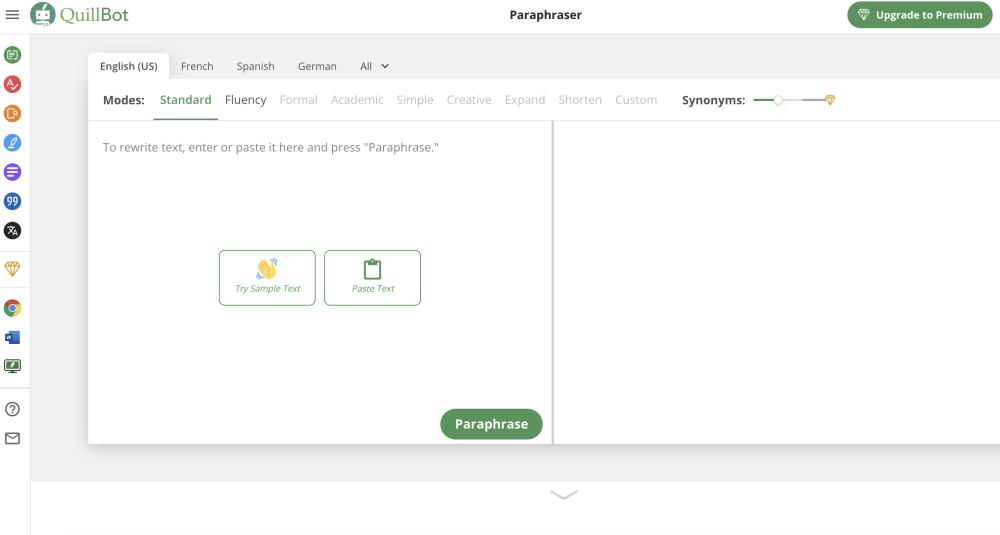

Transformieren Sie Ihr Schreiben mühelos mit diesem leistungsstarken Online-Textumformungstool. Ganz gleich, ob Sie einen Artikel neu formulieren, die Klarheit verbessern oder frische Inhalte erstellen möchten – unsere benutzerfreundliche Plattform macht das Umschreiben zum Kinderspiel. Ideal für Studenten, Profis und Content-Ersteller, hebt dieses Tool Ihr Schreiben hervor und bewahrt dabei die ursprüngliche Bedeutung. Entdecken Sie noch heute, wie einfach es ist, Ihren Text zu verbessern!

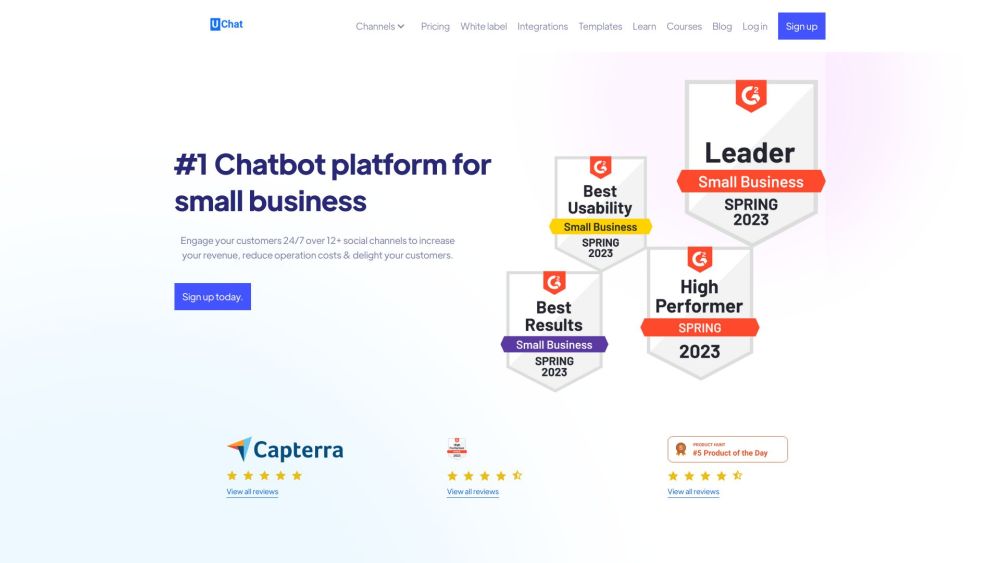

UChat ist eine innovative Chatbot-Plattform, die es Unternehmen ermöglicht, ihre Abläufe mühelos zu automatisieren, ganz ohne Programmierkenntnisse.

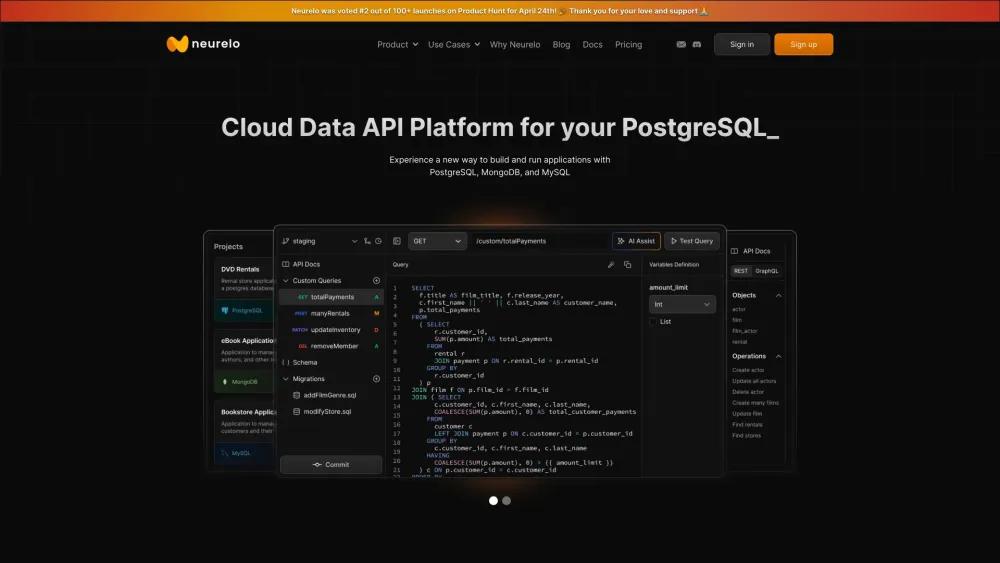

In der heutigen, datengetriebenen Welt revolutionieren KI-gesteuerte Datenbank-APIs, wie Unternehmen mit ihren Daten interagieren und diese verwalten. Durch den Einsatz künstlicher Intelligenz optimieren diese APIs die Datenabfrage, erhöhen die Genauigkeit und ermöglichen intelligentere Entscheidungsprozesse. Ideal für Entwickler und Unternehmen, optimieren KI-basierte Datenbank-APIs nicht nur die Leistung, sondern fördern auch Innovation, indem sie es Organisationen ermöglichen, das volle Potenzial ihrer Daten zu nutzen. Entdecken Sie die transformative Wirkung von KI-gesteuerten Datenbank-APIs und wie sie Ihre Datenmanagement-Strategien verbessern können.

Find AI tools in YBX

Related Articles

Refresh Articles