OpenAI-Studie Enthüllt Unerwartete Auswirkungen der KI auf die Zukunft der Entwicklung Biologischer Bedrohungen

Most people like

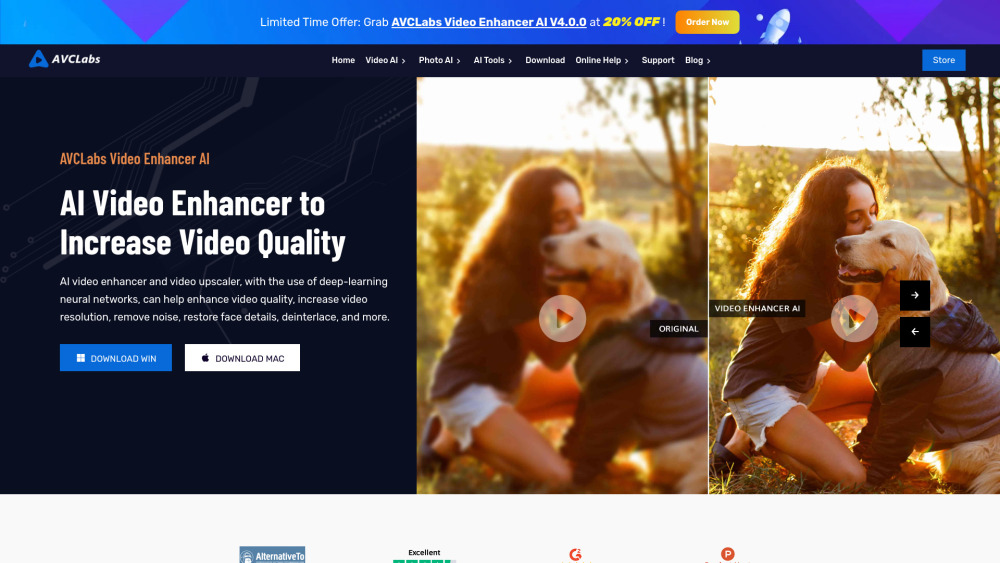

In der heutigen digitalen Ära ist die Nachfrage nach hochwertigen visuellen Inhalten enorm gestiegen, wodurch KI-Tools für Amateure und Profis gleichermaßen unverzichtbar geworden sind. Diese innovativen Technologien können die Qualität von Fotos und Videos erheblich verbessern und Ihre Inhalte auf ein neues Niveau heben. Von automatisierten Verbesserungen bis hin zu ausgeklügelten Bearbeitungsfunktionen revolutionieren KI-gestützte Lösungen die Art und Weise, wie wir visuelle Medien erstellen und teilen. Entdecken Sie, wie der Einsatz dieser modernen Werkzeuge Ihre Bilder und Videos verbessern kann, sodass sie in einer überfüllten digitalen Landschaft herausstechen.

Entfesseln Sie die Kraft des individuellen T-Shirt-Drucks mit der fortschrittlichen KI-Technologie von TeeAI. Gestalten Sie mühelos einzigartige T-Shirts und setzen Sie Ihre kreativen Ideen in die Tat um!

Verwandeln Sie Ihren Text in fesselnde Kurzvideos in nur wenigen Minuten. Egal, ob Sie Ihr Publikum in sozialen Medien ansprechen oder auffällige Clips für das Marketing erstellen möchten, wir machen den Prozess schnell und einfach. Nutzen Sie die Kraft des Videos, indem Sie schriftliche Inhalte mühelos in dynamische visuelle Geschichten umwandeln.

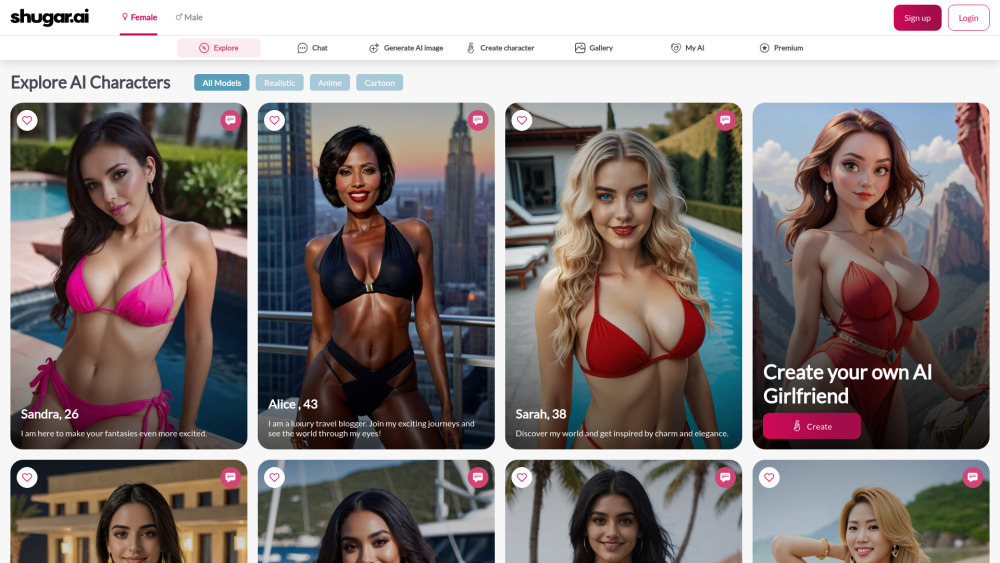

Entdecken Sie die faszinierende Welt der KI-generierten Charaktere, die für immersive interaktive Erlebnisse entworfen wurden. Diese intelligenten Kreationen revolutionieren das Geschichtenerzählen, das Gaming und virtuelle Umgebungen, indem sie den Nutzern dynamische, reaktive Interaktionen bieten. Erfahren Sie, wie künstliche Intelligenz die Charakterentwicklung verbessert und Erzählungen reicher und fesselnder macht. Entfalten Sie Kreativität in Ihren Projekten und lernen Sie, wie diese innovativen Charaktere Ihre interaktiven Erlebnisse auf neue Höhen heben können.

Find AI tools in YBX