OpenAI präsentiert Sora: Das revolutionäre Video-Generierungsmodell, das die Zukunft der Filmindustrie neu gestaltet.

Most people like

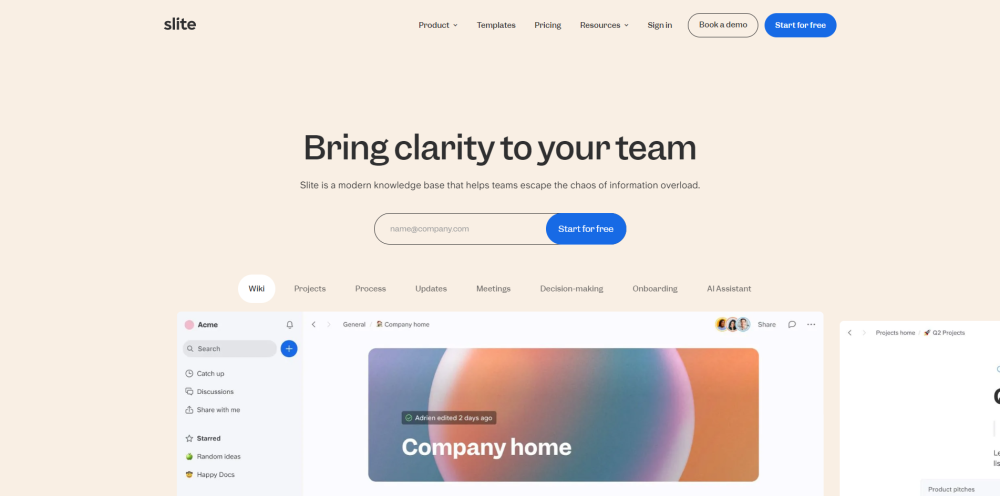

Entdecken Sie Slite, eine KI-gestützte Wissensdatenbank, die Ihnen einen nahtlosen Zugang zu zuverlässigen Unternehmensinformationen direkt zur Verfügung stellt.

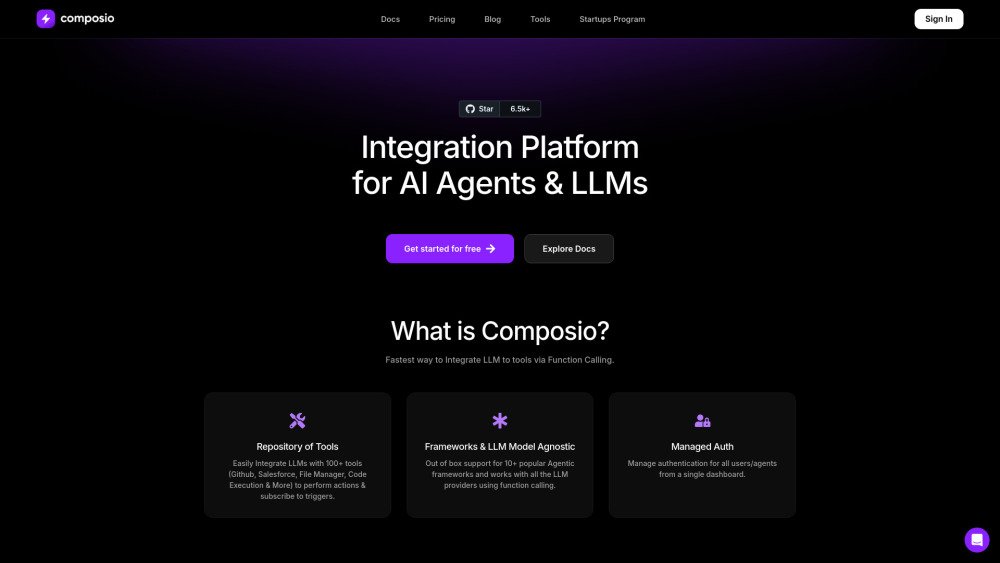

Ein innovatives Integrationsplattform, die speziell für KI-Agenten und große Sprachmodelle (LLMs) entwickelt wurde und die API-Konnektivität optimiert. Diese hochmoderne Lösung verbessert die Effizienz des Datenaustauschs und ermöglicht es Entwicklern, ihre KI-gestützten Anwendungen nahtlos zu verbinden.

Entfalte dein akademisches Potenzial mit dem ultimativen Lernwerkzeug, das speziell für Studierende entwickelt wurde. Erhalte schnelle Einblicke und fördere ein tiefes Verständnis komplexer Themen. Verbessere deine Problemlösungsfähigkeiten und beschleunige noch heute dein akademisches Wachstum!

Find AI tools in YBX

Related Articles

Refresh Articles