OpenAI's Whisper v3: Verbesserte Spracherkennungslösungen für Unternehmensanwendungen

Most people like

In der heutigen schnelllebigen digitalen Landschaft verändert Künstliche Intelligenz (KI) die Art und Weise, wie wir uns verbinden und kreieren. Durch die Steigerung der digitalen Intimität fördern KI-Werkzeuge tiefere Beziehungen und ermöglichen bedeutungsvolle Interaktionen über verschiedene Plattformen hinweg. Gleichzeitig versetzen diese Innovationen die Nutzer in die Lage, beeindruckende visuelle Inhalte zu erstellen, die das Publikum fesseln. Entdecken Sie, wie KI sowohl persönliche Verbindungen als auch kreative Ausdrucksformen im digitalen Raum transformiert.

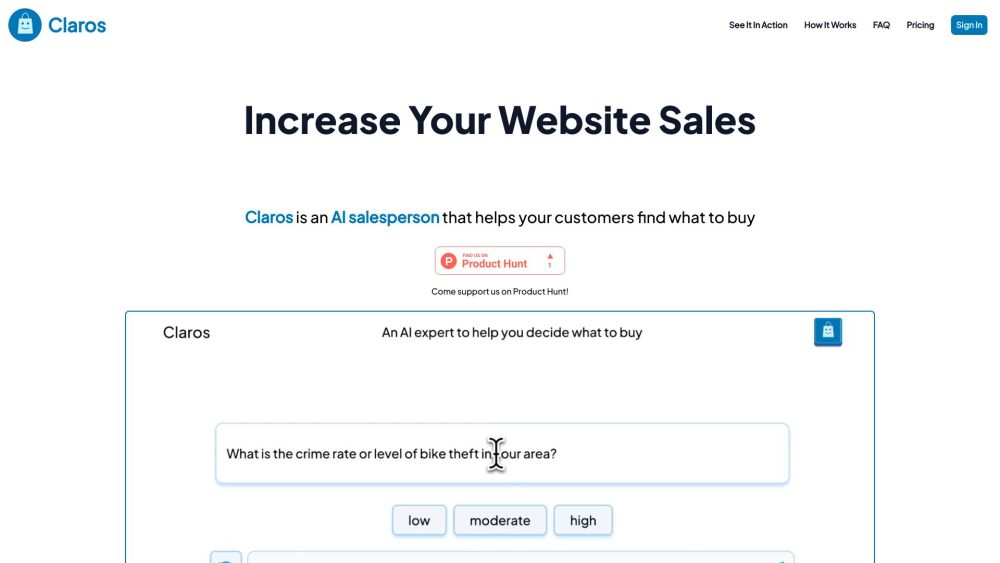

Vertrieb revolutionieren: Wie KI-Vertriebler die Kundenerlebnisse verbessern und den Umsatz steigern.

In der sich schnell entwickelnden Welt der künstlichen Intelligenz dient der KI-Kunstaufforderungs-Generator als leistungsstarkes Werkzeug für Text-zu-Bild-Modelle. Diese innovative Ressource ermöglicht es Künstlern, Designern und Kreativen, ihre Ideen mühelos in beeindruckende visuelle Kunstwerke zu verwandeln. Durch die Generierung maßgeschneiderter Aufforderungen wird die Kreativität gefördert und der künstlerische Prozess optimiert, sodass die Nutzer neue Konzepte erkunden und ihre Fantasie anregen können. Perfekt für Anfänger und erfahrene Profis bietet dieser Generator Zugang zu unendlichen künstlerischen Möglichkeiten. Begrüßen Sie die Zukunft der Kreativität mit unserem KI-Kunstaufforderungs-Generator noch heute!

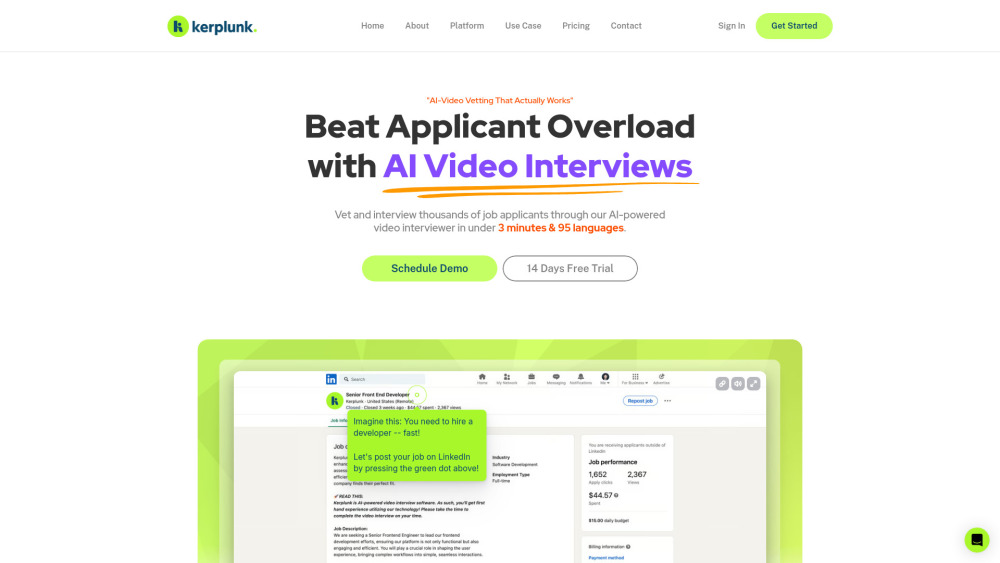

Revolutionieren Sie Ihren Einstellungsprozess mit KI-gestützten Video-Interviews

Entdecken Sie, wie ein KI-gestützter Video-Interviewer Ihr Einstellungserlebnis verändern kann, indem er den Rekrutierungsprozess effizienter und effektiver gestaltet. Durch den Einsatz von Künstlicher Intelligenz optimiert diese innovative Technologie Interviews, spart Ihnen Zeit und steigert die Einbindung sowie die Bewertung der Kandidaten. Entfalten Sie das Potenzial Ihrer Einstellungsstrategie noch heute!

Find AI tools in YBX

Related Articles

Refresh Articles