OpenAI startet eingeschränkten Zugang zum fortschrittlichen Sprachmodus von ChatGPT für mobile Nutzer

Most people like

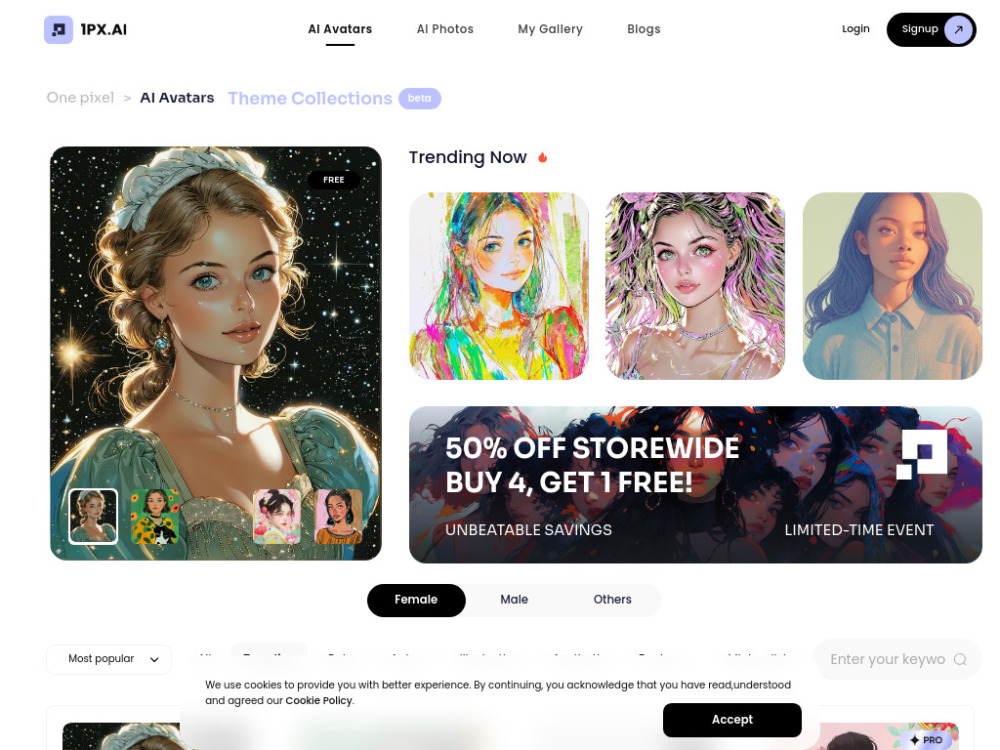

In den letzten Jahren haben KI-Porträtgeneratoren die Art und Weise, wie wir künstlerische Bilder erstellen und erleben, revolutioniert. Durch den Einsatz fortschrittlicher Algorithmen und Machine-Learning-Techniken können diese innovativen Werkzeuge in Sekundenschnelle beeindruckende digitale Porträts erzeugen. Egal, ob Sie ein Künstler sind, der nach Inspiration sucht, oder einfach nur neugierig auf die Möglichkeiten der KI sind, das Verständnis der Funktionsweise dieser Generatoren kann neue Wege für Kreativität und Ausdruck eröffnen. Dieser Leitfaden taucht ein in die faszinierende Welt der KI-Porträtgeneratoren und erkundet deren Technologie, Anwendungen und die Zukunft der digitalen Kunst.

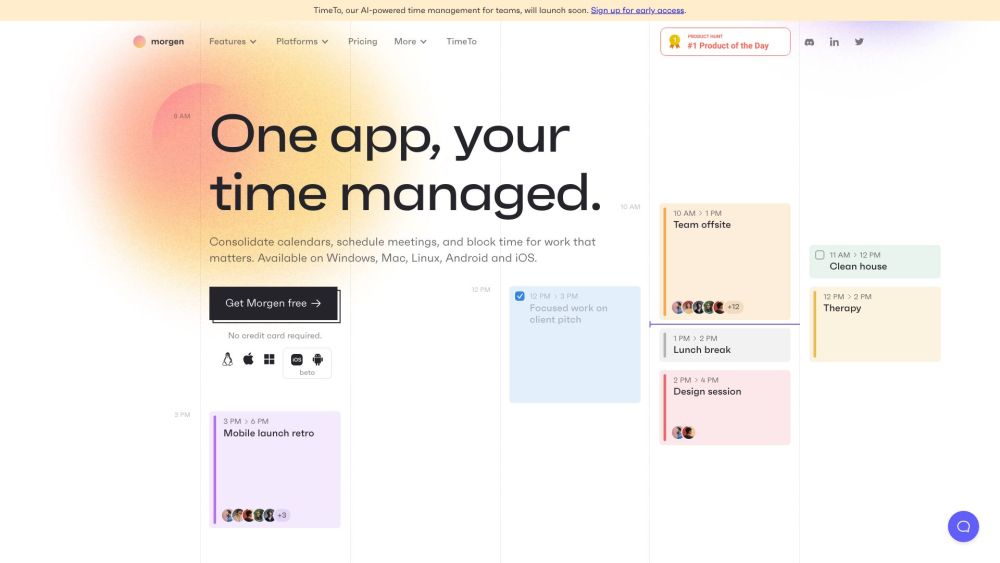

Morgen ist eine All-in-One-Plattform, die darauf ausgelegt ist, das Kalendermanagement, die Aufgabenorganisation und die Terminplanung zu optimieren. Sie ist auf all Ihren Geräten zugänglich. Ideal für Einzelpersonen und Teams, steigert Morgen die Produktivität, indem es Ihre Aufgaben und Kalender synchronisiert und so eine nahtlose Planungserfahrung bietet.

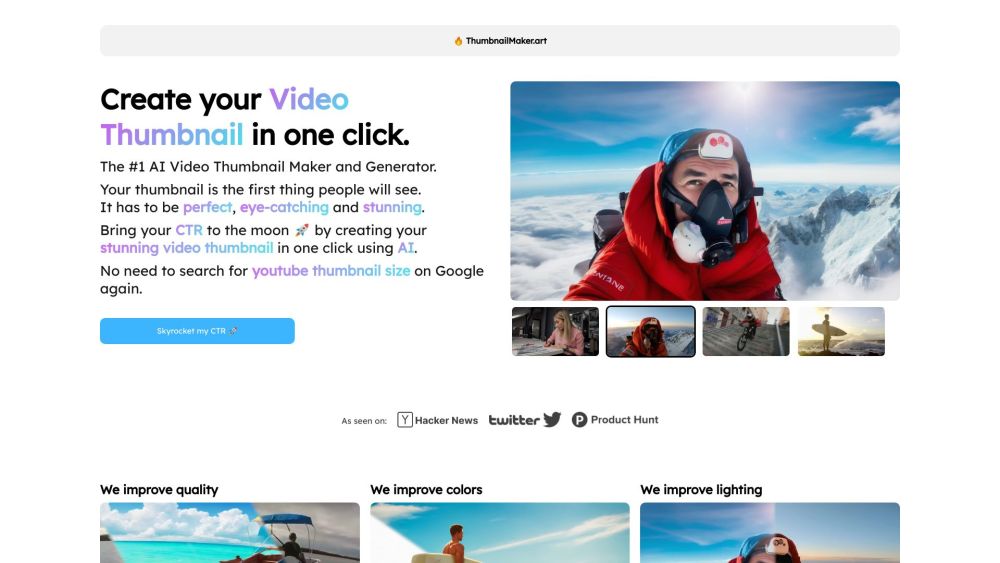

Gestalten Sie mit ThumbnailMaker ganz einfach auffällige YouTube-Thumbnails. Dieses KI-gesteuerte Tool vereinfacht Ihren kreativen Prozess.

Freshly.ai nutzt die Kraft von künstlicher Intelligenz und menschlicher Zusammenarbeit, um das volle Potenzial der KI auszuschöpfen. Durch die Verstärkung der Fähigkeiten durch diese einzigartige Synergie erzielen wir herausragende Ergebnisse, die Erwartungen übertreffen. Entdecken Sie, wie unser innovativer Ansatz Kreativität und Produktivität verwandelt.

Find AI tools in YBX

Related Articles

Refresh Articles