OpenAI und Anthropic arbeiten zusammen, um KI-Modelle mit dem U.S. AI Safety Institute zu teilen, um die Sicherheit und Überwachung zu verbessern.

Most people like

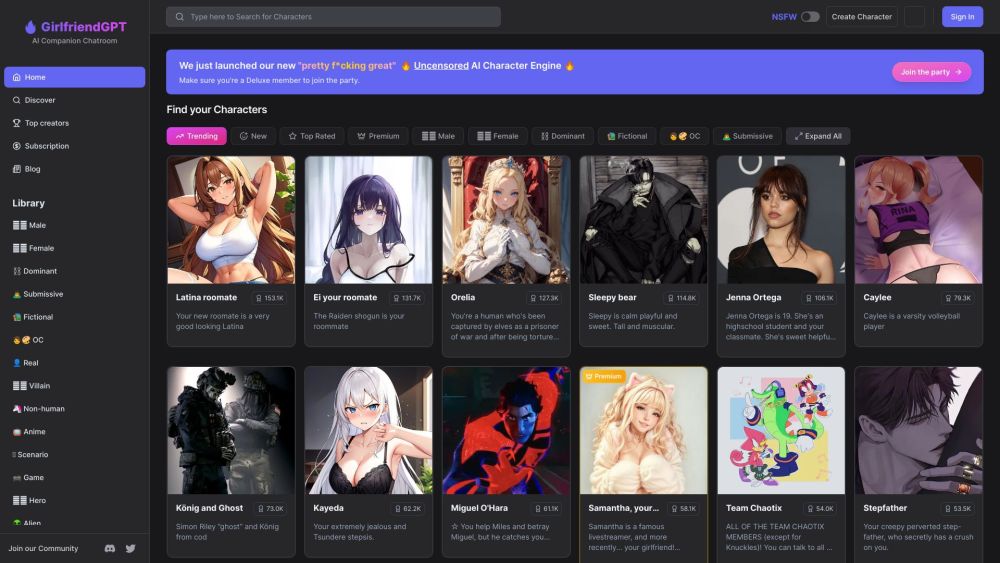

Willkommen in einem offenen und unzensierten KI-Begleiter-Chatraum, in dem Sie sowohl SFW- (safe for work) als auch NSFW- (not safe for work) Gespräche führen können. Treten Sie mit uns in einen ehrlichen Austausch, der auf Ihre Interessen zugeschnitten ist!

Entdecken Sie Sudowrite, ein innovatives KI-Schreibwerkzeug, das den Prozess der Erstellung von Romanen und Drehbüchern beschleunigt. Diese hochmoderne Lösung hat sich aufgrund ihrer Fähigkeit, Kreativität zu fördern und das Schreiben zu optimieren, großen Zuspruch bei angehenden sowie erfahrenen Autoren erarbeitet.

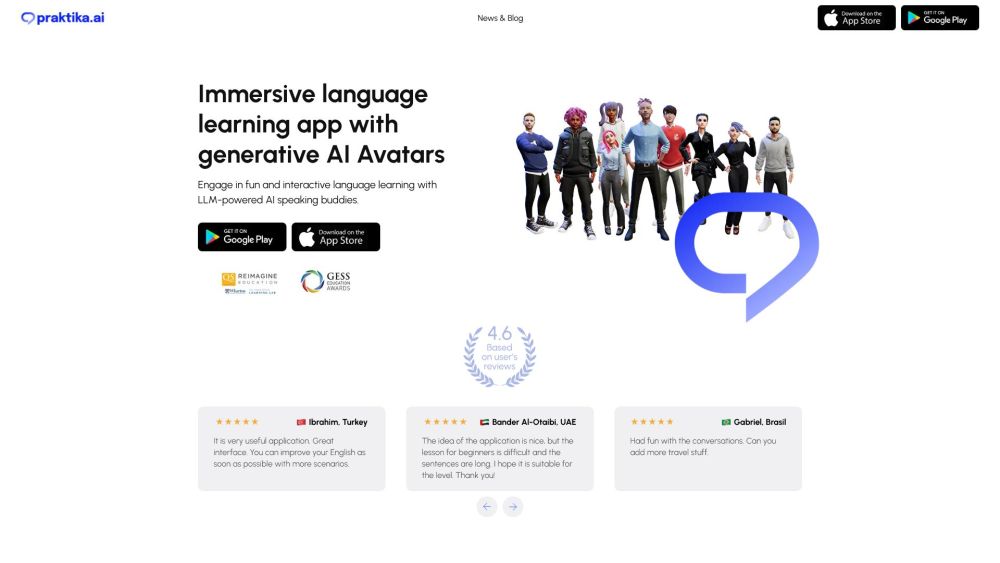

Praktika ist eine innovative Sprachlern-App, die KI-Avatare nutzt, um immersive und realistische Englischlektionen anzubieten. Durch ihren ansprechenden Ansatz verändert Praktika die Art und Weise, wie Nutzer lernen, und macht den Spracherwerb angenehmer und effektiver.

Optimieren Sie Ihre Planung und steigern Sie die Produktivität mit einem KI-Kalenderassistenten. Dieses innovative Werkzeug vereinfacht die Terminplanung, indem es Ihre Termine und Erinnerungen intelligent verwaltet, sodass Sie nie ein wichtiges Meeting oder Event verpassen. Erleben Sie die Zukunft des Zeitmanagements und entfalten Sie das Potenzial für einen organisierten und effizienten Lebensstil mit Unterstützung durch KI.

Find AI tools in YBX

Related Articles

Refresh Articles