메타의 LLM 컴파일러: 향상된 코드 생성 및 컴파일 효율성을 위한 AI 솔루션

Most people like

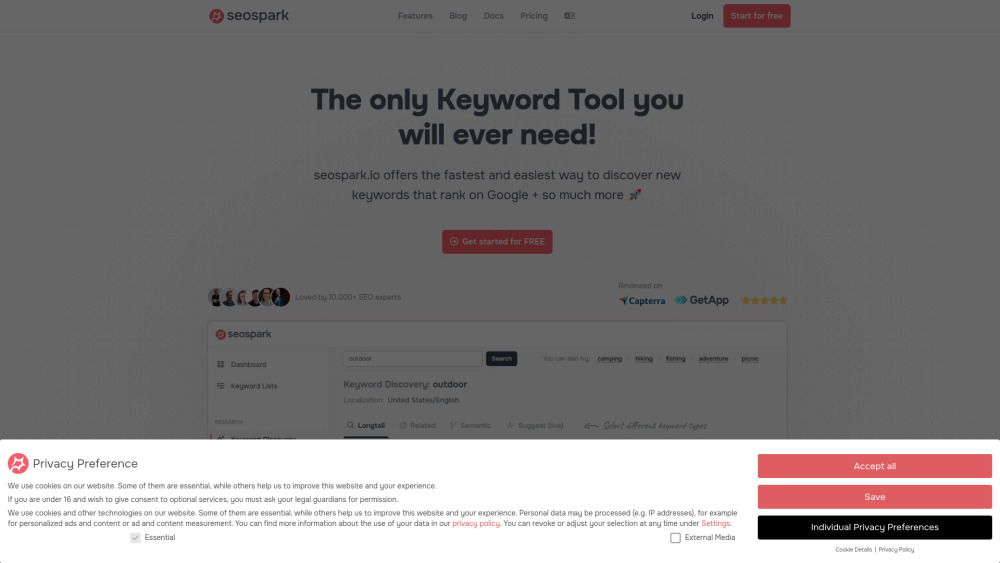

온라인 존재의 잠재력을 최대한 활용하세요! 저희 강력한 SEO 도구는 키워드 연구와 효과적인 콘텐츠 전략 개발을 위해 설계되었습니다. 경험이 풍부한 디지털 마케터이든 시작하는 단계든 상관없이, 저희 직관적인 플랫폼은 영향력 있는 키워드를 파악하고 타겟 오디언스와 공감할 수 있는 매력적인 콘텐츠를 작성하는 데 필요한 인사이트를 제공합니다. 데이터 기반 전략을 활용하여 SEO 실력을 높이고 유기적 트래픽을 유도하세요. 더 나은 가시성과 향상된 검색 순위를 위해 오늘부터 최적화를 시작해 보세요!

Find AI tools in YBX