메타, LLM 컴파일러 모델 출시: 효율적인 코드 최적화를 위한 AI 프로그래밍 스킬 강화

Most people like

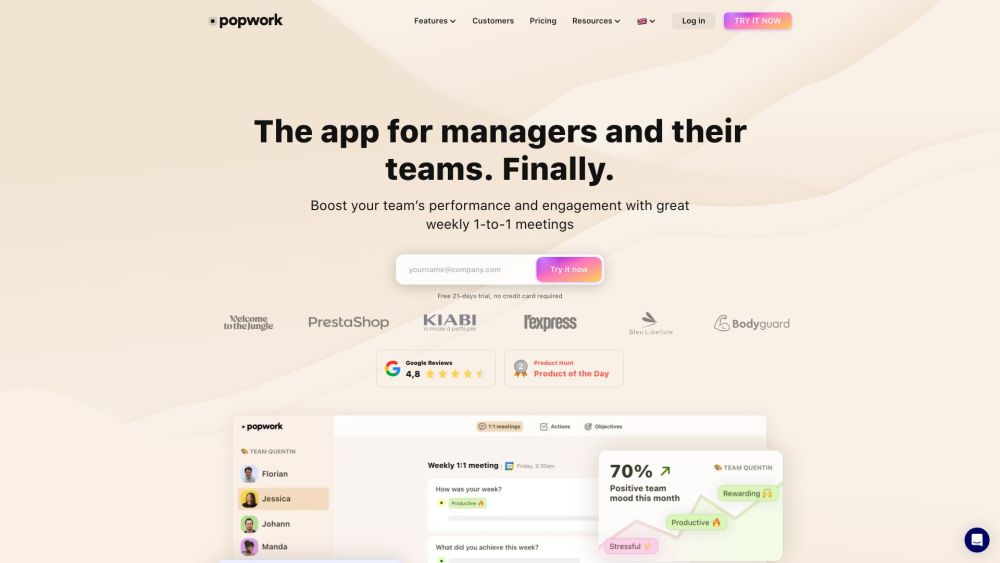

팝워크 소개: 팀 리더를 위해 설계된 지능형 어시스턴트로, 팀 관리와 생산성 향상을 위한 다양한 강력한 솔루션을 제공합니다. 팝워크가 당신의 리더십 접근 방식을 어떻게 변화시키고 협업을 효율화할 수 있는지 알아보세요.

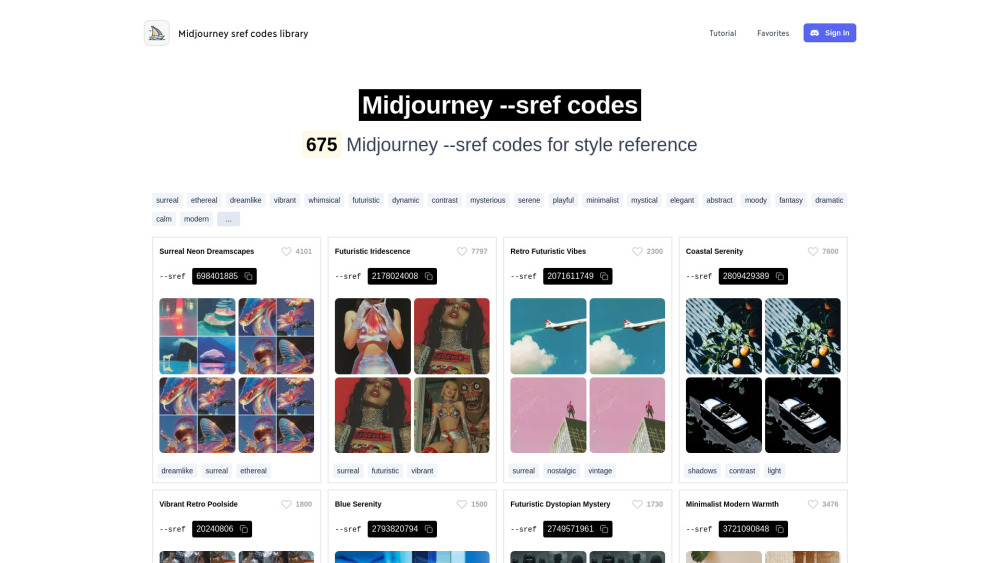

멋진 미드저니 아트를 만들기 위한 스타일 참조 코드의 종합 모음입니다. 우리는 당신의 예술적 비전을 높이고 창의적인 프로젝트를 향상시키기 위해 큐레이션된 목록을 탐험해보세요.

Find AI tools in YBX

Related Articles

Refresh Articles