연구 결과, 언어 모델이 자신의 추론을 숨기기 위해 스테가노그래피를 사용하는 방식이 밝혀졌다.

Most people like

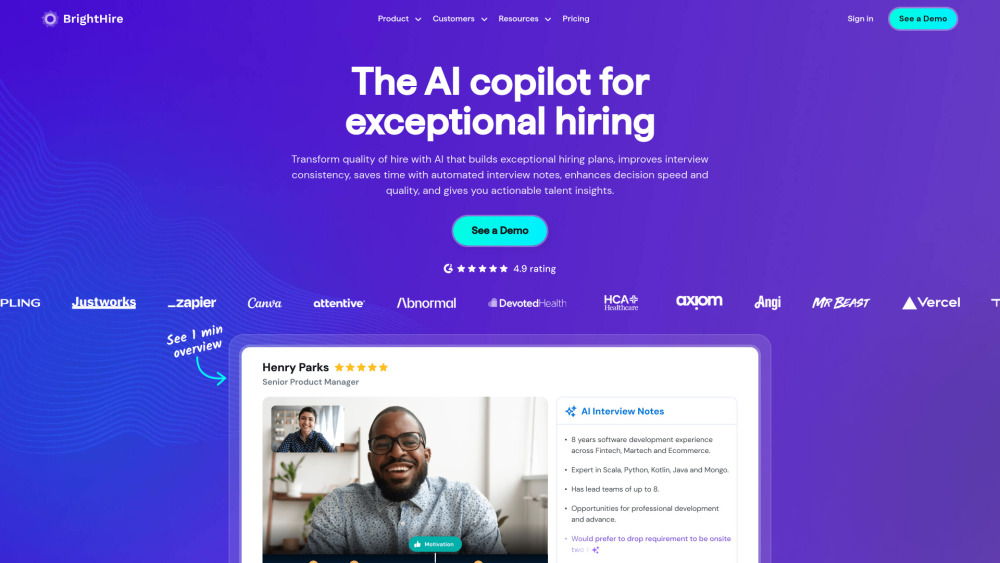

AI 인터뷰 인텔리전스를 활용하여 채용 경험을 혁신하세요. 고급 알고리즘과 데이터 분석을 통합한 이 혁신적인 접근 방식은 후보자 평가를 간소화하고, 의사 결정을 향상시키며, 채용 과정을 가속화합니다. 오늘날 AI 기반 인사이트로 채용 전략을 전환하여 더 나은 인재 확보와 조직 적합성을 이끌어내십시오.

홈과 헬스장에서 모두 사용할 수 있는 개인 맞춤형 트레이닝 앱을 소개합니다. 이 혁신적인 앱을 통해 여러분의 피트니스 여정을 개인의 필요에 맞게 조정할 수 있습니다. 근력 강화, 지구력 향상, 유연성 개선 등 목표에 따라 적합한 프로그램을 선택하세요. 여러분의 라이프스타일에 맞는 프로그램으로 운동을 한 단계 끌어올리고 피트니스 목표를 달성할 준비를 하세요!

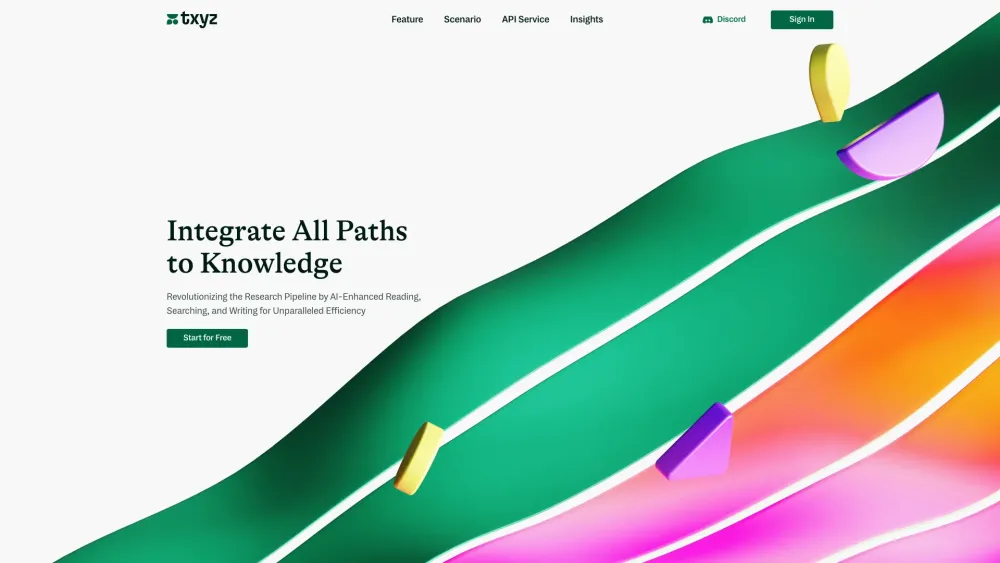

연구 과정을 혁신적으로 변화시키고 간소화하는 AI 플랫폼을 소개합니다. 인공지능의 힘을 활용하여 연구 역량을 향상시키고 비할 데 없는 효율성과 정확성을 경험하세요. 우리의 혁신적인 기술이 지식 탐구를 어떻게 지원할 수 있는지 알아보세요. 정보 수집을 그 어느 때보다 빠르고 효과적으로 만들어드립니다.

Find AI tools in YBX

Related Articles

Refresh Articles