Allen Institute for AI Lança LLM 'Realmente Open Source' para Impulsionar uma 'Mudança Crítica' no Desenvolvimento de IA

Most people like

No cenário digital acelerado de hoje, os criadores de conteúdo estão sempre em busca de soluções inovadoras para aumentar sua produtividade e criatividade. Ferramentas online impulsionadas por IA surgiram como recursos essenciais, oferecendo recursos avançados que otimizam o processo de criação de conteúdo. Desde assistentes de escrita automatizada até capacidades avançadas de edição de imagem, essas ferramentas capacitam os criadores a produzir conteúdo de alta qualidade de forma mais eficiente. Descubra como essas soluções de IA podem transformar seu fluxo de trabalho criativo e elevar sua presença digital.

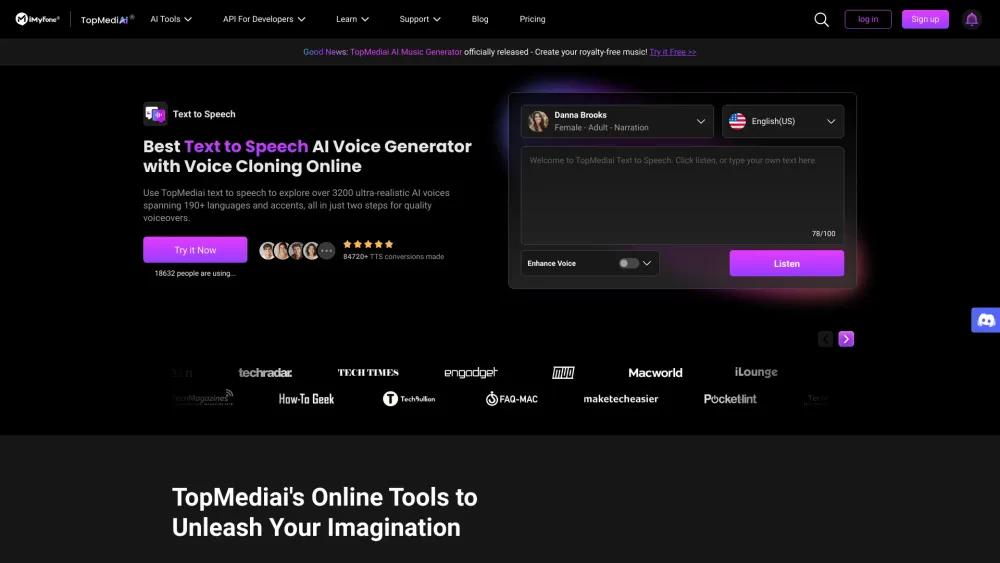

Mergulhe no intrigante mundo das conversas NSFW e geração de imagens por IA, onde tecnologias avançadas de inteligência artificial criam conteúdos adultos dinâmicos e envolventes. Este campo revolucionário mistura criatividade com algoritmos de ponta para produzir textos e visuais únicos, ampliando os limites da mídia tradicional. Descubra como a IA está transformando o entretenimento adulto ao oferecer experiências personalizadas e narrativas inovadoras, enquanto navega pelas complexidades e considerações éticas do conteúdo NSFW. Junte-se a nós enquanto exploramos essa fascinante interseção entre tecnologia e arte.

Desbloqueie o poder do nosso solucionador de matemática baseado em IA gratuito, projetado para ajudá-lo a enfrentar suas tarefas de matemática com facilidade. Se você está tendo dificuldades com álgebra, cálculo ou geometria, nossa ferramenta avançada está aqui para fornecer soluções claras e explicações passo a passo, garantindo que você não apenas conclua suas atividades, mas também amplie sua compreensão dos conceitos matemáticos. Comece hoje mesmo e transforme sua experiência de aprendizado!

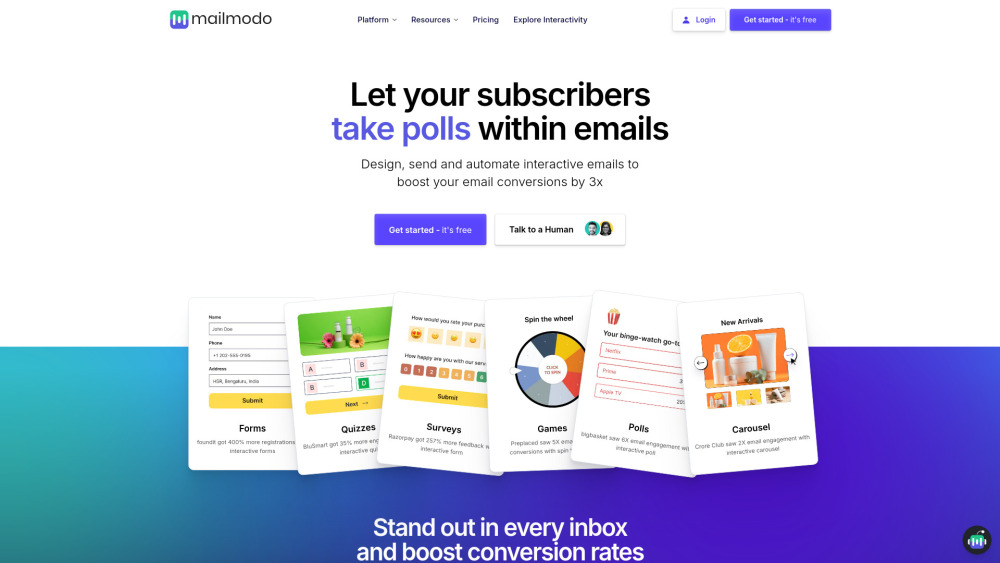

Descubra o poder da nossa plataforma de email marketing, projetada para ajudá-lo a criar emails interativos que aumentam significativamente o engajamento do público. Com nossas ferramentas e recursos intuitivos, você pode desenvolver campanhas visualmente impressionantes que cativam seus assinantes e geram melhores resultados.

Find AI tools in YBX