Протестующие собрали митинг у офиса OpenAI против военного использования ИИ и разработки общего искусственного интеллекта (AGI).

Most people like

Создавайте и улучшайте потрясающие произведения искусства с разрешением до 1080p. Исследуйте возможности генерации и редактирования цифрового искусства, раскрывая свой творческий потенциал с помощью высококачественной графики.

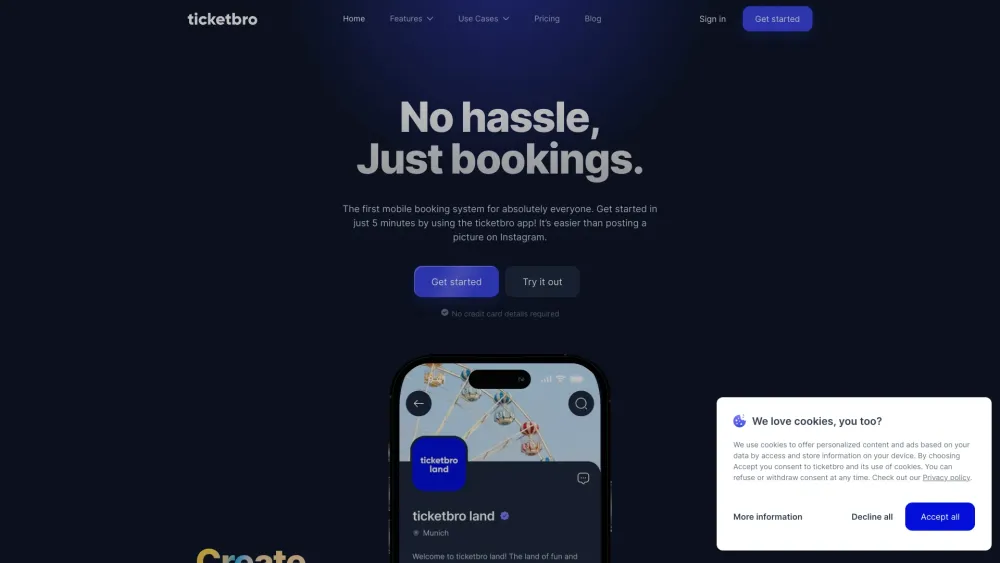

В современном быстро меняющемся цифровом мире эффективная мобильная система онлайн-бронирования является необходимостью для бизнеса, стремящегося повысить удобство для клиентов и оптимизировать свои операции. Это инновационное решение позволяет пользователям легко записываться на встречи, резервировать услуги и управлять бронями — всего лишь с помощью смартфона. Интегрируя мобильную систему онлайн-бронирования в свой бизнес, вы можете значительно повысить удовлетворенность клиентов и эффективность операций, оставаясь конкурентоспособными в своей отрасли. Изучите преимущества и функции этой трансформирующей технологии, чтобы улучшить процесс бронирования и расширить свою клиентскую базу.

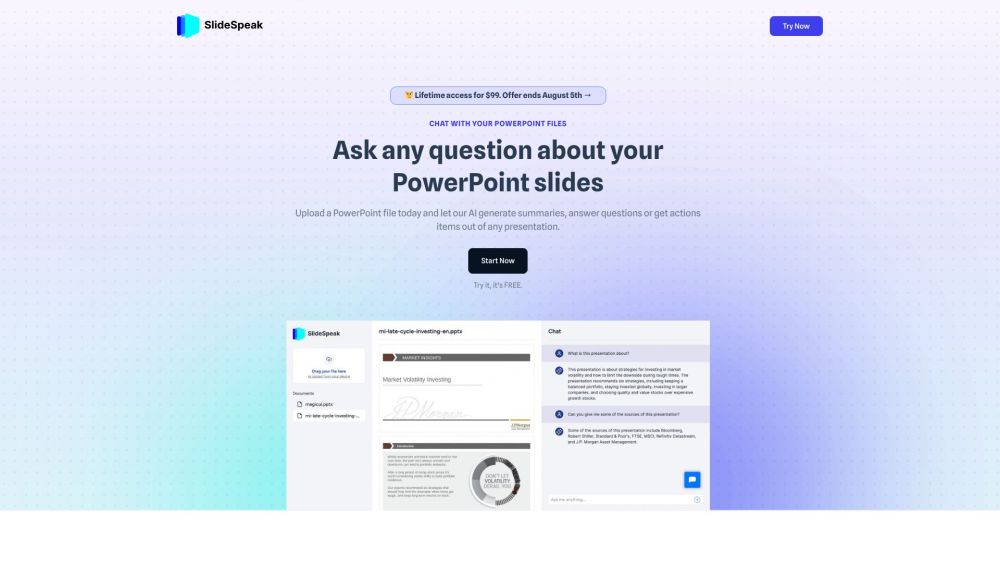

Представляем SlideSpeak — инновационную чат-платформу, созданную для повышения вовлеченности пользователей с слайдами PowerPoint. Этот динамичный инструмент обеспечивает бесшовное взаимодействие, изменяя способ восприятия презентаций и делая ваши слайды более интерактивными, чем когда-либо.

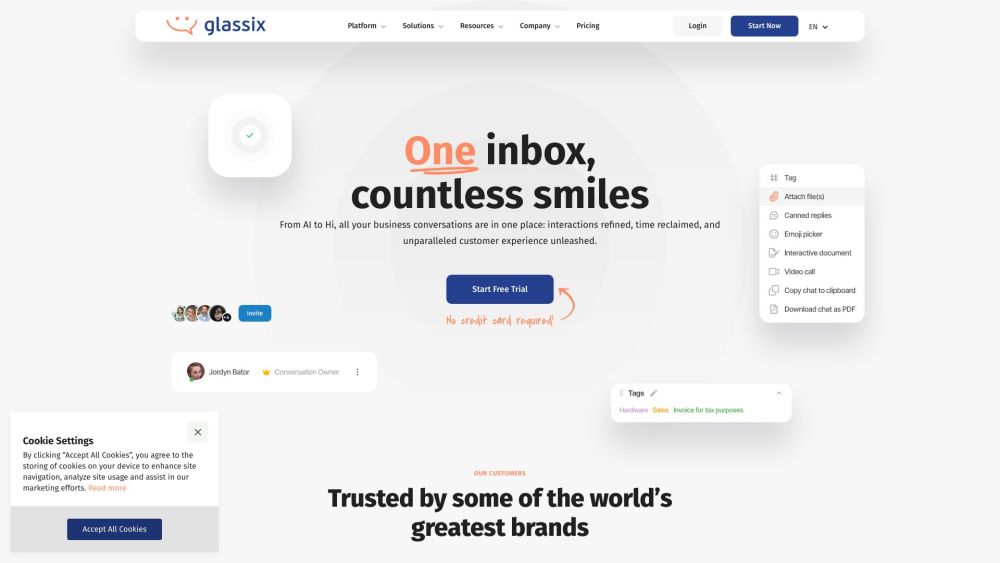

Откройте для себя мощь единой платформы обмена сообщениями на основе ИИ, которая революционизирует коммуникацию в бизнесе. Благодаря безшовной интеграции различных каналов, это современное решение улучшает сотрудничество и повышает продуктивность. Испытайте мгновенную связь, упрощенные рабочие процессы и персонализированные взаимодействия в одном интуитивно понятном интерфейсе. Примите будущее обмена сообщениями с интеллектуальной системой, созданной для улучшения вашей стратегии коммуникации и достижения успеха.

Find AI tools in YBX

Related Articles

Refresh Articles