如何確保人類掌握人工智慧的控制權

Most people like

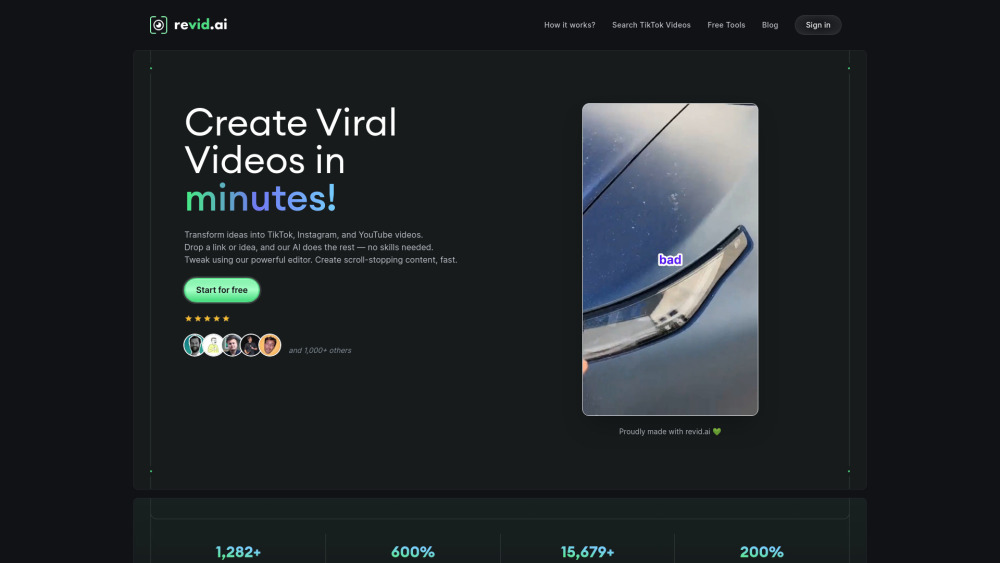

解鎖一款以人工智能驅動的工具的強大力量,輕鬆創作引人注目的病毒短視頻。這一創新解決方案利用先進的人工智能技術,簡化視頻製作流程,確保您的內容不僅能吸引注意,還能與觀眾共鳴。無論您是內容創作者、營銷專家或企業主,這款工具使得創作可分享的互動視頻變得前所未有的簡單。擁抱視頻營銷的未來,見證您的觀眾數量不斷增長!

確保內容的真實性與 AI 技術

在當今數位時代,驗證線上內容的真實性比以往任何時候都來得重要。隨著錯誤信息和深度偽造技術的崛起,利用 AI 技術來檢查內容的真實性已成為可靠且高效的解決方案。這一創新方法不僅幫助個人和企業維護其可信度,還促進了在線溝通的信任。讓我們探索如何利用 AI 來改變內容驗證,並確保信息的完整性。

Find AI tools in YBX

Related Articles

Refresh Articles