專家呼籲設立法律“安全港”,以便研究人員、記者和藝術家能夠評估人工智慧技術。

Most people like

在當今快速變化的數位環境中,客服代理扮演著提升顧客滿意度的重要角色。然而,面對複雜的問題時,若沒有即時的支持將會頗具挑戰。我們的即時指導平台通過提供上下文相關的即時協助,賦能聯絡中心的代理,確保他們能夠提供準確且及時的回應。透過先進的分析與人工智慧驅動的洞察,該平台提升了代理的表現,優化了顧客互動,最終提高了聯絡中心的整體生產力。立即體驗未來的客服服務!

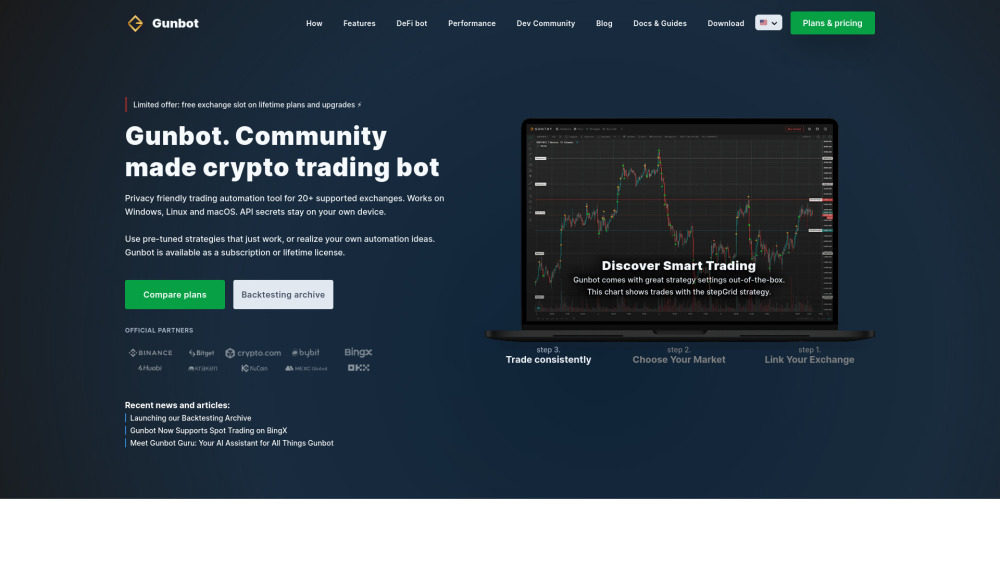

探索一款直觀的加密貨幣交易機器人,設計用於在多個交易所之間無縫使用。這個用戶友好的解決方案讓各個經驗水平的交易者能夠輕鬆優化他們的策略並提升市場表現。加入這個日益壯大的交易者社群,利用這個強大的工具自信地穿梭於加密世界中。

Find AI tools in YBX

Related Articles

Refresh Articles