介紹 Apache Airflow 2.10:人工智慧數據協調的新時代

Most people like

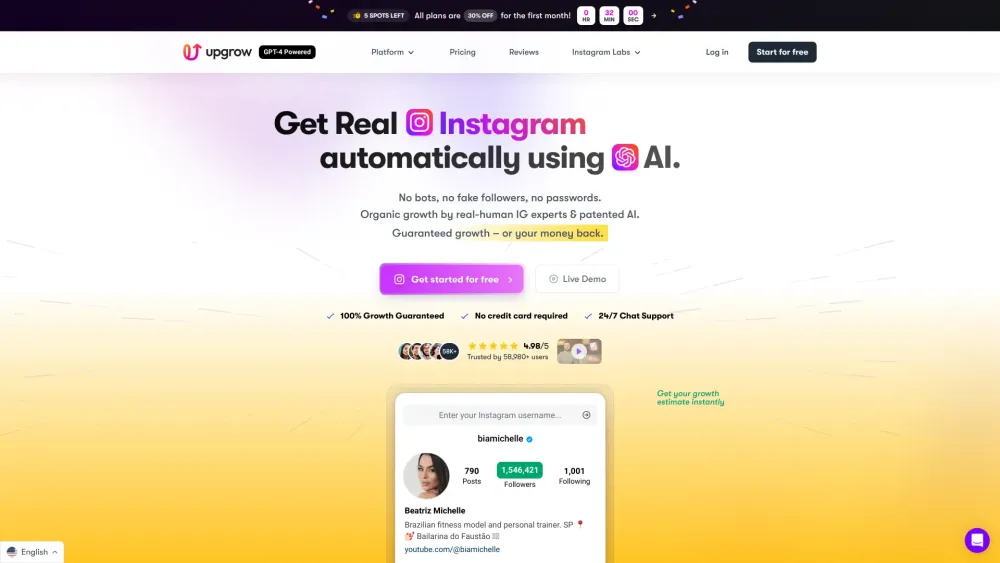

解鎖潛能,盡享我們的人工智慧Instagram增長服務

借助我們的高級人工智慧Instagram增長服務,輕鬆提升您的Instagram存在感。我們的服務旨在為您的社交媒體策略注入強大動能,運用尖端的人工智慧來提高互動率、吸引粉絲並增強品牌能見度。體驗為您獨特受眾量身打造的自然增長,讓您的Instagram社群茁壯成長。今天就加入我們,與人工智慧的力量一起改變您的社交媒體旅程!

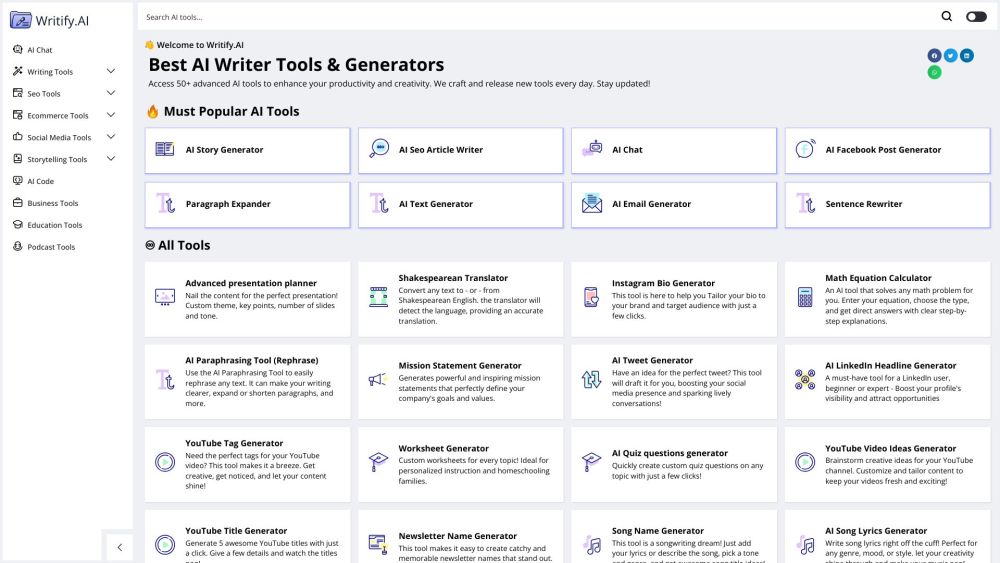

釋放您的潛能,透過我們的AI工具套件提升生產力與創造力

發現我們強大的AI工具套件如何轉變您的工作流程、提升生產力並激發您的創意火花。這些針對個人和團隊量身打造的創新解決方案可簡化任務、加強協作並激發原創想法。探索未來工作的新面貌,體驗旨在最大化您效率和促進每個項目創造力的尖端AI技術。今天就來擁抱更智慧的方式達成您的目標!

Find AI tools in YBX

Related Articles

Refresh Articles