解鎖高效能機器學習:租用 AWS GPU 滿足您的模型訓練需求

Most people like

發現一個單一平台,無縫訪問所有人工智慧模型。享受探索多樣化人工智慧解決方案的便利,這些解決方案旨在提升您的項目並推動創新。無論您是開發者、研究者還是愛好者,這個平台都提供您所需的一切,讓您能在一個方便的地方駕馭人工智慧的力量。

介紹一款為 ARM 和醫療行業打造的 AI 驅動工作流程平台

探索我們先進的 AI 驅動工作流程平台如何改變應收賬款管理 (ARM) 和醫療行業。通過精簡流程和提升運營效率,我們的平台使組織能夠優化工作流程、改善病患結果,並加速收入周期。與專為您的需求量身定制的尖端技術一起,探索行業創新的未來。

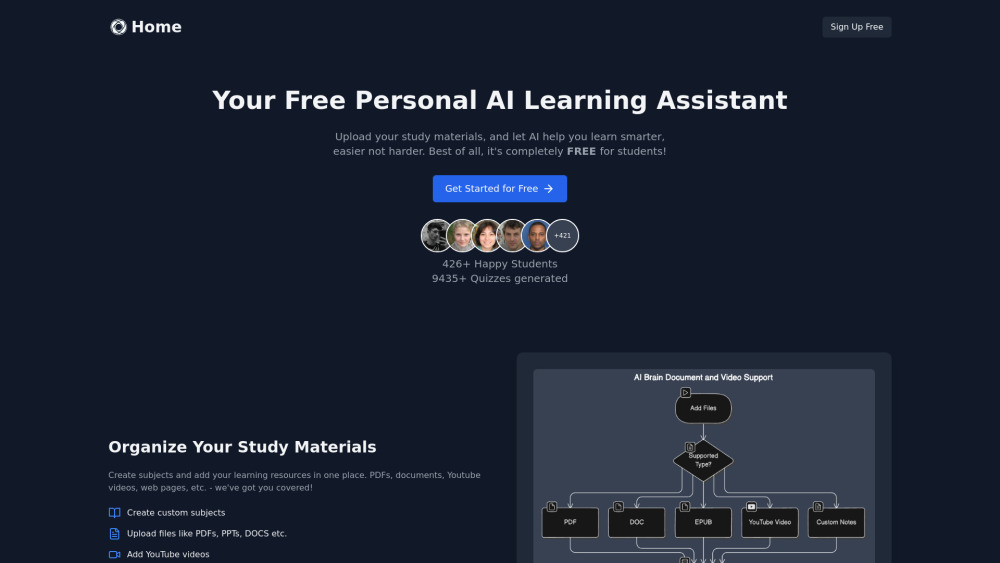

您是否在努力整理學習材料,或尋找創新的方法準備考試?我們的AI學習助手將為您提供幫助!這款智能工具不僅能有效地整理您的學習資源,還能生成定制化的測驗,以加強您的學習。採用更智慧的學習方式,提升您的考試表現,讓這個尖端的AI解決方案伴您左右。

Find AI tools in YBX

Related Articles

Refresh Articles