Amazon's RAGChecker: Ein Game-Changer für KI, aber noch nicht verfügbar

Most people like

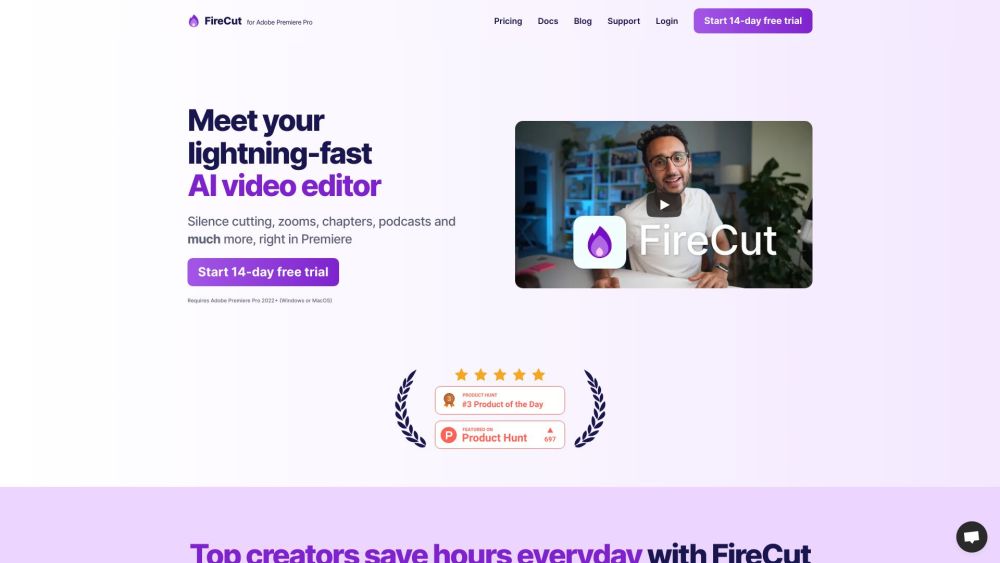

Optimieren Sie Ihren Bearbeitungsprozess in Adobe Premiere Pro, indem Sie sich wiederholende Aufgaben automatisieren. Steigern Sie Ihre Workflow-Effizienz und konzentrieren Sie sich mit Automatisierungsfunktionen auf kreative Aspekte, die Ihnen Zeit und Mühe sparen. Entdecken Sie noch heute, wie Sie Ihr Video-Editing-Erlebnis verbessern können!

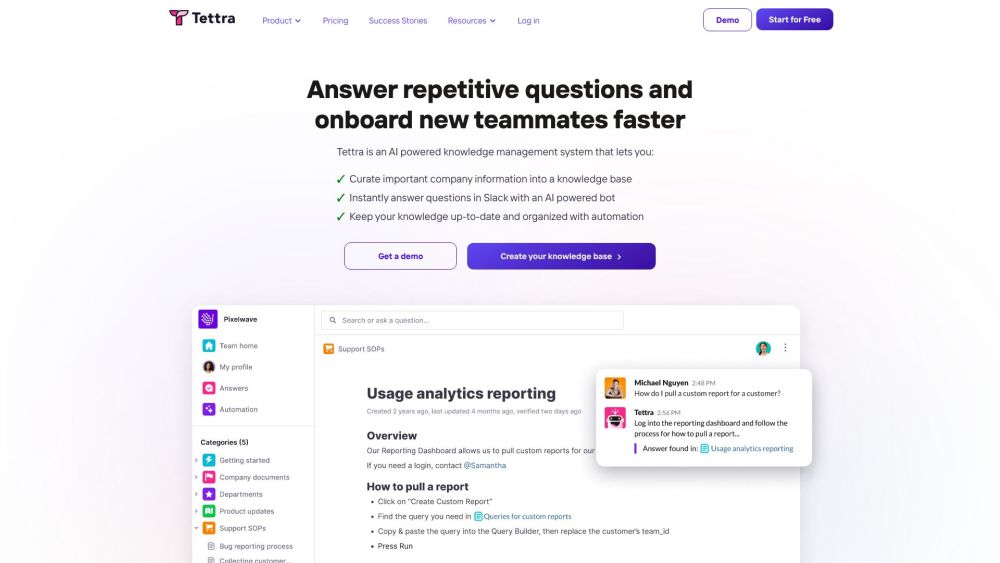

Präsentation unseres KI-gestützten Wissensmanagement-Systems: Revolutionieren Sie, wie Ihre Organisation Informationen erfasst, organisiert und abruft. Durch den Einsatz modernster künstlicher Intelligenz optimiert unser System den Wissensaustausch, fördert die Zusammenarbeit und steigert die Produktivität. Entdecken Sie, wie unsere innovative Lösung Ihre Wissensmanagement-Praktiken transformieren und Ihr Team befähigen kann, schneller und effizienter informierte Entscheidungen zu treffen. Optimieren Sie Ihre Arbeitsabläufe und maximieren Sie das Potenzial Ihrer Organisation mit unserer fortschrittlichen KI-Technologie.

Präsentation eines KI-lernenden Begleiters, der darauf abzielt, personalisierte Bildungsinteraktionen zu verbessern. Diese innovative Technologie passt das Lernen individuell an, fördert das Engagement und verbessert die Ergebnisse. Egal, ob Sie ein Schüler sind, der Unterstützung sucht, oder ein Lehrer, der maßgeschneiderten Unterricht bieten möchte, unser KI-lernhender Begleiter ist hier, um Ihre Lern- und Lehrmethoden zu transformieren.

Entdecken Sie die Kraft von KI-generierten, personalisierten Videos, die auf die einzigartigen Vorlieben und Bedürfnisse jedes Kunden abgestimmt sind. Verbessern Sie Ihre Marketingstrategie, indem Sie Ihr Publikum mit maßgeschneiderten Inhalten ansprechen, die Resonanz erzeugen und fesseln, und gewährleisten Sie so ein unvergessliches Erlebnis für jeden Zuschauer. Nutzen Sie das Potenzial individueller Videolösungen, um die Kundenzufriedenheit zu steigern und Konversionen zu fördern.

Find AI tools in YBX

Related Articles

Refresh Articles