Alle sprechen über Nvidias beeindruckende Gewinne, die im Jahresvergleich um 265 % gestiegen sind. Doch lassen Sie Groq, ein Silicon-Valley-Startup, das AI-Chips für die Inferenz großer Sprachmodelle (LLM) entwickelt, nicht aus den Augen — dabei handelt es sich um den Prozess, Vorhersagen auf der Basis bestehender Modelle zu treffen, anstatt neue zu trainieren. Letztes Wochenende erlebte Groq einen Aufschwung an Aufmerksamkeit, von dem viele Startups nur träumen können.

Obwohl es nicht so spektakulär war wie einer von Elon Musks Posts über das nicht verwandte Sprachmodell Grok, wird Nvidia vermutlich Notiz genommen haben, als Matt Shumer, CEO von HyperWrite, auf X über Groqs „wilde Technologie“ berichtete. Shumer hob hervor, dass Groq Mixtral mit fast 500 Token pro Sekunde (tok/s) nahezu sofortige Antworten liefern kann.

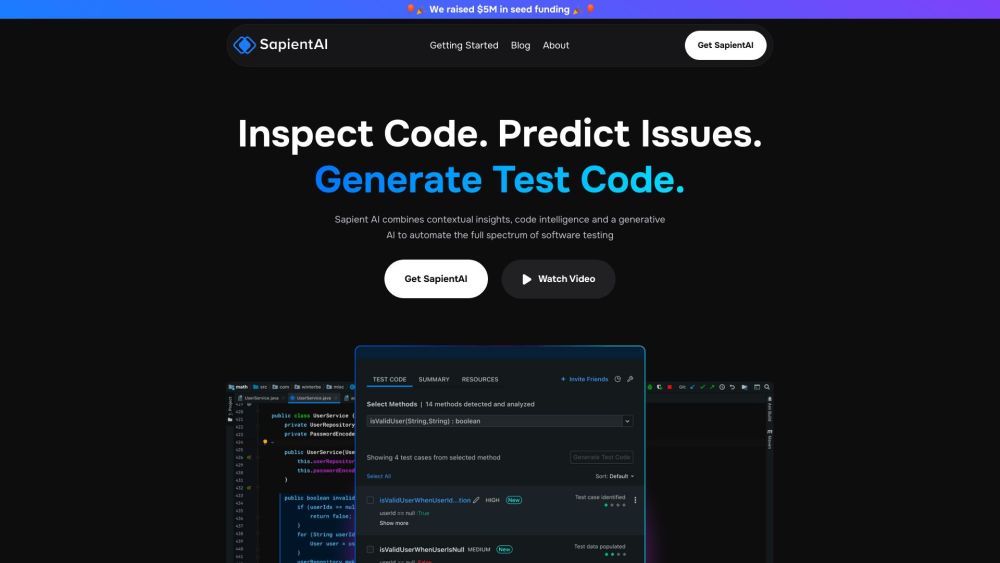

Shumer präsentierte auch eine „blitzschnelle Antwort-Engine“ auf X, die „faktengestützte, zitierte Antworten mit Hunderten von Wörtern in weniger als einer Sekunde“ liefert. Dies führte zu regem Interesse an Groqs Chat-Anwendung, in der Nutzer Ausgaben von Llama- und Mistral-LLMs auswählen können. Dieser Hype folgte einem Interview, in dem Groqs CEO Jonathan Ross demonstrierte, wie Groq eine Audio-Chat-Oberfläche betreibt, die „Geschwindigkeitsrekorde bricht“.

Aktuell kann kein anderes Unternehmen mit Nvidias Dominanz konkurrieren, das über 80 % des High-End-Chipmarkts hält. Andere AI-Chip-Startups wie SambaNova und Cerebras haben trotz des Einstiegs in die AI-Inferenz Schwierigkeiten, an Fahrt zu gewinnen. Während Nvidia im vierten Quartal 22 Milliarden Dollar Umsatz meldete, betonte Ross, dass Groq eine „super-schnelle“ und kosteneffektive Lösung für LLMs bietet, die die prohibitiv hohen Kosten der Inferenz adressiert.

Ross erklärte kühn: „Wir werden wahrscheinlich die Infrastruktur sein, die die meisten Startups bis Ende des Jahres nutzen.“ Er ermutigte Startups, sich für wettbewerbsfähige Preise zu melden.

Groq LPUs vs. Nvidia GPUs

Groq beschreibt seine LPUs (Language Processing Units) als bahnbrechendes End-to-End-Verarbeitungssystem, das für die schnelle Inferenz in AI-Sprachanwendungen optimiert ist. Im Gegensatz zu Nvidias GPUs, die sich auf parallele Grafikverarbeitung konzentrieren, verwalten Groqs LPUs effektiv Datensequenzen — sei es Code oder natürliche Sprache — und ermöglichen schnellere Ausgaben, indem sie die Grenzen der Rechenkapazität und des Speicherbandbreite überwinden, die traditionelle GPUs und CPUs betreffen.

Darüber hinaus betonte Ross, dass sich Groq von Unternehmen wie OpenAI unterscheidet, indem es keine Modelle trainiert, was bedeutet, dass die Privatsphäre der Nutzer geschützt bleibt, da keine Chat-Anfragen protokolliert werden.

Mit Schätzungen, dass ChatGPT mit Groq-Chips über 13 Mal schneller laufen könnte, könnte OpenAI ein zukünftiger Partner sein? Während Ross keine spezifischen Kooperationen bestätigte, erwähnte er, dass eine Partnerschaft vorteilhaft sein könnte, wenn beide Parteien gemeinsame Ziele verfolgen.

Ist Groqs LPU wirklich ein Game-Changer in der AI-Inferenz?

Ich war gespannt auf ein Gespräch mit Ross, seit Groq als „US-Hersteller von Chips, der im AI-Rennen siegen könnte“ gepriesen wurde. Nun war ich neugierig, ob Groqs LPUs tatsächlich einen Durchbruch in der AI-Inferenz darstellen oder nur ein flüchtiger Trend sind, der von PR-Hype getrieben wird.

Ross beschrieb Shumers Posts als „die Zündschnur“, wobei innerhalb von 24 Stunden über 3.000 Personen um API-Zugang baten. „Wir lassen die Leute es momentan kostenlos nutzen“, fügte er hinzu.

Ross ist kein Neuling in der Startup-Szene; er hat Googles Tensor Processing Unit (TPU) mitentwickelt, bevor er 2016 Groq gründete. Er erklärte, dass Groqs Ansatz einzigartig sei: „Wenn man ein Auto baut, kann man mit dem Motor oder dem Fahrerlebnis beginnen. Wir begannen mit dem Fahrerlebnis und konzentrierten uns in den ersten sechs Monaten auf die Entwicklung eines anspruchsvollen Compilers.“

Die Nachfrage nach Nvidias GPUs ist in der AI-Branche gestiegen, was einen lukrativen Markt schafft. Neue GPU-Cloud-Dienste sind entstanden, während der ehemalige GitHub-CEO Nat Friedman kürzlich einen Marktplatz für GPU-Cluster erwähnte. Berichten zufolge plant OpenAIs CEO Sam Altman, die Nachfrage nach AI-Chips durch ein massives Projekt mit einem gewaltigen Preisschild und komplizierten geopolitischen Implikationen zu adressieren.

Ross glaubt, dass das aktuelle GPU-Klima teilweise auf Groqs Initiativen reagiert. „Es gibt einen kleinen Teufelskreis“, sagte er und bezog sich auf Nvidias Geschäfte mit souveränen Staaten als Teil seiner eigenen bevorstehenden globalen Verhandlungen.

Auf die Frage nach Altmans Ambitionen für eine 7 Billionen Dollar teure AI-Chip-Initiative erklärte Ross selbstbewusst: „Wir könnten es für 700 Milliarden Dollar machen. Wir sind ein Schnäppchen.“

Groq hat auch das Ziel, die Kapazitäten zur Versorgung mit AI-Chips zu verbessern. „[Bis Ende des Jahres] werden wir definitiv eine Kapazität von 25 Millionen Token pro Sekunde haben, was wir für OpenAIs Ziel Ende 2023 schätzen“, sagte er und betonte die laufenden Gespräche mit verschiedenen Ländern zur Erweiterung dieser Kapazität.

Allerdings muss Groq auch praktische Herausforderungen bewältigen, wie die Implementierung der API-Abrechnung angesichts des kürzlichen Anstiegs des Interesses. Als ich nach ihren Plänen zur Abrechnung fragte, antwortete Ross: „Wir werden uns darum kümmern“, nur um von seinem PR-Vertreter bestätigen zu lassen: „Ja, das wird eine der ersten Aufgaben sein.“