OpenAI entwickelt eigene maßgeschneiderte Chips

Most people like

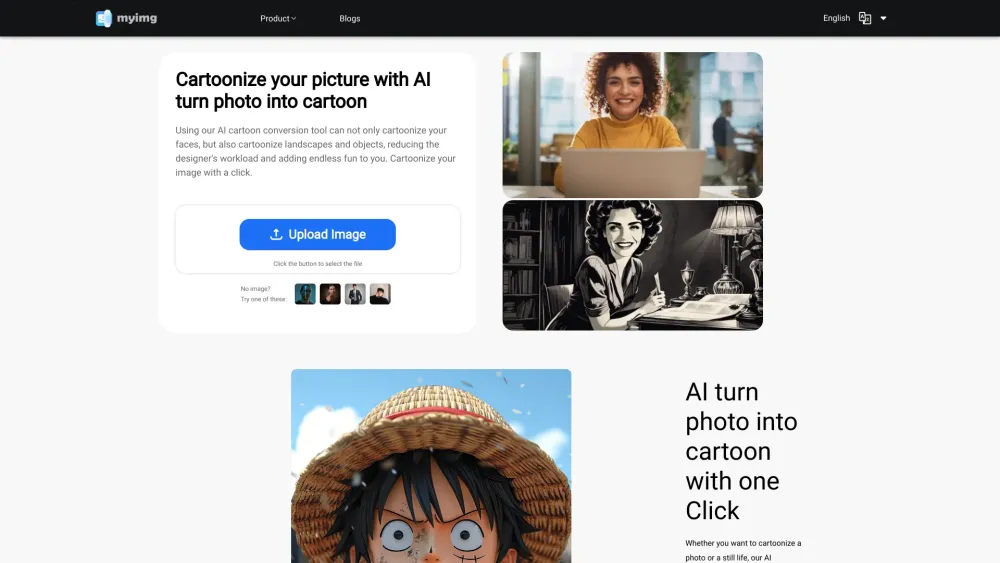

Verwandeln Sie Ihre Bilder und Videos sofort in atemberaubende Cartoons

Entfalten Sie Ihre Kreativität, indem Sie mühelos Ihre Fotos und Videos in fesselnde Cartoon-Versionen umwandeln. Dieses Tool ermöglicht es Ihnen, Bilder und Videos in nur wenigen Klicks zu cartoonisieren und bietet eine unterhaltsame und einzigartige Möglichkeit, Ihre künstlerische Vision auszudrücken. Egal, ob Sie auffällige Inhalte für soziale Medien erstellen, Geschenke personalisieren oder einfach Ihre kreative Seite erkunden möchten, entdecken Sie, wie einfach es ist, Ihre visuellen Medien sofort in Cartoons zu verwandeln!

Präsentation einer kostenlosen Plattform, die entwickelt wurde, um Studenten dabei zu helfen, mithilfe KI-gesteuerter Techniken effektiver zu lernen. Entfalte dein akademisches Potenzial und verbessere noch heute dein Lernerlebnis!

Soaster ist ein leistungsstarkes Twitter-Management-Tool, das darauf abzielt, die Benutzerinteraktion zu verbessern und nachhaltiges Wachstum voranzutreiben.

Find AI tools in YBX

Related Articles

Refresh Articles