Präsident von OpenAI präsentiert erstes Bild, das von GPT-4o erstellt wurde.

Most people like

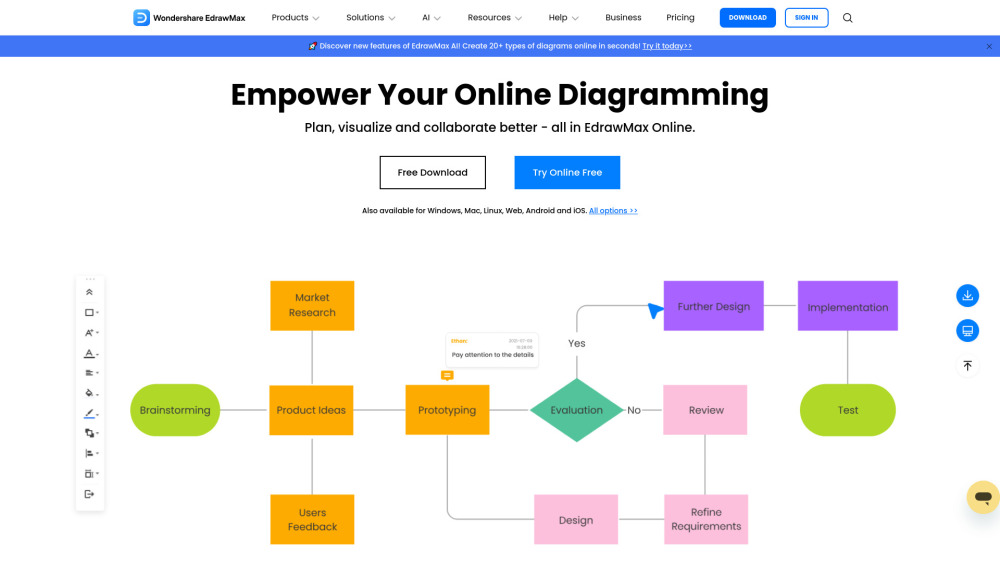

Erstellen Sie beeindruckende Visualisierungen mit unserem Online-Diagramm-Tool

Steigern Sie Ihre Projekte und Präsentationen mit unserem intuitiven Online-Diagramm-Tool. Gestalten Sie mühelos professionelle Visualisierungen mit anpassbaren Vorlagen und benutzerfreundlichen Werkzeugen. Egal, ob Sie Flussdiagramme, Mind Maps oder Organigramme benötigen, unsere Plattform ermöglicht es Ihnen, Ihre Ideen klar und effektiv zu kommunizieren. Beginnen Sie noch heute mit der Erstellung beeindruckender Diagramme!

WindyBot bietet modernste KI-Tools, die darauf abzielen, die Produktivität zu steigern und Kreativität zu entfachen. Zu unseren Funktionen gehören fortgeschrittene Schreibassistenz, Kunstgenerierung, umfassende Analysen und interaktive Chatbot-Lösungen. Entfalten Sie Ihr Potenzial mit der innovativen Technologie von WindyBot.

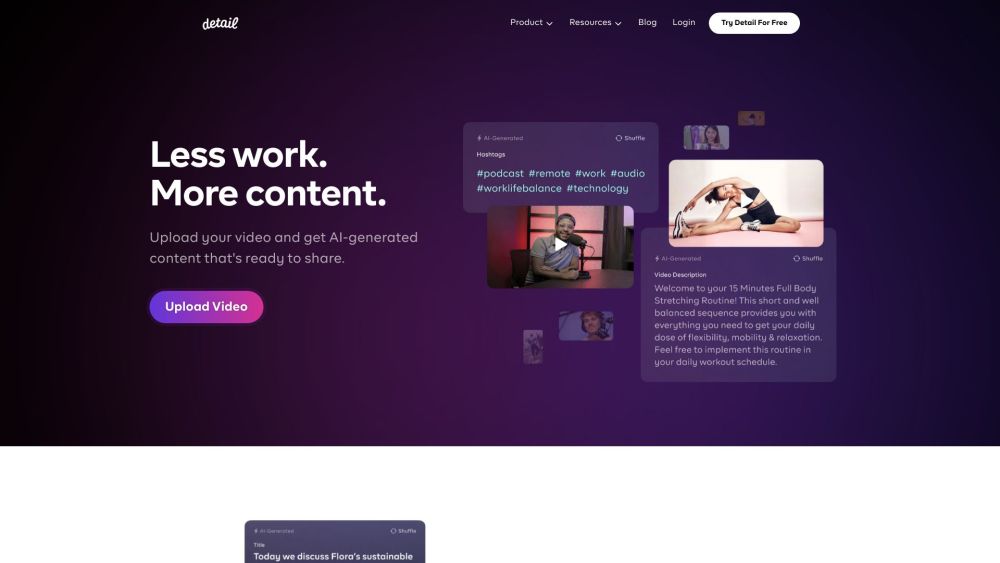

Detail ist eine innovative Kamera-App, die das Videoaufnehmen und -bearbeiten für angehende Geschichtenerzähler vereinfacht. Mit ihrer benutzerfreundlichen Oberfläche und leistungsstarken Funktionen ermöglicht Detail den Nutzern, mühelos fesselnde visuelle Erzählungen zu erstellen.

Entdecken Sie eine neue Art, mit Ihren PDF-Dokumenten zu interagieren! Unsere innovative Chat-Funktion ermöglicht es Ihnen, Fragen zu stellen, Informationen abzurufen und wichtige Daten direkt aus Ihren PDFs zu extrahieren. Vereinfachen Sie Ihren Arbeitsablauf und steigern Sie Ihre Produktivität, indem Sie nahtlos mit Ihren Dokumenten in Echtzeit kommunizieren. Egal, ob Sie Student, Berufstätiger oder Forscher sind, dieses Tool revolutioniert Ihre Arbeit mit PDFs und macht den Informationszugang so einfach wie nie zuvor.

Find AI tools in YBX

Related Articles

Refresh Articles