Entendiendo la Incertidumbre de la Ley de IA de la UE: Perspectivas de la Controversia de OpenAI

Most people like

Desbloquea tu potencial creativo creando impresionantes paletas de colores que den vida a tus diseños. Previsualiza estas paletas en proyectos reales para ver cómo mejoran la estética y el impacto. Ya seas diseñador o un entusiasta del bricolaje, dominar las combinaciones de colores puede llevar tu trabajo al siguiente nivel.

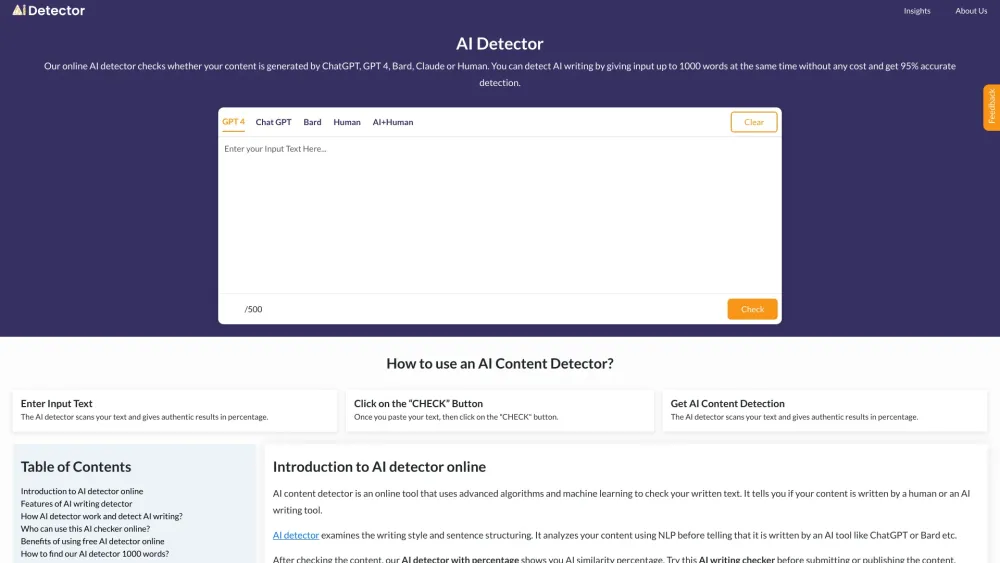

Desbloquea el poder de la detección de IA a través de algoritmos de vanguardia. Descubre cómo estas sofisticadas tecnologías pueden mejorar la precisión y la eficiencia en la identificación de contenido generado por inteligencia artificial. Al aprovechar técnicas de última generación, empresas e investigadores pueden garantizar evaluaciones confiables y mejorar los procesos de toma de decisiones. ¡Sumérgete en el mundo de la detección avanzada de IA ahora!

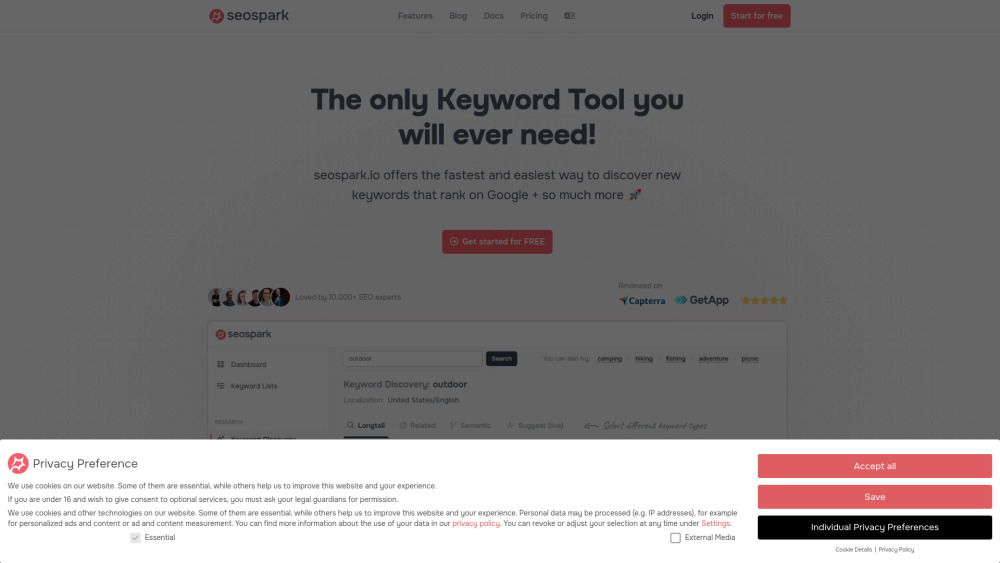

En el panorama digital actual, una investigación de palabras clave efectiva y una planificación estratégica de contenido son esenciales para atraer tráfico orgánico y mejorar tu presencia en línea. Al optimizar estos procesos, puedes centrarte en generar contenido de alta calidad que conecte con tu audiencia y mejore tu clasificación en los motores de búsqueda. Descubre cómo simplificar tus estrategias de palabras clave y alinear tu contenido para cumplir tus objetivos comerciales, maximizando al mismo tiempo el compromiso.

Desbloquea todo el potencial de tu presencia en línea con nuestra potente herramienta de SEO, diseñada para la investigación de palabras clave y el desarrollo de estrategias de contenido efectivas. Ya seas un comercializador digital experimentado o estés comenzando, nuestra plataforma intuitiva te proporciona la información necesaria para identificar palabras clave de alto impacto y crear contenido atractivo que resuene con tu audiencia. Mejora tu juego de SEO y aumenta el tráfico orgánico aprovechando estrategias basadas en datos, adaptadas a tu nicho. ¡Comienza a optimizar hoy para una mejor visibilidad y mejoras en los rankings de búsqueda!

Find AI tools in YBX

Related Articles

Refresh Articles