Microsoft presenta la demostración de 'MInference' para revolucionar los estándares de procesamiento de IA.

Most people like

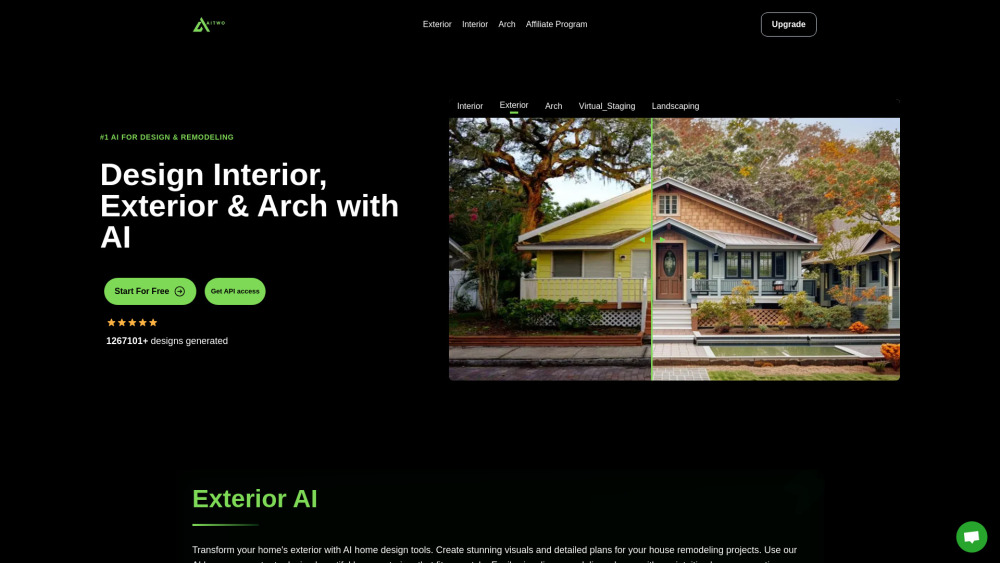

Presentamos una innovadora plataforma basada en inteligencia artificial que revoluciona el diseño de interiores. Esta herramienta de vanguardia utiliza IA para optimizar el proceso, facilitando que propietarios y diseñadores creen espacios bellos y funcionales. Ya sea que estés renovando tu hogar actual o construyendo desde cero, nuestra plataforma cuenta con características que mejoran la creatividad y la eficiencia, adaptándose a tus necesidades únicas. Descubre cómo nuestra tecnología de IA puede transformar tu visión en realidad, simplificando toda la experiencia de diseño.

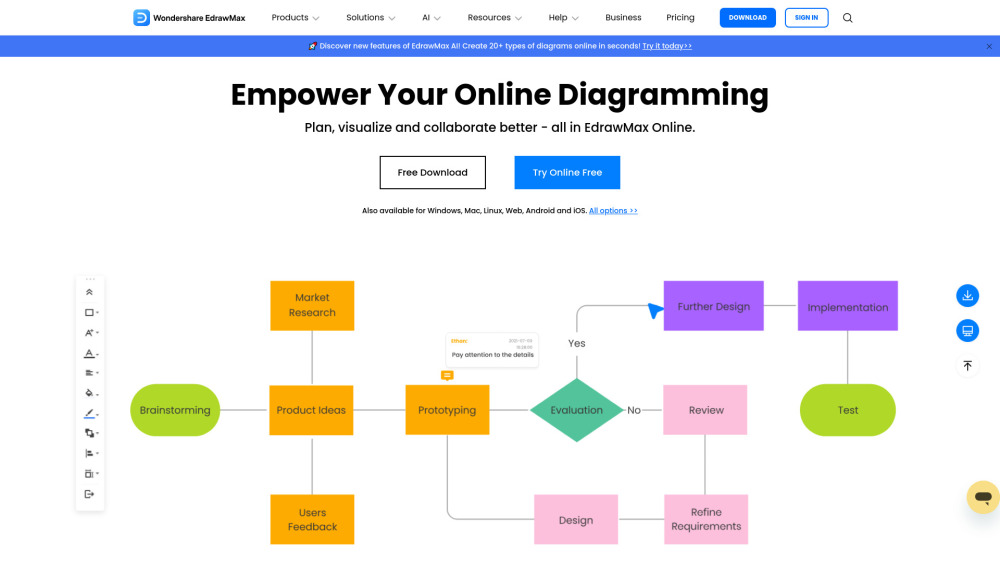

Crea Visuales Impresionantes con Nuestro Creador de Diagramas en Línea

Eleva tus proyectos y presentaciones con nuestro intuitivo creador de diagramas en línea. Diseña visuales de calidad profesional sin esfuerzo, utilizando plantillas personalizables y herramientas fáciles de usar. Ya sea que necesites diagramas de flujo, mapas mentales o organigramas, nuestra plataforma te permite comunicar tus ideas de manera clara y efectiva. ¡Comienza a crear diagramas impresionantes hoy mismo!

Presentamos una plataforma de gestión de fraudes impulsada por inteligencia artificial, diseñada específicamente para que las empresas puedan mitigar eficazmente los riesgos y proteger sus activos. Esta solución innovadora utiliza algoritmos avanzados para detectar y prevenir actividades fraudulentas, garantizando un entorno seguro para las operaciones de su negocio.

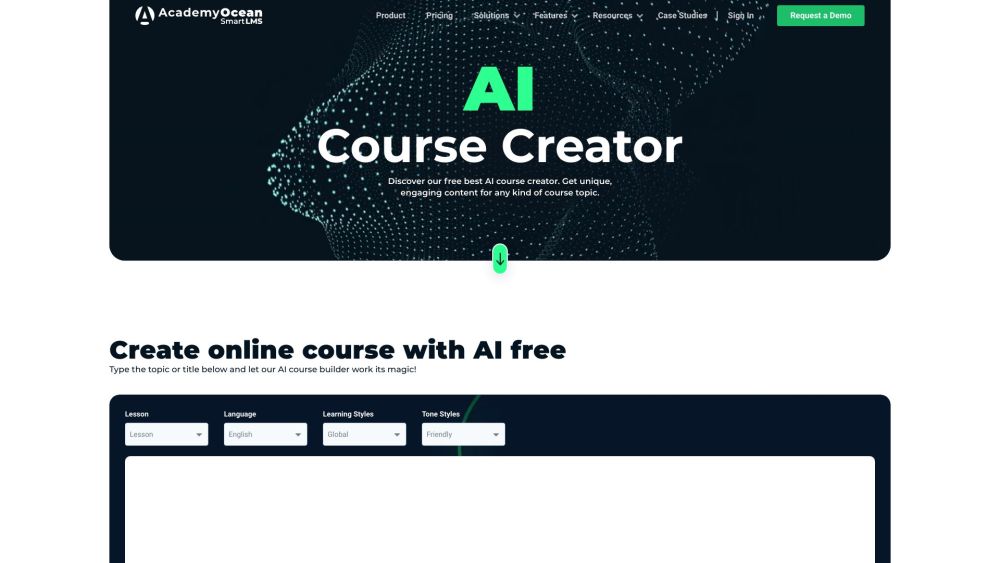

Desbloquea el Potencial de la Tecnología AI para Crear Cursos Atractivos

En el panorama digital actual, incorporar la tecnología de IA en el diseño de cursos está revolucionando la forma en que educamos. Al aprovechar el poder de la inteligencia artificial, los educadores pueden crear experiencias de aprendizaje personalizadas, interactivas y eficientes que se adaptan a las necesidades únicas de cada estudiante. Este enfoque innovador no solo mejora el compromiso, sino que también agiliza el desarrollo de cursos. Descubre cómo puedes aprovechar las herramientas de IA para crear cursos dinámicos que cautiven a los alumnos y eleven tu estrategia docente.

Find AI tools in YBX