OpenAI Lanza el Modo de Voz GPT-4o para Usuarios de ChatGPT Plus, Mejorando las Conversaciones Naturales en Tiempo Real.

Most people like

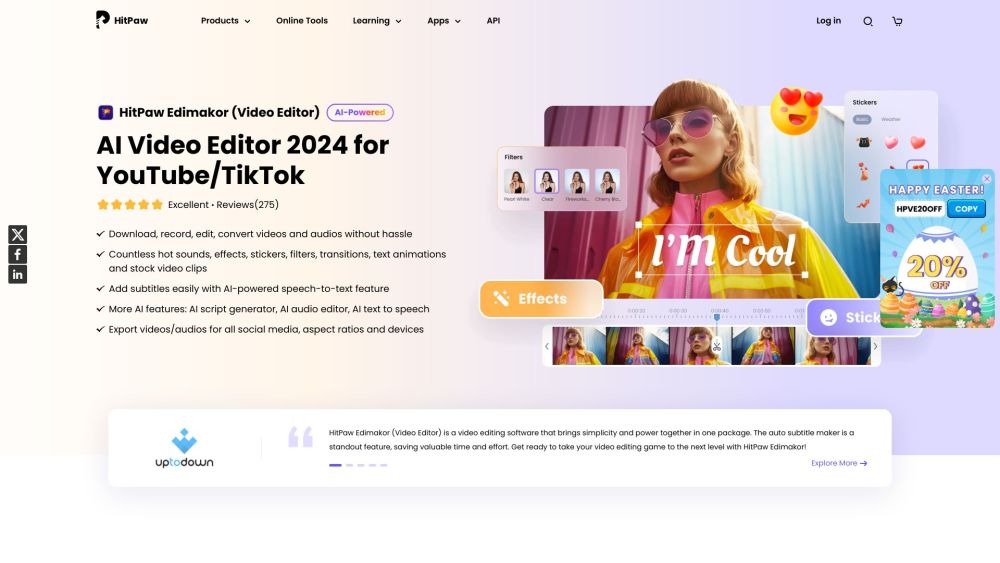

Presentamos un editor de video con inteligencia artificial, equipado con características de vanguardia que mejoran tu experiencia de producción de video. Esta herramienta innovadora aprovecha el poder de la inteligencia artificial para simplificar el proceso de edición, permitiéndote crear videos impresionantes sin esfuerzo. Ya seas creador de contenido, comercializador o cineasta, nuestro avanzado editor de video simplifica tareas complejas y mejora tus capacidades de edición, permitiéndote enfocarte en contar tu historia. Descubre el futuro de la edición de video y transforma tu visión creativa en realidad.

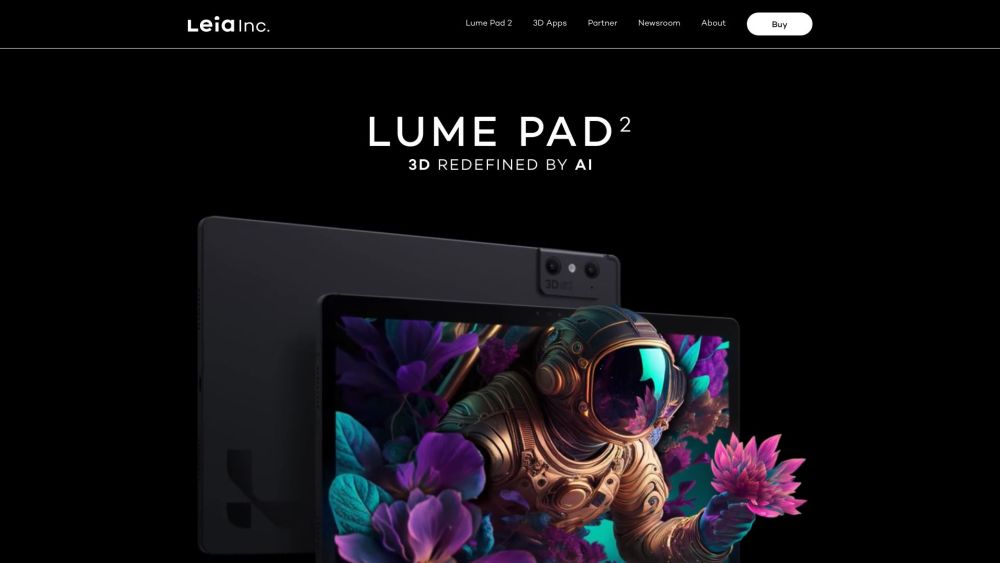

Leia Inc. presenta la revolucionaria Lume Pad 2, la primera tableta 3D inmersiva del mundo, impulsada por la avanzada tecnología 3D•AI. Descubre una nueva dimensión de experiencias digitales con las innovadoras propuestas de Leia.

Descubre una herramienta impulsada por IA diseñada específicamente para crear impresionantes obras de arte al estilo anime. Esta plataforma innovadora aprovecha tecnología avanzada para dar vida a tus visiones artísticas, ya seas un creador experimentado o estés comenzando. Mejora tu arte anime con facilidad y desata tu creatividad como nunca antes.

Find AI tools in YBX

Related Articles

Refresh Articles