Débloquer l'IA Générative : Un Guide pour les Leaders d'Entreprise

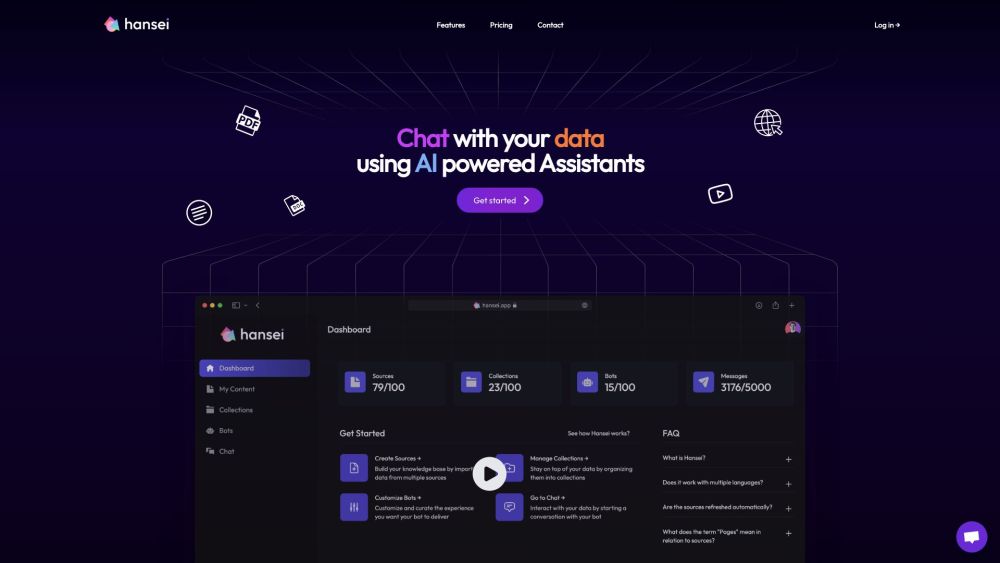

En tant que leader d'entreprise ou décideur informatique, vous avez probablement été submergé par les discussions sur l'IA générative. Si vous êtes prêt à mettre en place un chatbot basé sur un modèle de langage large (LLM) pour vos employés ou vos clients, une question cruciale se pose : comment le lancer et quels coûts devez-vous anticiper ?

Présentation de DeepInfra

DeepInfra, fondée par d'anciens ingénieurs d'IMO Messenger, vise à simplifier ce processus pour les leaders d'entreprise. La société propose de déployer des modèles sur des serveurs privés à un tarif compétitif de seulement 1 $ par million de tokens, nettement inférieur aux prix de GPT-4 Turbo d'OpenAI à 10 $ et de Claude 2 d'Anthropic à 11,02 $.

Récemment sortie de l'ombre, DeepInfra a annoncé un tour de financement d’amorçage de 8 millions de dollars dirigé par A.Capital et Felicis. Son objectif est de fournir une suite d'inférences de modèles open-source, y compris Llama 2 et CodeLlama de Meta, ainsi que des versions personnalisées de ces modèles.

La Proposition de Valeur de DeepInfra

Bien que l'accent soit souvent mis sur les ressources GPU nécessaires à l'entraînement des LLM, l'importance d'une puissance de calcul suffisante pour des performances fiables—appelée inférence—ne saurait être sous-estimée. Selon le PDG Nikola Borisov, le véritable défi réside dans la capacité à gérer efficacement plusieurs utilisateurs simultanés sur le même matériel.

"La clé est de gérer l'accès simultané de plusieurs utilisateurs au serveur. Chaque token produit par ces modèles nécessite une puissance de calcul et une bande passante mémoire considérables," explique Borisov. Pour garantir des performances optimales, les entreprises doivent se concentrer sur l'efficacité afin d'éviter de surcharger les serveurs avec des tâches de calcul redondantes.

Les fondateurs de DeepInfra s'appuient sur leur vaste expérience en gestion de flottes de serveurs à l'échelle mondiale pour relever ces défis efficacement.

Avis d'Investisseurs de Renom

Borisov et ses co-fondateurs ont été reconnus pour leur expertise en programmation. Aydin Senkut, entrepreneur renommé et partenaire gérant de Felicis, a salué leurs compétences, déclarant : "Ils ont une expérience incroyable, potentiellement juste derrière l'équipe de WhatsApp en matière de construction d'infrastructures efficaces servant des centaines de millions."

Cette efficacité infrastructurelle permet à DeepInfra d'offrir ses services à des coûts réduits, ce qui est attrayant dans un environnement où les entreprises font souvent face à des dépenses AI croissantes. Senkut souligne : "Si une entreprise peut réaliser un avantage de coût multiplié par 10 dans l'IA, elle peut perturber le marché de manière significative."

Ciblant les PME avec l'IA Open-Source

L'objectif initial de DeepInfra se concentre sur les petites et moyennes entreprises (PME) cherchant un accès abordable à des modèles de langage et d'apprentissage machine open-source à la pointe de la technologie. "Nos clients cibles veulent un accès fiable à des modèles de premier ordre sans se ruiner," déclare Borisov.

L'entreprise suit de près les avancées de la communauté IA open-source, prête à adopter de nouveaux modèles spécialisés pour diverses tâches, allant de la génération de texte à la vision par ordinateur et la programmation.

Borisov exprime sa conviction dans la croissance continue et la polyvalence des solutions open-source : "À mesure que des modèles comme Llama sont publiés, beaucoup créeront leurs variantes avec des exigences computationnelles minimales, alimentant ainsi un écosystème collaboratif."

Confidentialité et Sécurité

Le service d'hébergement d'inférence de DeepInfra séduit particulièrement les entreprises qui priorisent la confidentialité des données. "Nous ne stockons ni n'utilisons aucun prompt soumis ; ils sont supprimés une fois la session utilisateur terminée," assure Borisov, soulignant leur engagement envers la confidentialité.

En s'appuyant sur les services de DeepInfra, les entreprises peuvent naviguer efficacement et à moindre coût dans les complexités de l'adoption des solutions d'IA générative, veillant à rester compétitives dans un paysage en évolution rapide.