Stability AI lance un modèle linguistique compact et efficace de 1,6 milliard de paramètres : Une nouvelle ère d'innovation.

Most people like

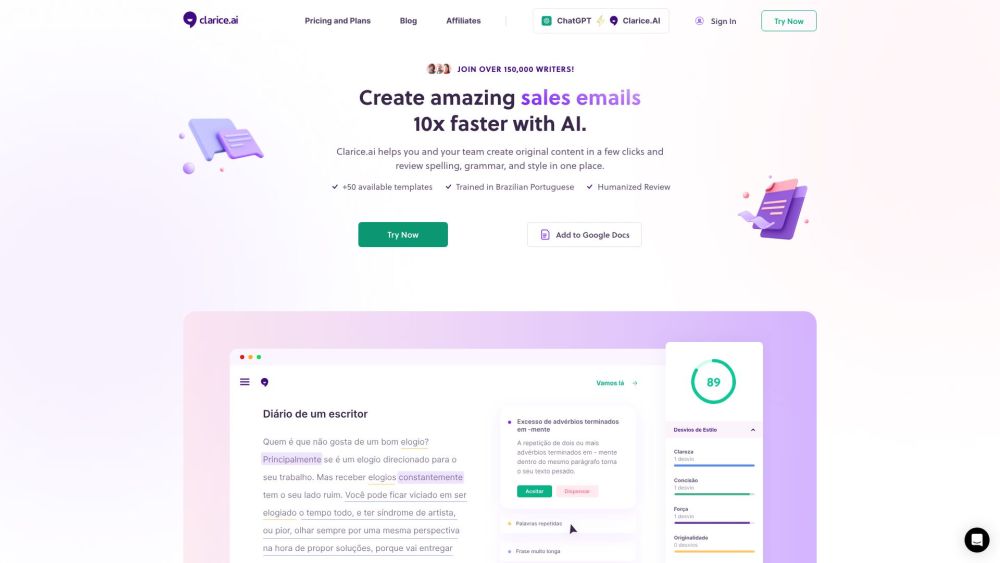

Libérez le potentiel de votre contenu avec notre assistant d'écriture IA, conçu pour améliorer votre efficacité rédactionnelle et la qualité de vos productions. Découvrez une création de contenu plus rapide et plus efficace qui captive votre audience et atteint vos objectifs sans effort.

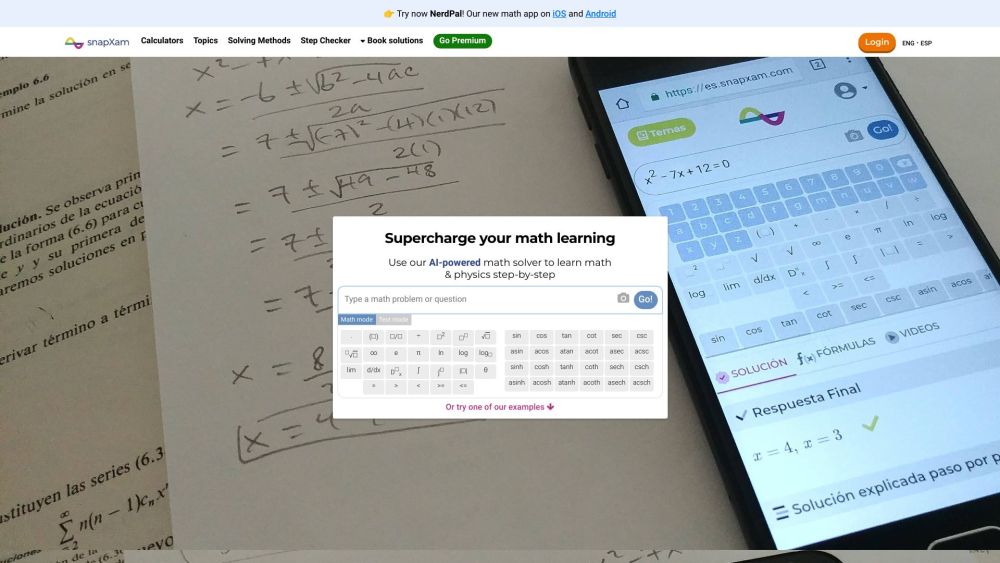

Présentation du Tuteur de Mathématiques et de Physique Alimenté par IA : Votre Compagnon d'Apprentissage Ultime

Débloquez tout votre potentiel en mathématiques et en physique grâce à notre plateforme de tutorat avancée alimentée par IA. Conçu pour offrir une assistance personnalisée, notre tuteur IA s'adapte à votre style d'apprentissage, vous aidant à maîtriser des concepts difficiles et à exceller dans vos études. Profitez de leçons sur mesure, de retours instantanés et de problèmes pratiques captivants qui facilitent la compréhension de sujets complexes. Découvrez l'avenir de l'éducation avec le tuteur alimenté par IA qui transforme votre façon d'apprendre les mathématiques et la physique !

Transformez votre Voix : Le Changeur de Voix Ultime pour le Gaming et le Streaming

Découvrez le changeur de voix parfait pour améliorer votre expérience de jeu et de streaming. Que vous souhaitiez divertir votre public, ajouter une couche d'anonymat ou simplement vous amuser, notre changeur de voix très apprécié rehausse votre performance et rend vos interactions captivantes. Avec une variété d'effets personnalisables et des fonctionnalités faciles à utiliser, vous pouvez créer des sons uniques qui correspondent à votre style de jeu ou à votre personnage de streamer. Explorez les possibilités infinies et passez à la vitesse supérieure avec votre contenu !

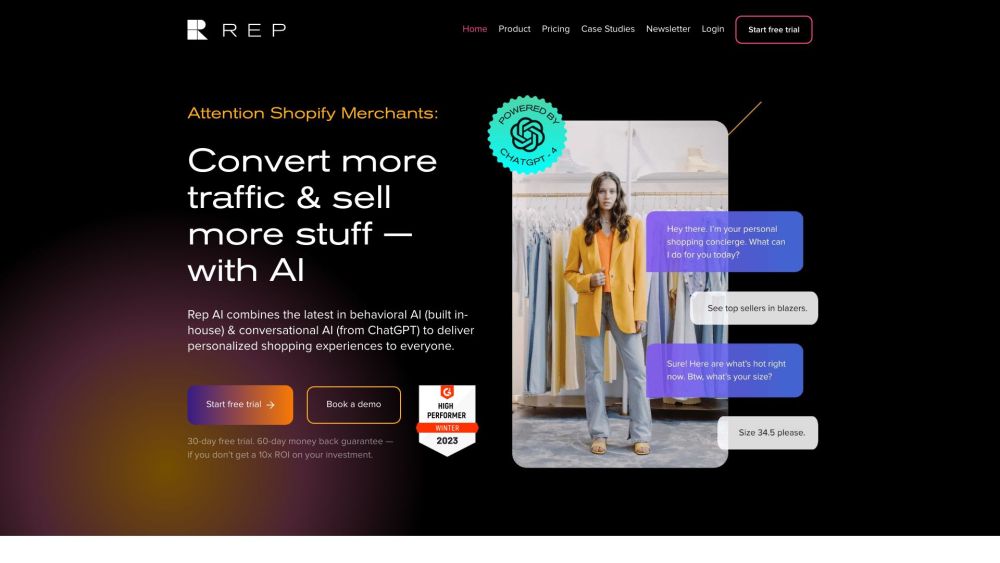

Découvrez Rep AI Home de Shopify—un chatbot IA de pointe conçu pour améliorer votre expérience de shopping en ligne. Grâce à sa capacité à offrir une assistance sur mesure, cet outil novateur garantit aux clients des recommandations et un soutien personnalisés, rendant le shopping plus engageant et efficace que jamais.

Find AI tools in YBX

Related Articles

Refresh Articles