GoogleのASPIREシステム: AIが「わからない」を受け入れることで透明性を向上させる仕組み

Most people like

あなたの個人的なAIチャットボット、Gita GPTをご紹介します。Gita GPTは、バガヴァット・ギーターからの霊的な洞察を提供します。Gita GPTと共に深い教えを探求し、あなたの質問に対する答えを見つけることで、霊的な旅を豊かにしましょう。

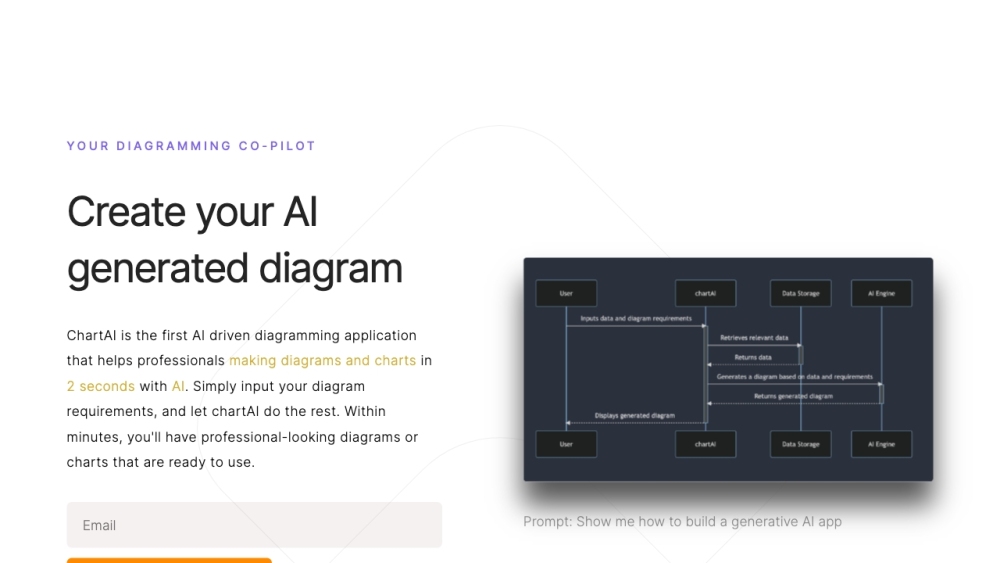

ChartAIは、ChatGPTの力を活用して、ユーザーがチャートや図を簡単に作成し解釈できるよう支援します。直感的な機能により、ChartAIは複雑なデータを視覚的に魅力的で理解しやすい表現に変換し、データ分析の体験を向上させます。

私たちの無料のオンラインAIマインドマッピングツールを発見してください。これは、ブレインストーミングセッションを強化し、創造性を高めるために設計されています。直感的な機能と高度なアルゴリズムを備えたこのツールは、あなたの考えやアイデアを視覚的に効果的に整理します。プロジェクトの計画、ストーリーのアウトライン作成、複雑なトピックの学習など、さまざまな場面で、マインドマッピングツールはプロセスを簡素化し、混沌とした考えを構造化された実行可能な計画に変えます。想像力の力を引き出し、使いやすいAI主導のプラットフォームで生産性を向上させましょう。

Find AI tools in YBX