研究者たちがMIT、Cohere for AI、その他11の機関とともに、本日、「データ出所プラットフォーム」を発表しました。これは、AIにおけるデータ透明性の重要な問題に対処するための取り組みです。

このイニシアティブでは、最も広く使用されている約2,000のファインチューニングデータセットを監査・追跡しました。これらのデータセットは合計で数千万回ダウンロードされ、多くの重要な自然言語処理(NLP)の突破口の基礎となっています。MITメディアラボの博士課程候補生シェイン・ロンプレ氏とCohere for AIの責任者サラ・フッカー氏は、「この学際的な努力の結果は、AIデータセットの最大の監査となりました」と述べています。これらのデータセットには、初めて、元データソース、再ライセンスの履歴、作成者、およびその他の関連情報を特定するタグが追加されました。

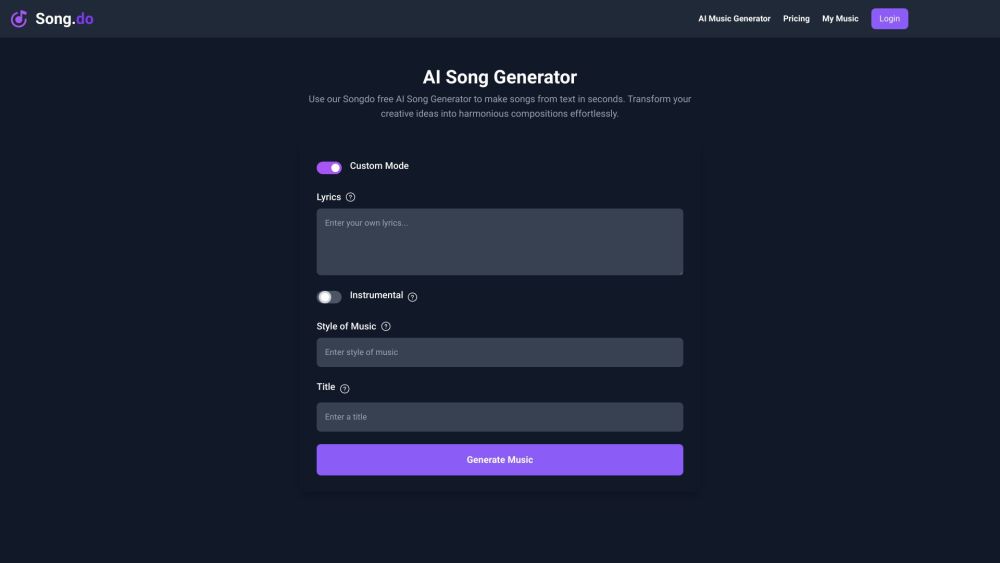

データ出所エクスプローラーというインタラクティブなプラットフォームを通じて、開発者は法的および倫理的基準に基づいて数千のデータセットを追跡し、フィルタリングできます。このリソースはまた、研究者やジャーナリストが人気のあるAIデータセットの構成と系譜を調査することを可能にします。

データセットコレクションの系譜を無視

このイニシアティブの成果として発表された論文「データ出所イニシアティブ:AIにおけるデータセットのライセンスと帰属の大規模監査」では、重要な懸念が指摘されています。「広く使用されるデータセットコレクションは、しばしば単一のものと見なされ、その多様な出所の系譜が認識されていません。これらのデータセットは、さまざまな関係者によって、多数の再パッケージやライセンス処理を経て収集あるいは生成され、整備され、注釈が付けられています。」

この系譜を認識しないことには、データ収集の膨大な規模が帰属プロセスを複雑にし、著作権に対する厳しい監視が関連しています。その結果、Datasheetsの使用が減少し、トレーニングソースに関する開示が欠如することにより、トレーニングデータの理解が低下しています。この知識のギャップは、トレーニングデータとテストデータセット間のデータ漏洩や、個人を特定できる情報(PII)の収集、意図しないバイアスや振る舞いを引き起こし、最終的には予測よりも低品質なモデルを生むリスクをもたらします。さらに、このようなギャップは、モデルのリリースとデータの利用条件との間での法的・倫理的リスクを引き起こします。データでのトレーニングは高コストであり、大部分が不可逆であるため、これらの課題は容易に解決できません。

2023年におけるトレーニングデータセットへの注目の高まり

2023年を通じて、メディアはデータ出所とトレーニングデータセットの透明性についての問題を取り上げています。たとえば、3月には、Lightning AIのCEOウィリアム・ファルコン氏がOpenAIのGPT-4に関する論文を「研究として偽装している」と批判し、その重要な詳細の欠如を指摘しました。この報告の「範囲と制限」セクションでは、GPT-4のような大規模モデルに関する競争的および安全上の懸念から、アーキテクチャ、データセットの構築、トレーニング方法に関する情報が除外されていることが明記されました。

9月には、生成AIトレーニングデータに関する著作権問題を詳しく分析した論文が発表されました。分散AI研究所(DAIR)の研究ディレクターアレックス・ハンナ博士は、生成AIの急速な普及がもたらす緊急の課題について述べ、同意なしに収集された著作権で保護されたコンテンツの使用に関する重大な懸念が喚起されていることを指摘しました。