NISTの新報告書が警鐘を鳴らす:急増するAI攻撃の脅威とは

Most people like

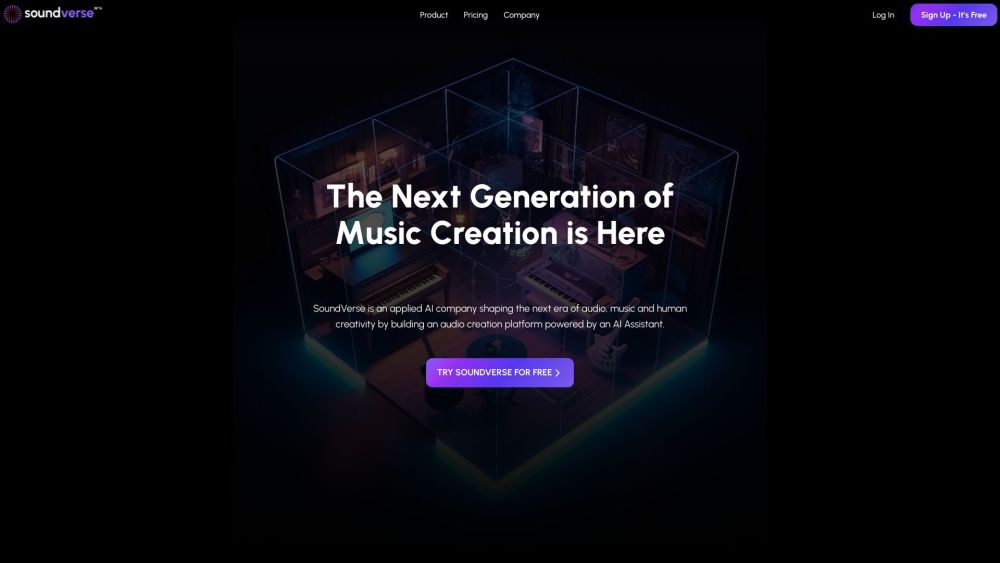

AI駆動の音声創作プラットフォームを紹介します。これは、音の制作方法を根本から変革します。最先端の技術を駆使して、ポッドキャスト、音楽、マーケティングなどさまざまな用途に向けて、高品質な音声を手軽に作成できます。創造的な可能性を引き出し、音声制作プロセスを効率化するために設計された革新的なツールで、ワークフローと最終出力を向上させましょう。音声の未来を今すぐ体験してください!

AI通訳、音声録音、ウイルス対策、年賀状作成に関する最良のソリューションをご紹介します。これらのツールは、日常生活やビジネスにおけるコミュニケーションの向上、データ保護、特別なイベントの準備に役立ちます。あなたのニーズに最適な解決策を見つけるために、ぜひご覧ください。

Find AI tools in YBX

Related Articles

Refresh Articles