Nvidia의 DGX SuperPOD: 조단위 파라미터 AI 모델을 지원하는 강력한 힘을 unleashing합니다.

Most people like

단 한 번의 클릭으로 쉽게 텍스트를 요약하세요! 직관적인 도구를 통해 긴 문서, 기사, 보고서를 주요 요점을 강조하는 간결한 요약으로 빠르게 압축할 수 있습니다. 독서 과정을 효율적으로 간소화하고 이해력을 저해하지 않으면서 귀중한 시간을 절약하세요. 학생, 직장인, 정보를 더 빠르게 파악하고 싶은 모든 이에게 적합합니다. 오늘부터 독서 경험을 변화시켜 보세요!

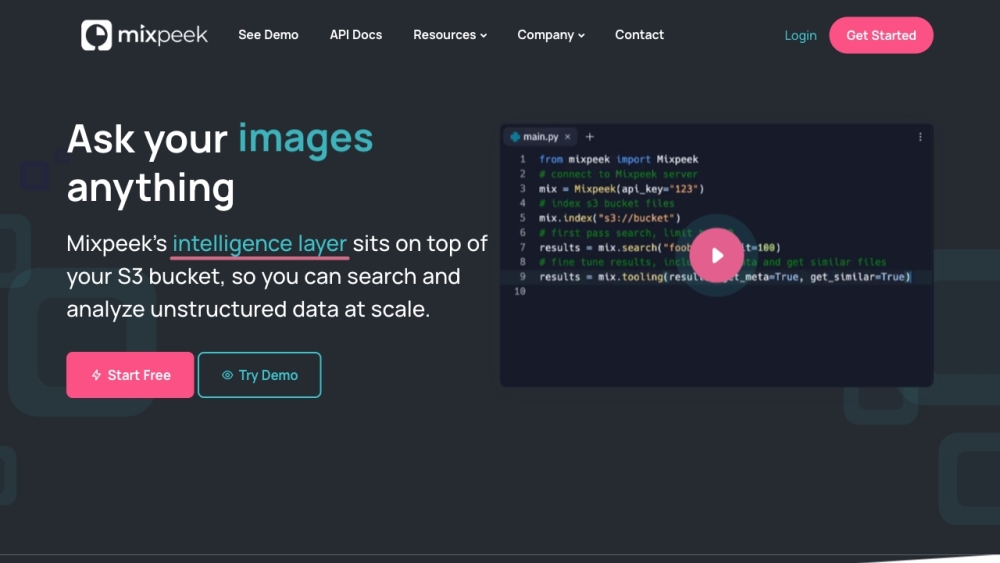

Mixpeek을 만나보세요: 강력한 검색 기능을 갖춘 첨단 지능형 파일 저장 솔루션입니다. 번개처럼 빠른 검색 기능으로 파일의 잠재력을 최대한 활용하고, 문서를 정리하고 찾는 과정을 그 어느 때보다 쉽게 만들어줍니다.

연구 과정을 혁신적으로 변화시키고 간소화하는 AI 플랫폼을 소개합니다. 인공지능의 힘을 활용하여 연구 역량을 향상시키고 비할 데 없는 효율성과 정확성을 경험하세요. 우리의 혁신적인 기술이 지식 탐구를 어떻게 지원할 수 있는지 알아보세요. 정보 수집을 그 어느 때보다 빠르고 효과적으로 만들어드립니다.

Find AI tools in YBX

Related Articles

Refresh Articles