Compreendendo a Incerteza da Lei de IA da UE: Perspectivas da Controvérsia da OpenAI

Most people like

Bem-vindo ao mundo do Gerador de Anime AI Gratuito, sua plataforma ideal para transformar ideias imaginativas em visuais de anime deslumbrantes. Seja você um artista em início de carreira, um criador experiente ou apenas um fã de anime, esta ferramenta oferece uma maneira simples de gerar personagens e cenas únicas. Mergulhe no fascinante universo da tecnologia de IA e deixe sua criatividade florescer com nossos recursos fáceis de usar, projetados para dar vida às suas visões de anime!

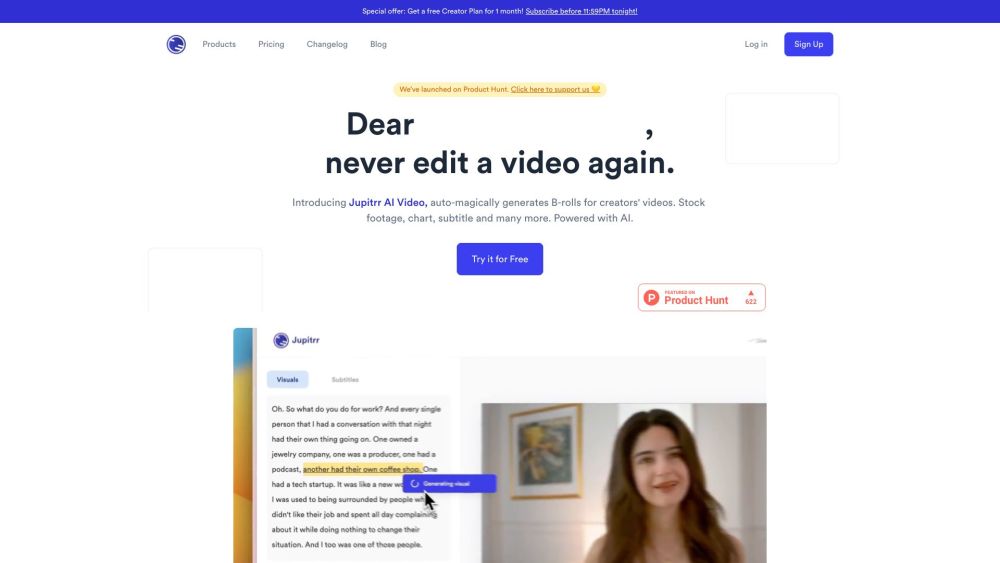

Crie facilmente impressionantes imagens B-roll com nosso criador de vídeos AI. Projetado para otimizar seu processo de produção, esta ferramenta inovadora gera automaticamente conteúdos B-roll de alta qualidade, economizando tempo e ampliando o impacto dos seus vídeos. Eleve sua narrativa e aumente o engajamento do público com a integração harmoniosa de visuais cativantes.

Apresentamos um aplicativo inovador de criação e interação com companheiros de IA, projetado para fortalecer a conexão humana. Esta plataforma de ponta permite que os usuários criem seus próprios companheiros virtuais, promovendo conversas envolventes e experiências personalizadas. Se você está em busca de um amigo, um mentor ou uma fonte de inspiração, este aplicativo desbloqueia infinitas possibilidades para interações significativas por meio de tecnologia avançada de IA. Junte-se a nós na exploração do futuro da companhia e da criatividade.

Find AI tools in YBX

Related Articles

Refresh Articles