Meta irá marcar conteúdo gerado por IA no Facebook, Instagram e Threads.

Most people like

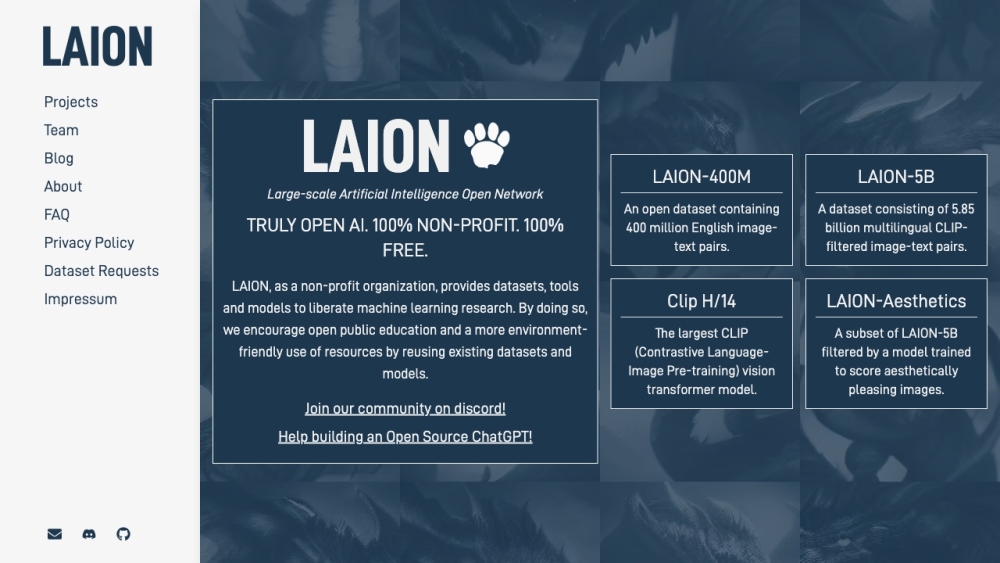

A LAION oferece recursos valiosos de aprendizado de máquina visando aprimorar a educação pública e facilitar a reutilização de recursos. Essa iniciativa apoia o compartilhamento de conhecimento e a acessibilidade, capacitando indivíduos e organizações a aproveitar de forma eficaz o potencial do aprendizado de máquina.

Apresentando nosso Escritor de Artigos Acadêmicos Movido por IA: A Ferramenta Definitiva para o Sucesso Acadêmico

No dinâmico cenário acadêmico atual, produzir artigos de pesquisa de alta qualidade pode ser uma tarefa desafiadora. Nosso escritor de artigos acadêmicos movido por IA foi desenvolvido para simplificar o processo de escrita, fornecendo conteúdos elaborados de forma profissional, adaptados às suas necessidades específicas. Seja você um estudante em busca de excelência ou um profissional querendo aumentar sua eficiência na escrita, nossa ferramenta inovadora combina inteligência artificial avançada e processamento de linguagem natural para entregar artigos bem pesquisados e articulados em pouco tempo. Vivencie o futuro da escrita acadêmica e eleve sua produção de pesquisa a um novo patamar!

Desbloqueie o poder da nossa ferramenta de IA inovadora, projetada para otimizar a análise de documentos e vídeos com eficiência incomparável. Aumente sua produtividade e obtenha insights ao navegar facilmente por grandes volumes de conteúdo, transformando dados complexos em conhecimento acessível com facilidade. Perfeita para empresas e pesquisadores, esta solução de ponta revoluciona a forma como você interage com a informação.

Find AI tools in YBX