Zuckerberg Revela o Desenvolvimento de AGI Open Source pela Meta

Most people like

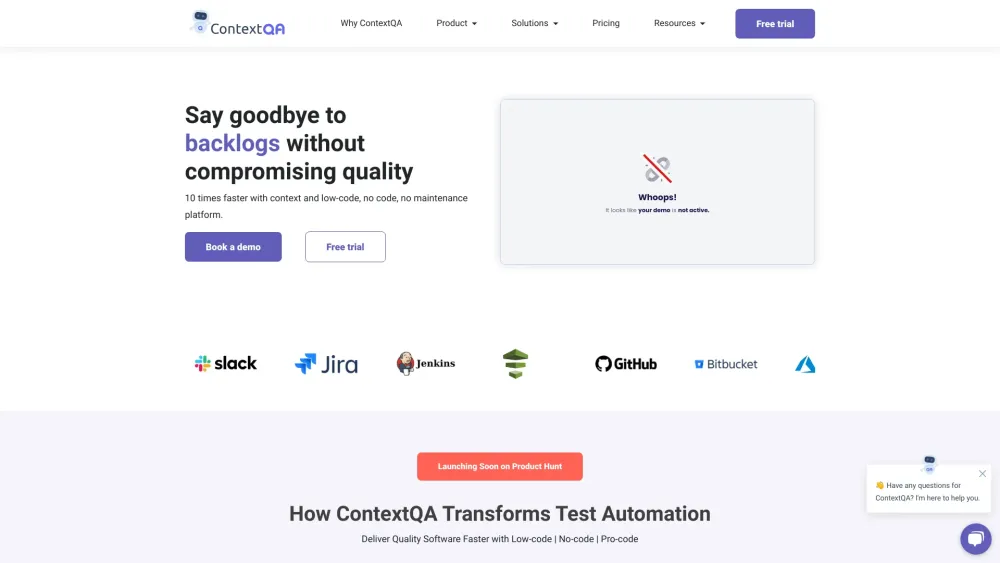

Otimize Seu Processo de Relatórios de Testes Manuais para Melhorar a Qualidade do Software

Descubra como a automação dos relatórios de testes manuais pode aumentar significativamente a qualidade do seu software. Ao eliminar tarefas tediosas e aumentar a eficiência, você poderá se concentrar mais no desenvolvimento de aplicações robustas e na entrega de experiências superiores aos usuários.

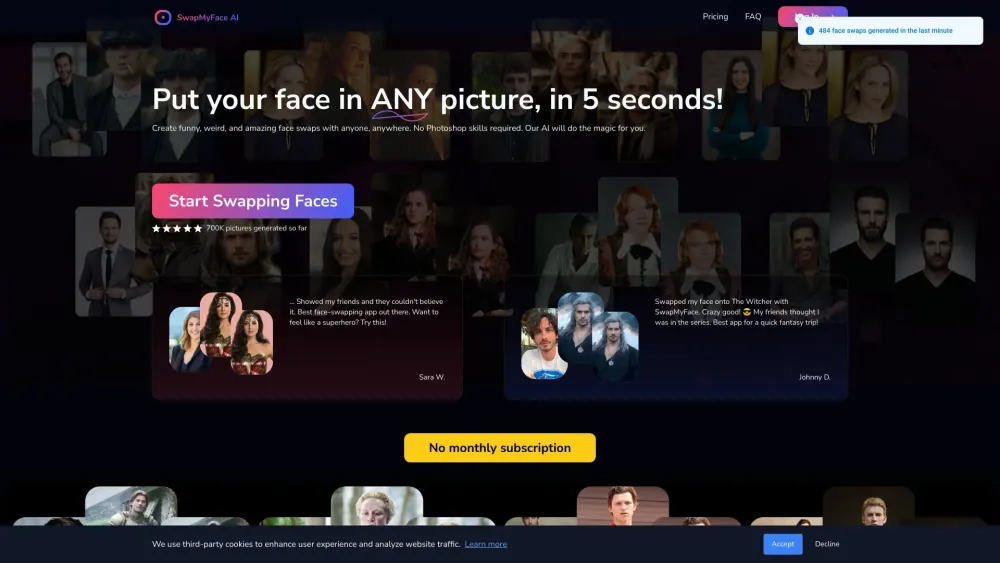

Descubra a ferramenta de troca de rostos com IA definitiva, projetada para transformar qualquer imagem com facilidade. Esta tecnologia inovadora permite que os usuários troquem rostos sem complicações, resultando em edições realistas e impecáveis. Se você está criando memes divertidos, melhorando suas postagens nas redes sociais ou experimentando projetos criativos, nossa ferramenta intuitiva simplifica o processo e oferece resultados impressionantes. Mergulhe e experimente a mágica da troca de rostos com IA hoje mesmo!

Find AI tools in YBX

Related Articles

Refresh Articles