人工智慧的未來:超越變壓器架構

目前,變壓器架構驅動著公私部門的主流人工智慧模型。未來將會如何?這一架構能否增強推理能力?接下來會有什麼創新?當前,實施人工智慧需要大量數據、GPU計算資源和專業人才,這使得開發和維護成為高成本的投資。

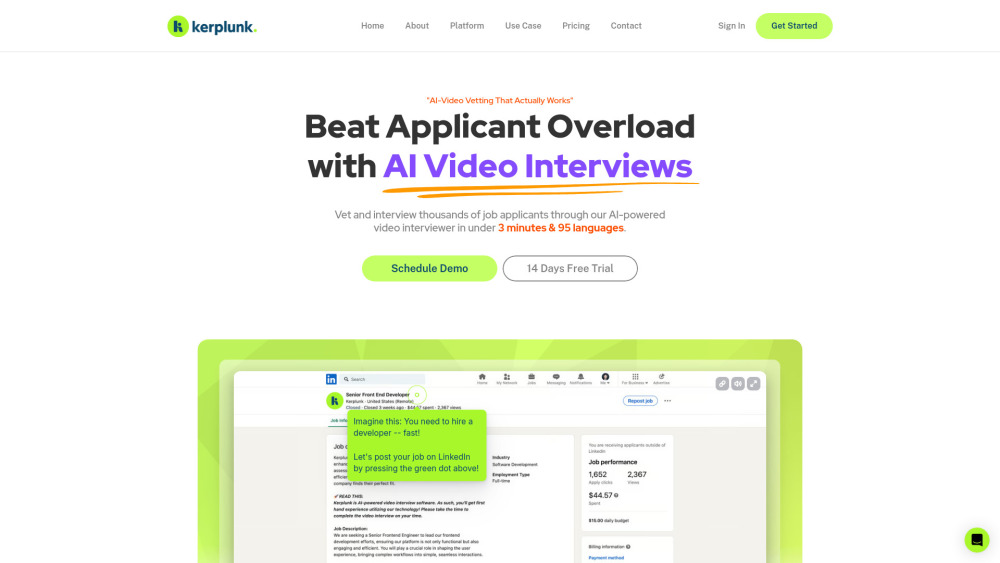

人工智慧的應用始於更智能的聊天機器人的問世。如今,新創企業和大型企業已經發展出能提升人類知識和技能的副駕駛助手。下一步的邏輯發展涉及將多步工作流程、記憶和個性化整合進能夠處理如銷售和工程等多樣任務的代理中。最終目標是使用者的提示能讓代理理解意圖,將任務分解為可行步驟並執行,無論是通過網絡搜索、多工具驗證,還是學習之前的行為。

想像一下個人化的人工智慧代理,就像數位的Jarvis,能直觀地在你的手機上管理任務。無論是訂票去夏威夷、訂購你最愛的餐點,還是管理個人財務,個性化代理的潛力令人期待。然而,從技術角度而言,我們還有很長的路要走。

變壓器架構是否已經到達盡頭?

變壓器中的自注意機制使模型能夠同時評估每個輸入標記的重要性,通過捕捉長距依賴性來增強對語言和計算機視覺的理解。然而,這種複雜性導致高內存消耗和緩慢的性能,尤其是在處理長序列(例如DNA)時。

為了解決這些挑戰,幾個研究計劃著手優化變壓器的性能:

1. 硬體改進:FlashAttention通過優化GPUs上不同內存類型之間的讀寫操作來提高變壓器的效率,從而減少數據傳輸。

2. 近似注意:研究致力於將自注意機制的O(n²)複雜度降低到線性範疇,以便更好地處理長序列。相關的方法包括Reformer和Performers。

除了這些優化外,替代模型也正在出現,挑戰變壓器的主導地位:

- 狀態空間模型(SSMs):這些模型類似於遞歸神經網絡和卷積神經網絡,能為長序列提供線性或接近線性的計算。儘管像Mamba這樣的SSMs能有效管理長距離關係,但它們在整體性能上仍低於變壓器。

最近的模型研究進展漸露曙光,並揭示出人工智慧技術不斷演變的趨勢。

重要模型發布

來自行業領導者的最新模型發布——OpenAI、Cohere、Anthropic和Mistral,尤其是Meta針對編譯器優化的基礎模型備受矚目。

除了傳統變壓器外,我們還見證了狀態空間模型的興起、結合SSMs和變壓器的混合模型、專家混合模型(MoE)和專家組合模型(CoE)。引人注目的幾個模型包括:

- Databricks的DBRX模型:這個MoE模型擁有1320億個參數,使用16位專家,在推理或訓練時僅啟用四位,具有32K的上下文窗口,並在12萬億個標記上進行訓練,前期訓練和精煉需要大量資源。

- SambaNova Systems的Samba CoE v0.2:該CoE模型由五個70億參數的專家組成,推理時僅啟動一位,性能快速,達到每秒330個標記。

- AI21 Labs的Jamba:這個混合模型結合了變壓器元素和Mamba的架構,提升了長上下文的處理能力,同時克服了傳統變壓器的限制。

企業採用挑戰

儘管最前沿模型充滿希望,企業仍面臨重大技術挑戰:

- 缺乏企業功能:目前許多模型缺乏角色基於的訪問控制(RBAC)和單一登入(SSO)等關鍵功能,限制了企業的準備度。組織正在特意分配預算來避免在技術領域落後。

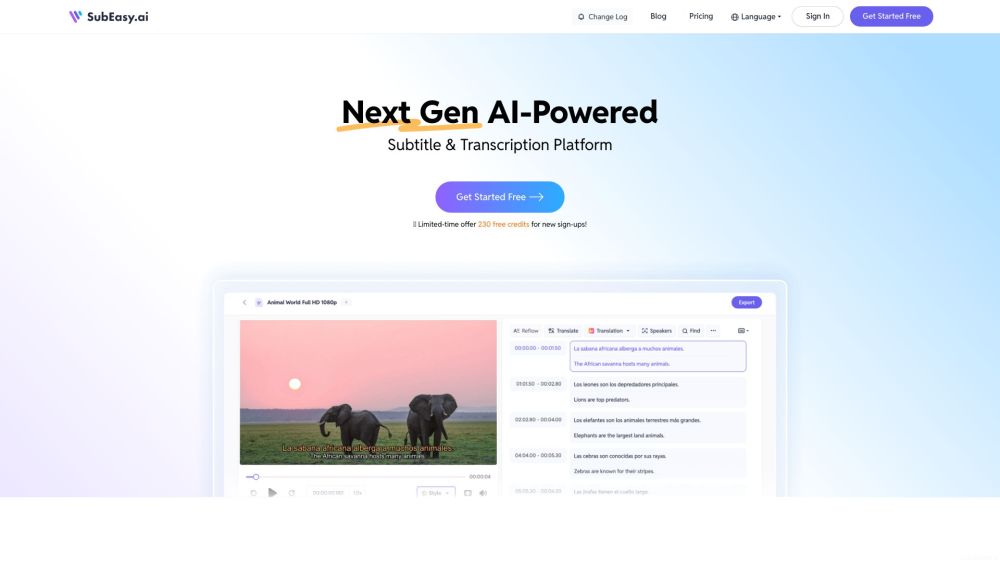

- 安全問題:新人工智慧功能可能使數據和應用安全變得複雜。例如,視訊會議工具可能推出AI轉錄功能,雖然有益,但在合規性方面特別需要進一步審查,尤其是在受監管行業中。

- 在RAG與微調之間選擇:檢索增強生成(RAG)確保事實準確,但可能未能像微調那樣有效提升模型質量,後者面臨過擬合的挑戰。隨著Cohere的Command R+推出,這是第一個在聊天機器人和企業工作流中超越GPT-4的開放權重模型,及時演變讓RAG成為首選。

我最近與一家大型金融機構的人工智慧領導者交談,他指出未來的趨勢不再是軟體工程師,而是擅長構建提示的人。通過簡單的草圖和多模態模型,非技術使用者能輕鬆創建應用,將工具的使用轉化為職業資產。

研究人員、從業者和創始人在追尋更高效、具成本效益且準確的模型的過程中,現在有各種架構可供探索。微調和新興的直接偏好優化(DPO)等技術提供了創新的新路徑。

隨著生成式人工智慧迅速發展,新創企業和開發者在優先事項上的選擇可能令其倍感壓力。未來為那些敢於創新和適應者提供了令人興奮的潛力。