مجلس إدارة OpenAI: مواجهة تحديات أمان الذكاء الاصطناعي والصراعات الداخلية | نبض الذكاء الاصطناعي

Most people like

في عصر الرقمية اليوم، تعمل النماذج الكبيرة المدعومة بالذكاء الاصطناعي على تغيير طريقة إبداعنا، خاصة في المجال الفني. تعتبر فنون الرسم بالذكاء الاصطناعي تطبيقاً مهماً لهذه التقنية، حيث لا تدفع فقط بالابتكار في الإبداع الفني، بل تعيد أيضاً تعريف دور الفنان. ستتناول هذه المقالة بعمق كيف تجعل هذه النماذج المتقدمة الإبداع الفني أكثر تنوعاً وخصوصية، بالإضافة إلى مناقشة التأثيرات الأخلاقية والاجتماعية التي تجلبها.

OpenL هو أداة متقدمة للترجمة مدفوعة بالذكاء الاصطناعي، مصممة لترجمة النصوص عبر اللغات بسهولة. استمتع بتجربة تواصل محسّنة مع حلولنا المبتكرة التي تكسر الحواجز اللغوية وتربط الناس في جميع أنحاء العالم.

أنشئ خطابًا واقعيًا وطبيعيًا بسهولة مع FakeYou، مستفيدًا من تكنولوجيا التزييف العميق المتقدمة. استمتع بتقنية توليد الصوت المتطورة التي تحول النص إلى صوت حي، مثالية لمجموعة متنوعة من التطبيقات.

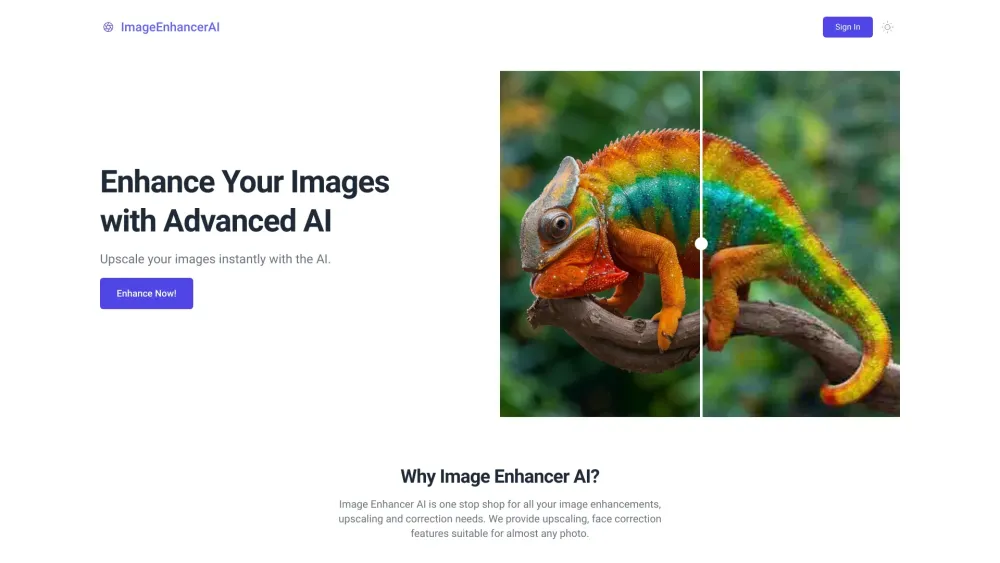

في المشهد الرقمي اليوم، تلعب الصور الجذابة دورًا حيويًا في جذب الانتباه ونقل الرسائل. إن تحسين الصور المدعوم بالذكاء الاصطناعي يحدث ثورة في كيفية تحسين وتطوير صورنا. من خلال الاستفادة من الخوارزميات المتقدمة وتقنيات تعلم الآلة، ترتقي هذه الأدوات بجودة الصور، وتستعيد التفاصيل، وتعزز الألوان، مما يضمن تميز مرئياتك. سواء كنت مصورًا أو مصممًا أو مسوقًا، فإن فهم تحسين الصور بالذكاء الاصطناعي يمكن أن يؤثر بشكل كبير على استراتيجية المحتوى المرئي لديك. اكتشف كيف يمكن لهذه التكنولوجيا المبتكرة تحويل صورك، مما يجعلها أكثر جاذبية وتأثيرًا.

Find AI tools in YBX

Related Articles

Refresh Articles