Meta AI presenta un modelo de lenguaje compacto optimizado para dispositivos móviles.

Most people like

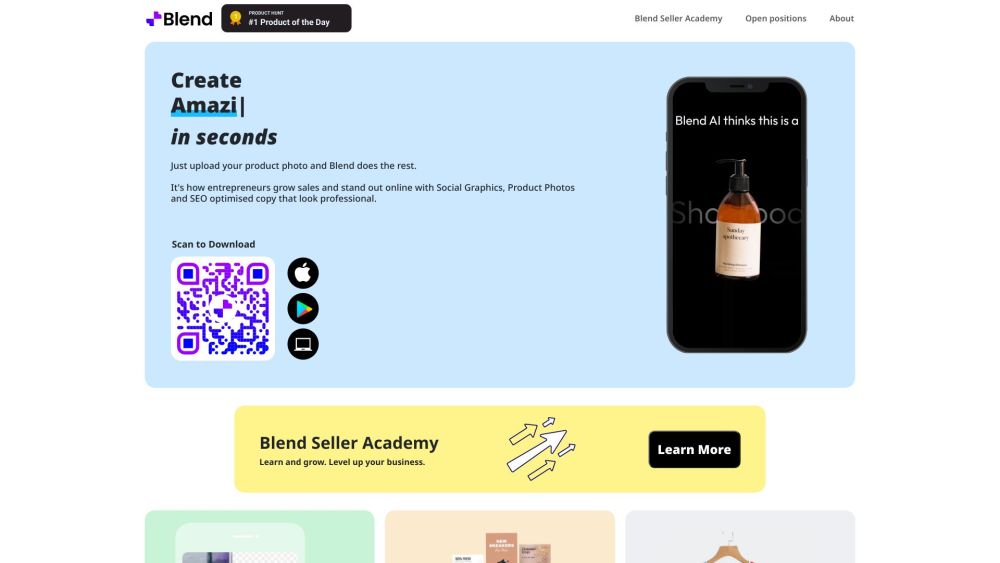

Experimenta el poder de la tecnología de IA con nuestra herramienta innovadora, diseñada para eliminar o cambiar fondos en fotos de manera sencilla. Transforma tus imágenes con precisión y facilidad, haciendo que tus visuales se destaquen.

Transforma tu texto en vibrantes imágenes PNG con fondos transparentes. Esta guía te llevará a través de los sencillos pasos para convertir cualquier texto en gráficos PNG elegantes y de alta calidad, perfectos para mejorar tus diseños web o presentaciones. ¡Aprovecha el poder de la transparencia y eleva tu contenido visual sin esfuerzo!

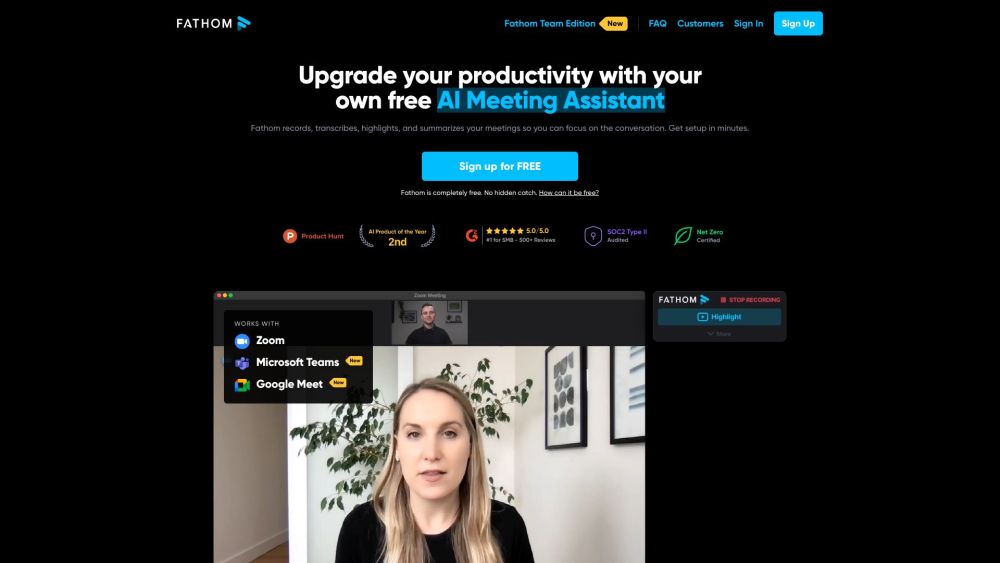

Presentamos Fathom: tu asistente de reuniones AI gratuito, diseñado para mejorar tu concentración durante videollamadas al eliminar la necesidad de tomar notas. Con Fathom, puedes participar plenamente en las discusiones mientras nuestro asistente inteligente captura todos los detalles importantes por ti.

Hama es una poderosa herramienta de IA diseñada específicamente para eliminar sin esfuerzo objetos y personas no deseados de tus fotos. Ya sea que estés mejorando recuerdos personales o creando visuales impactantes para proyectos, Hama simplifica el proceso de edición, haciendo que el retoque fotográfico sea simple y efectivo.

Find AI tools in YBX