Des chercheurs dévoilent le potentiel de ChatGPT.

Most people like

WordHero est un outil d'écriture IA avancé conçu pour vous aider à créer du contenu de haute qualité rapidement et sans effort.

Bienvenue sur notre plateforme innovante dédiée à la promotion de la créativité grâce au pouvoir des idées partagées. Ici, les utilisateurs peuvent explorer une vaste collection de suggestions créatives conçues pour inspirer écrivains, artistes et penseurs. En vous connectant à une communauté dynamique, vous découvrirez non seulement des suggestions uniques, mais aussi l'opportunité de partager les vôtres, enrichissant ainsi l'expérience créative de tous. Rejoignez-nous dès aujourd'hui pour libérer votre imagination et élever vos projets créatifs !

BuzzBoard est une plateforme de vente avancée alimentée par l'IA, conçue pour renforcer la confiance des représentants commerciaux et favoriser leur succès grâce à un contenu personnalisé.

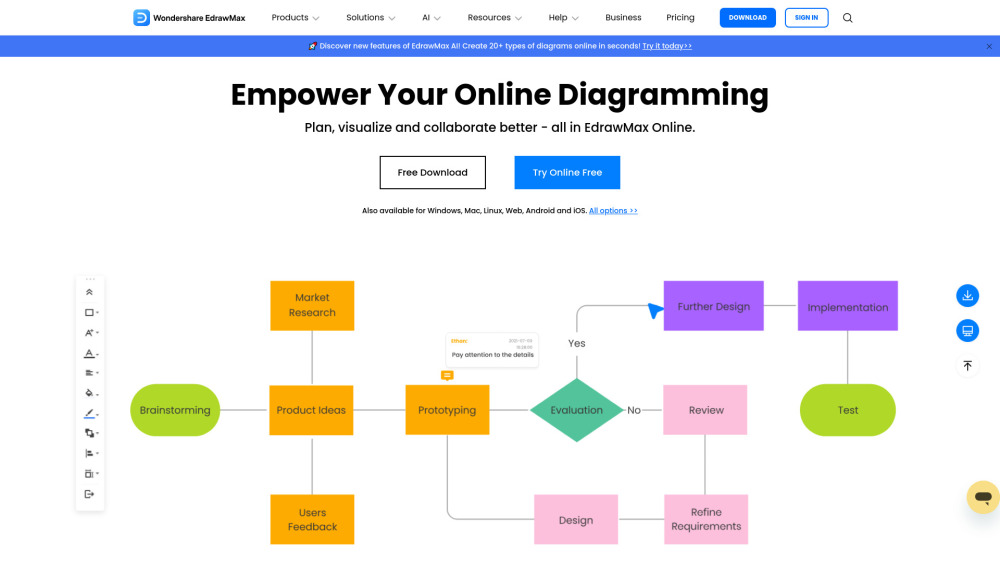

Créez des visuels époustouflants avec notre créateur de diagrammes en ligne

Élevez vos projets et présentations grâce à notre créateur de diagrammes en ligne intuitif. Concevez des visuels de qualité professionnelle sans effort, en utilisant des modèles personnalisables et des outils faciles à utiliser. Que vous ayez besoin de diagrammes de flux, de cartes heuristiques ou d'organigrammes, notre plateforme vous permet de communiquer vos idées de manière claire et efficace. Commencez à créer des diagrammes impressionnants dès aujourd'hui !

Find AI tools in YBX

Related Articles

Refresh Articles