차세대 오픈소스 AI 비전 모델이 ChatGPT에 도전: 고려해야 할 핵심 이슈

Most people like

워드튠은 글을 개선하기 위해 재작성 및 양식을 제안하는 지능형 AI 작문 도우미입니다. 고급 알고리즘을 통해 워드튠은 생각을 명확하고 효과적으로 표현할 수 있도록 도와줍니다.

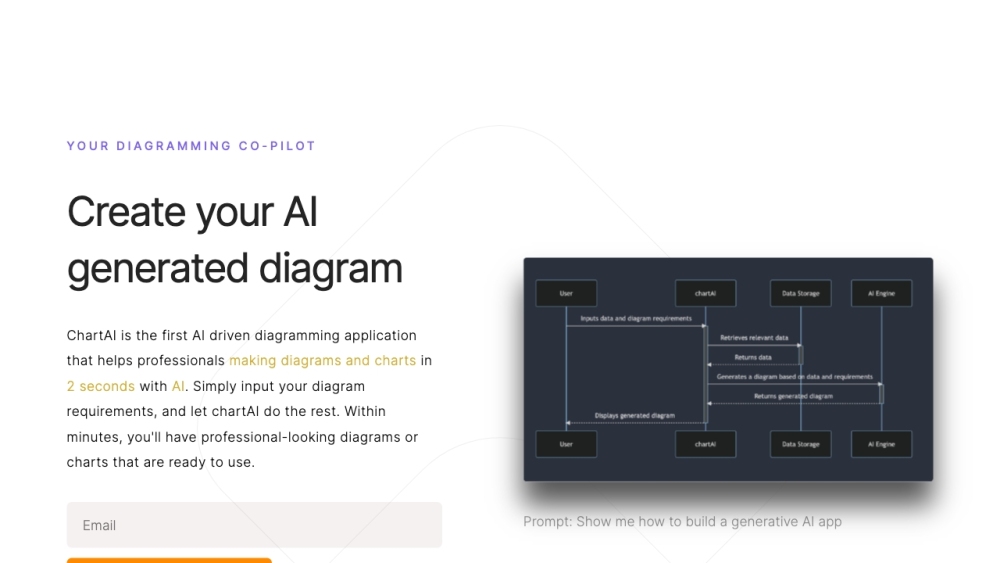

ChartAI는 ChatGPT의 힘을 활용하여 사용자가 차트와 도표를 손쉽게 생성하고 해석할 수 있도록 돕습니다. 직관적인 기능으로 ChartAI는 복잡한 데이터를 시각적으로 매력적이고 이해하기 쉬운 형태로 변환하여 데이터 분석 경험을 향상시킵니다.

당신의 청취 경험을 향상시키기 위해 설계된 궁극적인 개인화 AI 음악 동반자를 만나보세요. 이 혁신적인 도구는 당신의 독특한 취향에 맞춰 음악 추천을 조정하여 특별한 사운드트랙을 만들어줍니다. 첨단 알고리즘을 통해 선호도를 학습하고, 당신의 기분과 잘 어우러지는 맞춤형 재생 목록을 제공합니다. 모든 음이 당신의 vibe에 완벽하게 어울리도록 보장합니다. 음악의 미래를 받아들이고, 음악 여정에 따라 진화하는 AI 동반자와 함께 매세션을 독특한 경험으로 만들어보세요.

Find AI tools in YBX

Related Articles

Refresh Articles