Abacus AI, uma startup dedicada ao desenvolvimento de uma plataforma de machine learning (ML) e LLMOps impulsionada por IA, lançou um modelo de linguagem grande (LLM) open-source e sem censura chamado Liberated-Qwen1.5-72B. Este modelo é especificamente ajustado para seguir prompts do sistema, aumentando sua utilidade em aplicações do mundo real.

Baseado no modelo de linguagem somente de decodificador Qwen1.5-72B, criado por pesquisadores do Alibaba Group, o Liberated-Qwen1.5-72B se destaca pela sua capacidade otimizada de aderir a prompts do sistema, tornando-se mais adequado para diversos casos de uso, como chatbots voltados para atendimento ao cliente. Bindu Reddy, CEO da Abacus, descreve o modelo como o LLM sem censura mais eficaz do mundo em termos de desempenho e aderência às instruções do sistema.

Importância de Seguir Prompts do Sistema em LLMs

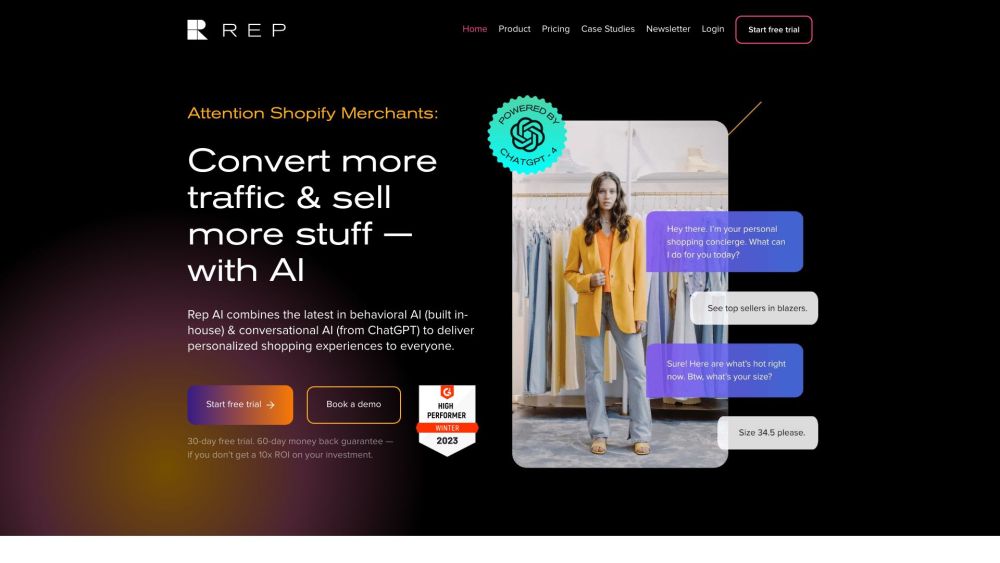

À medida que as empresas integram LLMs para tarefas como suporte ao cliente, é essencial manter o controle sobre as interações com a IA. Usuários muitas vezes se envolvem em conversas de múltiplas interações, e sem limitações adequadas, a IA pode desviar de seu papel destinado. Por exemplo, um usuário conseguiu enganar um chatbot, levando-o a aceitar uma oferta de $1 por um Chevy Tahoe de 2024, com a IA confirmando erroneamente o acordo como legalmente vinculativo.

Para evitar cenários indesejáveis como esse, é crucial garantir a conformidade rigorosa com os prompts do sistema. No entanto, muitos modelos open-source no mercado não conseguem manter esse nível de conformidade. A Abacus busca corrigir isso com o Liberated-Qwen1.5-72B.

A equipe de desenvolvimento ajustou o modelo utilizando um novo conjunto de dados open-source chamado SystemChat, que contém 7.000 conversas sintéticas geradas com Mistral-Medium e Dolphin-2.7-mixtral-8x7b. Esse treinamento permite que o modelo siga mensagens do sistema, mesmo quando elas conflitam com solicitações dos usuários durante as conversas. Reddy destaca no X: “Ajustar seu modelo com esse conjunto de dados o torna muito mais utilizável e difícil de quebrar!”

Insights de Desempenho

Testes realizados nos benchmarks MT-Bench e HumanEval mostram que o Liberated-Qwen1.5-72B superou levemente o anterior melhor modelo open-source, Qwen1.5-72B chat, com pontuações de 8.45000 contra 8.44375. No benchmark MMLU, que avalia conhecimento mundial e resolução de problemas, o modelo marcou 77.13—comparável a outros modelos de alto desempenho, incluindo Qwen1.5-72B e o Smaug-72B da Abacus.

É importante observar que, embora o Liberated-Qwen1.5-72B seja eficaz, ele permanece totalmente sem censura, sem proteções embutidas. Isso significa que ele responderá a todas as perguntas, incluindo tópicos sensíveis, enquanto ainda segue as mensagens do sistema. A Abacus orienta os usuários a implementar suas próprias camadas de alinhamento antes de implantar o modelo em qualquer contexto de serviço.

Atualmente, o Liberated-Qwen1.5-72B está disponível sob a licença tongyi-qianwen, que é quase equivalente à licença MIT. Reddy expressou planos de aprimorar ainda mais o modelo, especialmente para o HumanEval, e desenvolver modelos mais avançados ao combinar o conjunto de dados SystemChat com conjuntos de dados do Smaug.

Nas próximas semanas, a Abacus pretende refinar suas pontuações no MT-bench, aspirando à posição de topo no painel do HumanEval.