AI21 CEO表示,轉換器不適合用於AI代理,因為存在錯誤傳播問題。

Most people like

提升銷售表現,從KB: Smart Chat開始

釋放您的銷售團隊潛力,推動業績成長,選擇KB: Smart Chat。這款強大的工具旨在提升客戶互動,簡化溝通流程,最終實現銷售增長和顧客滿意度。了解如何運用KB: Smart Chat來改變您的銷售策略,助力業務成長!

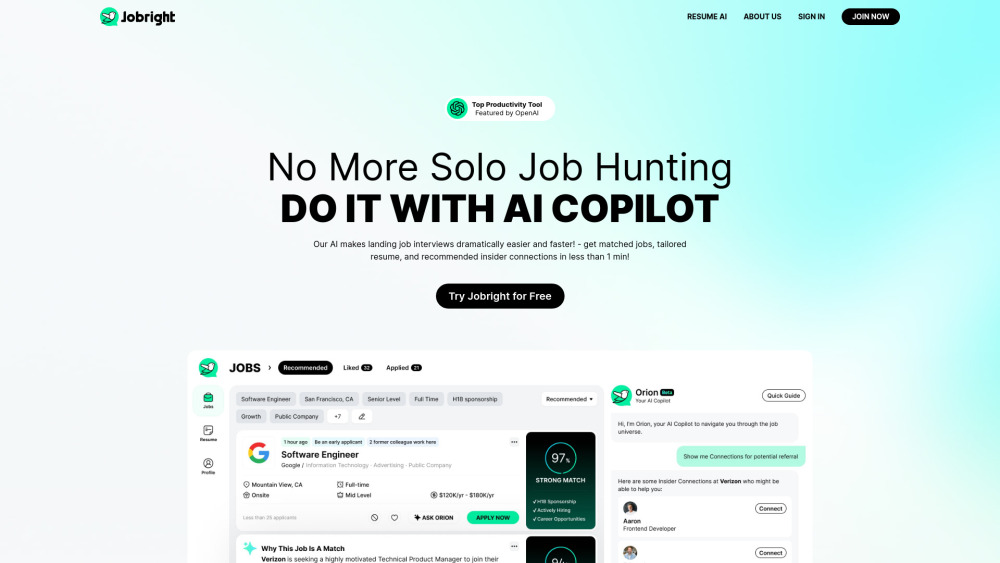

解鎖您的職業潛力,使用 AI 求職助手進行個性化職位匹配

在當今競爭激烈的求職市場中,找到合適的職位可能令人畏懼。引入 AI 求職助手:您的智益助手,旨在幫助您駕馭職場。通過分析您的技能、偏好和職業目標,這一創新工具提供與您的願景完美契合的個性化職位推薦。節省時間,簡化求職過程,通過個性化建議提高成功獲得理想工作的機會。

提升您的寫作技巧,享受AI增強的指導。探索人工智慧如何協助簡化您的寫作過程,提供個性化的反饋和建議,以改善清晰度、一致性和吸引力。無論您是撰寫論文的學生,還是準備報告的專業人士,我們的AI工具旨在在每一步支持您。立刻體驗未來的寫作輔助服務!

Find AI tools in YBX

Related Articles

Refresh Articles