Arize推出提示變數監控,識別AI模型失效的時機

Most people like

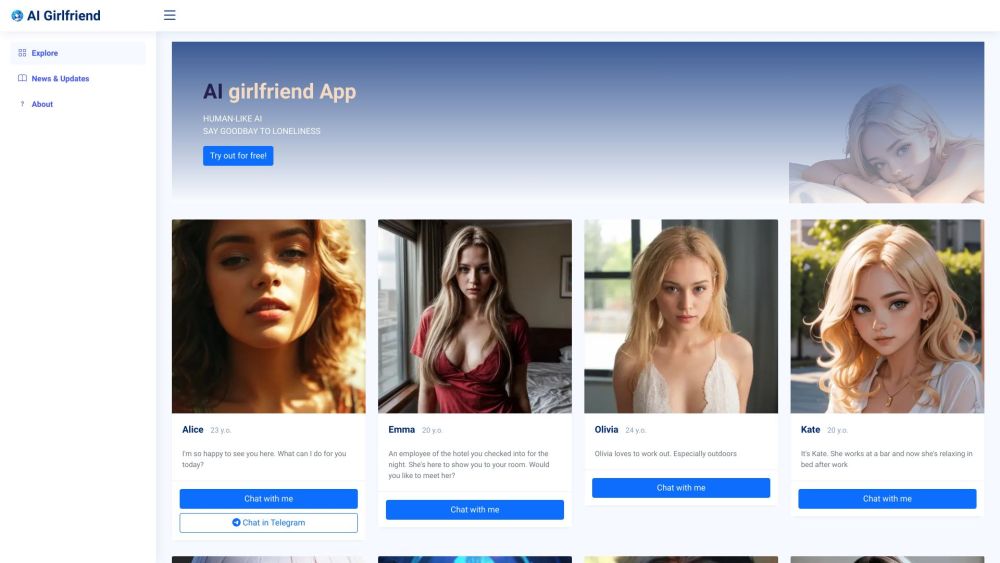

在當今快節奏的世界中,人工智慧助手能夠徹底改變您處理日常任務的方式。從管理日程到提供個性化建議,這些智能工具旨在提升您的生產力並簡化工作流程。擁抱人工智慧的力量,發現它如何在您應對眾多責任的同時簡化生活。探索量身打造以滿足您需求的人工智慧助手所帶來的無限可能。

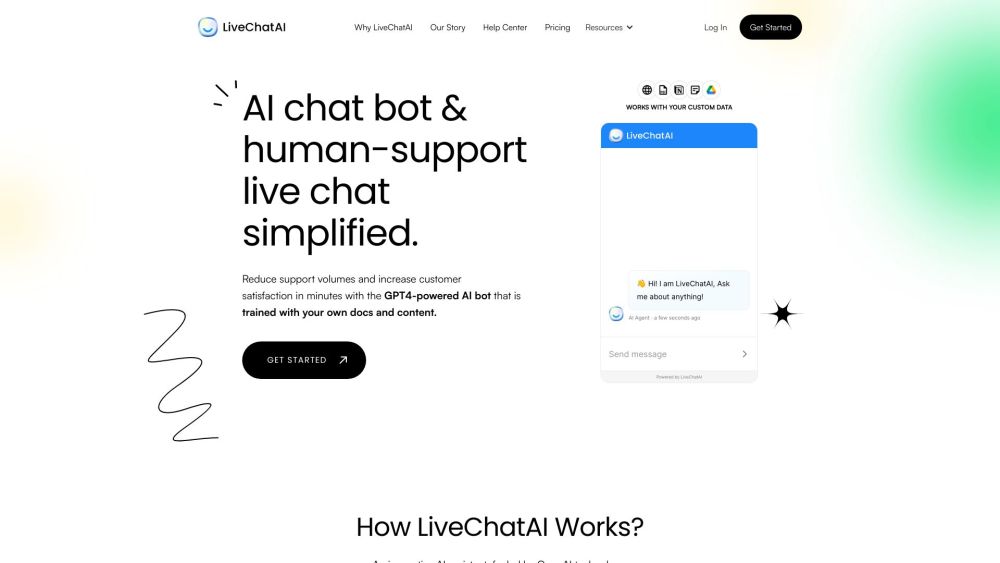

透過AI聊天機器人和即時聊天解決方案提升客戶支持體驗

在當今快速發展的數位環境中,提供卓越的客戶支持至關重要。透過整合AI聊天機器人和即時聊天選項,企業能夠簡化客戶服務運作,提供即時協助和個性化互動,從而提升滿意度和效率。了解這些創新工具如何改變您的支持策略,並提升客戶體驗。

Find AI tools in YBX

Related Articles

Refresh Articles