Transforme a Realidade em Fantasia: Live2Diff AI Estiliza Seus Vídeos Instantaneamente

Most people like

Crie logotipos distintivos com facilidade usando a inovadora plataforma impulsionada por IA da MakeLogoAI.

No panorama digital em rápida evolução de hoje, a interseção entre inteligência artificial (IA) e experiências imersivas está cativando um público cada vez maior. À medida que a tecnologia avança, a comunidade de IA está aproveitando ferramentas inovadoras para transformar a maneira como interagimos com nosso ambiente, aprimorando tanto o entretenimento quanto o aprendizado. Explorar essa fusão dinâmica não apenas destaca o potencial da IA, mas também revela seu papel na criação de experiências envolventes e imersivas que ressoam com os usuários. Junte-se a nós enquanto exploramos as maneiras pelas quais a IA está revolucionando nossa compreensão e interação com o mundo ao nosso redor.

Adicione rapidamente e sem esforço legendas e subtítulos aos seus vídeos online em apenas alguns minutos. Perfeito para melhorar a acessibilidade e o engajamento, nossa ferramenta facilita o alcance de um público mais amplo.

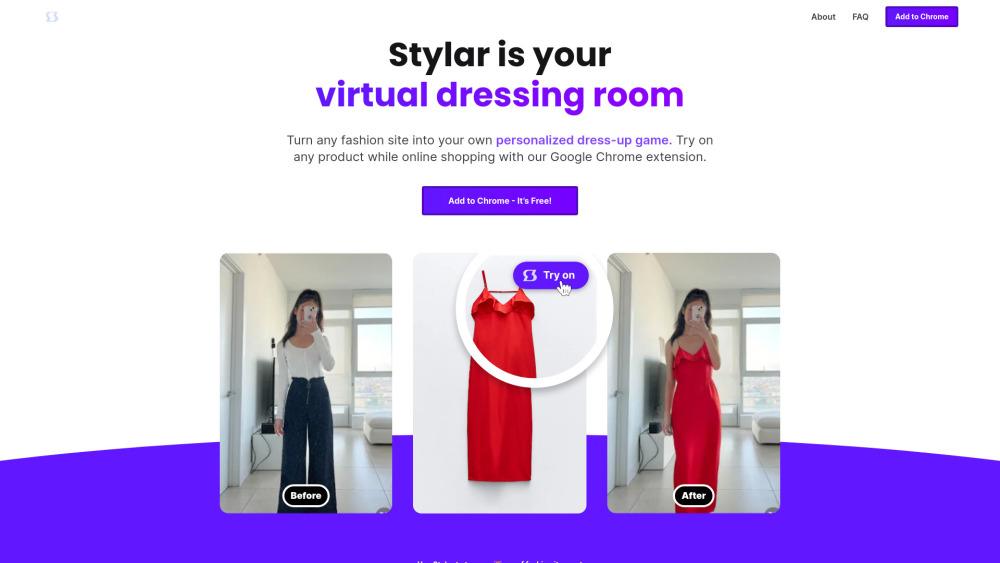

No mundo digital acelerado de hoje, o surgimento da inteligência artificial (IA) transformou a maneira como fazemos compras online, especialmente em relação a roupas. A tecnologia de provador virtual permite que os consumidores visualizem como as roupas ficariam neles sem sair de casa, aprimorando a experiência de compra. Essa solução inovadora está mudando a forma como as pessoas abordam a moda, tornando mais fácil e agradável encontrar o traje perfeito. Com os avanços em IA, os provadores virtuais estão se tornando ferramentas essenciais tanto para varejistas quanto para clientes, estreitando a distância entre as compras físicas e online.

Find AI tools in YBX

Related Articles

Refresh Articles