Торонтская AI-стартап-компания Cohere представила Embed V3, последнюю версию своей модели встраивания, оптимизированной для семантического поиска и приложений больших языковых моделей (LLM). Модели встраивания преобразуют данные в числовые представления, известные как «встраивания», которые становятся все более популярными с ростом использования LLM в корпоративных приложениях.

Embed V3 конкурирует с Ada от OpenAI и различными моделями с открытым исходным кодом, нацеливаясь на более высокую производительность и улучшенную компрессию данных. Эти улучшения предназначены для снижения операционных затрат на приложения LLM в сфере бизнеса.

Роль встраиваний в RAG

Встраивания играют ключевую роль в различных задачах, включая генерацию с увеличением извлечения (RAG), важное приложение LLM в корпоративной среде. RAG позволяет разработчикам предоставлять контекст LLM, извлекая информацию из источников, таких как руководства пользователя, истории чатов, статьи или документы, не входившие в оригинальный набор данных для обучения.

Чтобы использовать RAG, компании создают встраивания для своих документов и сохраняют их в векторной базе данных. Когда пользователь запрашивает модель, система AI вычисляет встраивание запроса и сравнивает его с сохранёнными встраиваниями, извлекая наиболее релевантные документы для улучшения контекста запроса.

Преодоление сложностей в корпоративном AI

RAG позволяет решить некоторые ограничения LLM, такие как отсутствие информации в реальном времени и склонность к генерации неточного контента, называемого «галлюцинациями». Тем не менее, поиск наиболее релевантных документов для запросов пользователей остаётся проблемой.

Предыдущие модели встраивания сталкивались с трудностями из-за шумных наборов данных, где нерелевантные документы могли занимать более высокие позиции из-за простого соответствия ключевым словам. Например, если пользователь ищет «симптомы COVID-19», старые модели могут отдать приоритет документу, который слабо упоминает этот термин, вместо того, чтобы представить документ, подробно описывающий конкретные симптомы.

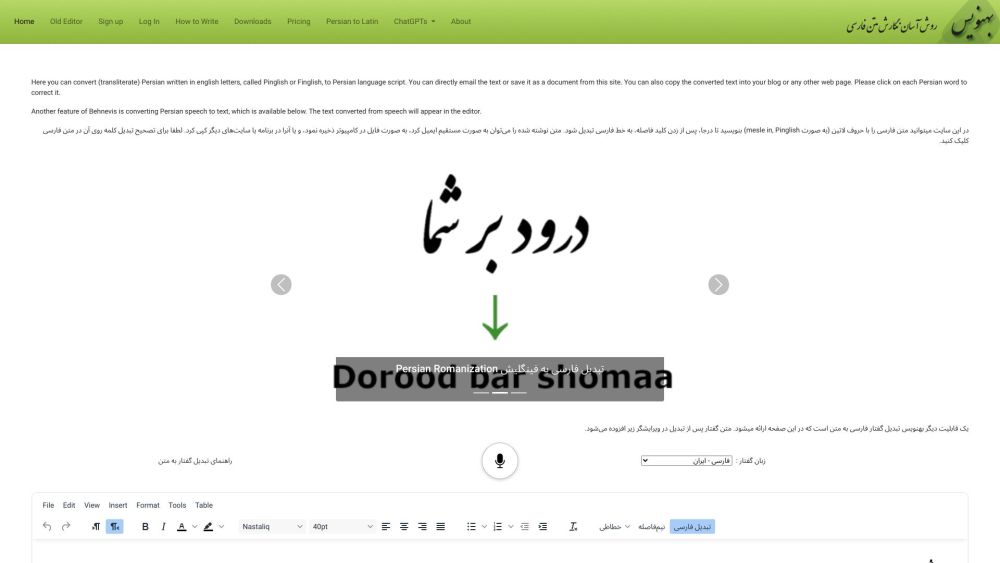

Cohere утверждает, что Embed V3 превосходит другие модели, включая ada-002 от OpenAI, по стандартным бенчмаркам производительности встраивания. Доступный в нескольких размерах, Embed V3 также включает многоязычную версию, которая сопоставляет запросы с документами на различных языках, что облегчает получение документов на нескольких языках, относящихся к запросам на английском.

Улучшение RAG с помощью продвинутых функций

Embed V3 показывает исключительную производительность в сложных случаях использования, включая многоступенчатые запросы RAG. Когда запрос пользователя включает несколько запросов, модель эффективно идентифицирует и извлекает релевантные документы для каждого, оптимизируя процесс.

Эта эффективность снижает необходимость в множественных запросах к векторной базе данных. Кроме того, Embed V3 улучшает повторную сортировку — функционал, который Cohere интегрировала в свой API — для более упорядочивания результатов поиска на основе семантической релевантности.

«Повторная сортировка особенно эффективна для сложных запросов и документов, поскольку традиционные модели встраивания могут сталкиваться с проблемами в таких сценариях», — объяснил представитель Cohere. «Однако для эффективной повторной сортировки начальный набор документов должен точно отражать наиболее релевантную информацию. Высококачественная модель, такая как Embed V3, обеспечивает, чтобы ни один релевантный документ не был упущен».

Более того, Embed V3 может значительно снизить затраты, связанные с управлением векторными базами данных. Трехступенчатый процесс обучения модели включал специализированный метод обучения с учётом компрессии. Как отметил представитель компании, «Расходы на поддержку векторной базы данных могут быть в 10-100 раз выше, чем на вычисление встраиваний. Наше обучение с учётом компрессии позволяет эффективно сжимать векторы».

Согласно блогу Cohere, этот этап компрессии оптимизирует модели для совместимости с различными методами компрессии, что значительно снижает затраты на векторные базы данных, сохраняя до 99.99% качества поиска.