Искусственный интеллект Orca-Math от Microsoft обеспечивает в 10 раз более высокую производительность по сравнению с большими моделями.

Most people like

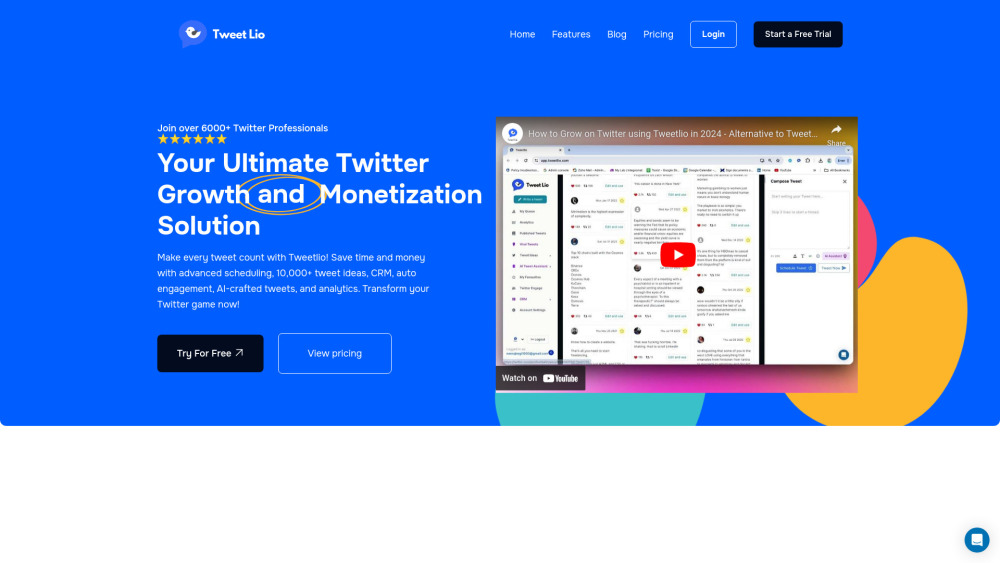

Откройте для себя уникальный инструмент ИИ, предназначенный для оптимизации вашего расписания в Twitter и повышения вовлеченности. Идеальное решение как для частных пользователей, так и для бизнеса — этот инновационный инструмент не только упорядочивает ваши публикации, но и оптимизирует их для максимального взаимодействия. Ощутите более умный способ общения в Twitter и поднимите свое онлайн-присутствие на новый уровень.

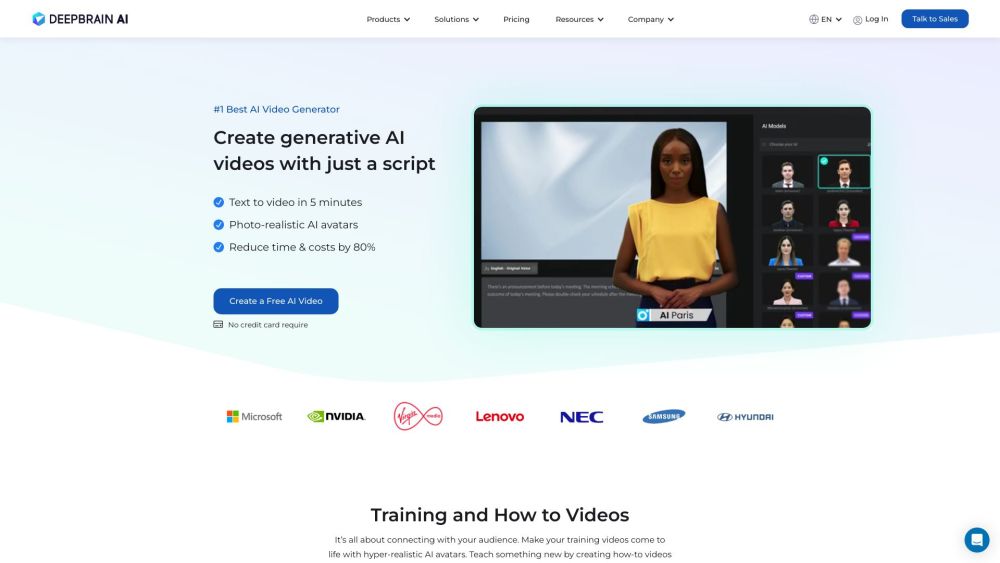

Откройте для себя DeepBrain AI — мощный видеогенератор, который оживляет ваши идеи с помощью реалистичных AI-аватаров.

Chatfuel, признанный официальным партнером API WhatsApp, предлагает мощную платформу для обмена сообщениями, разработанную для эффективного бизнес-общения. Раскройте потенциал упрощенных взаимодействий с клиентами и улучшите вовлеченность вашего бренда с помощью этого инновационного решения.

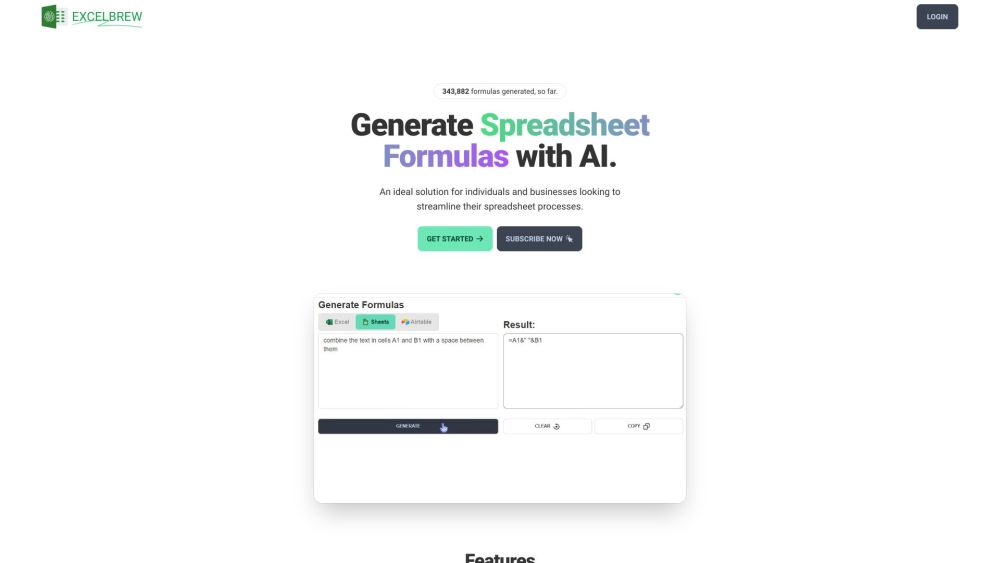

Откройте для себя возможности ИИ для легкого создания и объяснения формул в Excel и Google Sheets. Будь вы новичком или опытным пользователем, этот инструмент упрощает сложные вычисления, увеличивает вашу продуктивность и развивает навыки работы с электронными таблицами. Уверенно погружайтесь в мир управления данными и открывайте новые идеи!

Find AI tools in YBX

Related Articles

Refresh Articles